直击强化学习前沿,RL专场来袭丨AI Insight Talk直播预告

在知识爆炸、信息过载的时代,如何洞悉 AI 领域前沿趋势?OpenMMLab 联合 Hugging Face、ModelScope、知乎及机智流等重磅推出 AI Insight Talk

在知识爆炸、信息过载的时代,如何洞悉 AI 领域前沿趋势?OpenMMLab 联合 Hugging Face、ModelScope、知乎及机智流等重磅推出 AI Insight Talk,邀请「强化学习(RL)」「多模态」「AI4S」「Agent」「AI Infra」等领域的前沿项目作者,分享最新突破与深刻洞见,为开源社区持续呈献系列高价值专题盛会!

首场 AI Insight Talk——Hugging Face Papers Live RL 强化学习专场将于北京时间 6 月 14 日(周六)上午 10 点盛大开启,欢迎点击下方按钮预约直播。

魔搭ModelScope社区

分享嘉宾及主题介绍

No.1

零人工数据强化学习推理模型

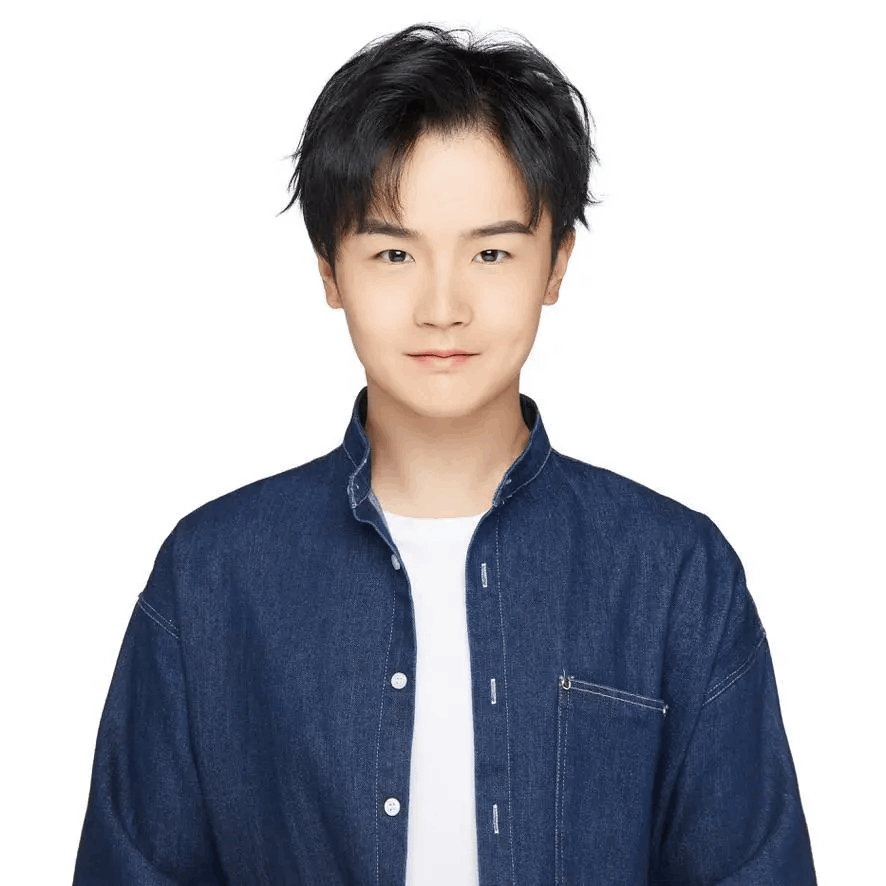

赵启晨

清华大学自动化系博士生四年级,研究方向是强化学习以及推理模型,其研究成果涉及大语言模型后训练、应用等多个方面。目前发表/在投 15 篇论文,其中多数发表在 NIPS、AAAI、ACL 等顶级会议上、长期担任 NIPS、ICLR、ICML 等顶会审稿人。在 GitHub 上共获得 1500 个 stars,并且被国内外知名机构使用。

简要概述

我们提出了一种全新的强化学习方法——Absolute Zero,它让语言模型在没有任何外部数据的情况下,自主提出学习任务并通过解决这些任务来提升推理能力。这种方法不再依赖人工制作的大量题目和答案,而是通过环境来验证任务和答案的正确性,从而提供可靠的学习反馈。我们设计的系统 Absolute Zero Reasoner 可以自主进化自己的训练内容和推理能力。尽管 AZR 完全没有使用外部数据,它在编程和数学推理任务上仍然达到了当前最先进的性能,超过了那些依赖大量人工数据的模型。我们还发现 AZR 适用于不同规模和类型的模型,具有良好的通用性和可扩展性。

论文地址

https://huggingface.co/papers/2505.03335

模型链接:

https://modelscope.cn/models/bartowski/andrewzh_Absolute_Zero_Reasoner-Coder-14b-GGUF

项目链接

https://github.com/LeapLabTHU/Absolute-Zero-Reasoner

No.2

小米 MiMo-VL 预训练及后训练技术分享

任抒怀

北京大学计算机学院博士生五年级,研究方向为多模态基座模型、理解生成统一等。目前已在 CVPR,ACL,NeurIPS 等国际顶级会议上以第一作者身份发表多篇论文。谷歌学术引用超过 2300。获国家奖学金、北京大学优秀毕业生、NeurIPS scholar、ACL 杰出审稿人等称号。

简要概述

MiMo-VL 是小米大模型 Core 组全新发布的视觉语言旗舰模型,包括预训练模型 MiMo-VL-7B-SFT 和后训练模型MiMo-VL-7B-RL。MiMo-VL-7B 在图片、视频、语言的通用理解和问答任务上,大幅领先同尺寸标杆模型 Qwen2.5-VL-7B,并且在 GUI Grounding 任务上比肩专用模型 UI-TARS。同时,在多模态推理任务上,如奥林匹克竞赛(OlympiadBench)和多个数学竞赛(MathVision、MathVerse),MiMo-VL 仅用 7B 参数规模,大幅领先 10 倍参数的阿里 Qwen-2.5-VL-72B 和 QVQ-72B-Preview,也超越了闭源模型 GPT-4o。在 MiMo-VL 预训练阶段,我们精心构建了长推理数据合成管线,合成了大量高质量、广覆盖的长推理数据,大幅提升了模型的思考能力。在后训练阶段,我们实现了多任务混合强化学习,进一步提升模型推理、感知性能和用户体验。

论文地址

https://huggingface.co/papers/2506.03569

项目链接

https://github.com/XiaomiMiMo/MiMo-VL

模型链接:

https://modelscope.cn/models/XiaomiMiMo/MiMo-VL-7B-RL

评测框架

https://github.com/XiaomiMiMo/lmms-eval

No.3

强化学习范式 OREAL:超越蒸馏,推动轻中量级模型突破推理“三重门”困局

顾宇喆

上海人工智能实验室联培博士生,研究方向是大模型的可拓展监督技术,聚焦于知识和推理能力增强。已在 NeurIPS,ICLR,ACL 等国际顶级会议上发表多篇论文,谷歌学术引用量 600+,担任 NeurIPS 等顶级会议审稿人。其参与了“书生通用大模型体系”的构建与研发,作为核心成员开发了包括 InternLM、InternThinker 等项目。

简要概述

在数学推理方面,长期以来,大模型面临稀疏奖励困境、局部正确陷阱和规模依赖魔咒"三重门"困局。我们重新聚焦推理任务,设计出以正确样本模仿学习、错误样本偏好学习为核心的强化学习范式。实验结果表明,以 Qwen2.5-32B-Base 为基座模型,仅通过微调和基于结果反馈的强化学习,在不蒸馏超大模型的情况下,即实现在 MATH-500 数据集上的 SOTA 性能。

论文地址

https://huggingface.co/papers/2502.06781

项目链接

https://github.com/InternLM/OREAL

RL 训练数据链接

https://huggingface.co/datasets/internlm/OREAL-RL-Prompts

https://modelscope.cn/datasets/Shanghai_AI_Laboratory/OREAL-RL-Prompts

系列模型地址

https://huggingface.co/collections/internlm/oreal-67aaccf5a8192c1ba3cff018

https://modelscope.cn/models/Shanghai_AI_Laboratory/OREAL-7B

https://modelscope.cn/models/Shanghai_AI_Laboratory/OREAL-32B

No.4

圆桌讨论环节

讨论主题:RL 强化学习发展趋势洞见

欢迎在公众号评论区留下您对 RL 强化学习趋势的疑问或期待,直播当天,主持人将精选问题与嘉宾深入互动,带来最前沿的洞见!

参与方式

观看直播

魔搭ModelScope社区

参与讨论

同时为了方便大家交流沟通,我们建立了相关的交流群,本期分享的大佬也在群里哦,可与大佬进行面对面沟通 ,扫码即可入群~

期待与您相约 6 月 14 日(周六)上午 10 点 的 AI Insight Talk:Hugging Face Papers Live RL 强化学习专场,一起探索前沿科技,共享 AI 盛宴!

更多推荐

已为社区贡献649条内容

已为社区贡献649条内容

所有评论(0)