MaskGCT:登上GitHub趋势榜榜首的TTS开源大模型

近日,香港中文大学(深圳)联手趣丸科技推出了新一代大规模声音克隆TTS模型——MaskGCT。一起看看该模型的一些表现吧!

01前言

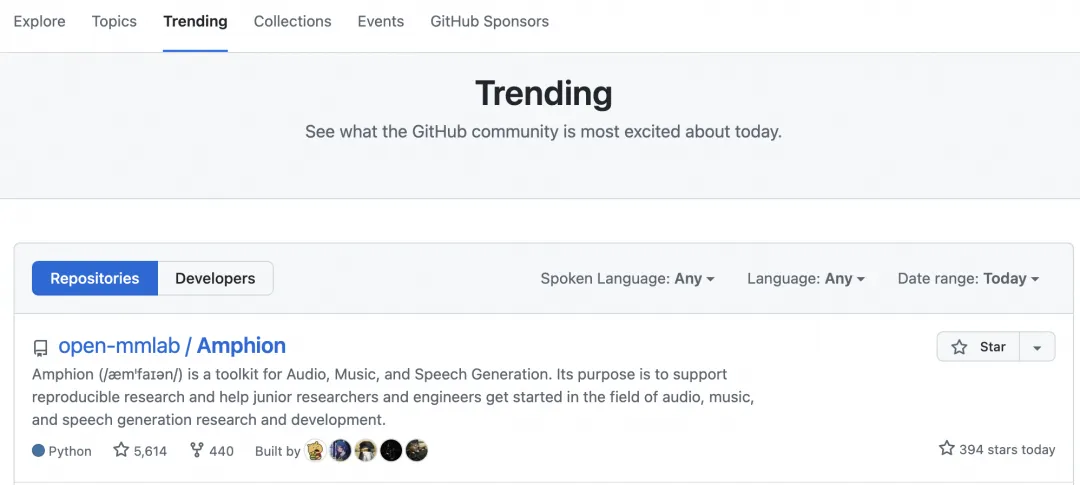

近日,香港中文大学(深圳)联手趣丸科技推出了新一代大规模声音克隆TTS模型——MaskGCT。该模型在包含10万小时多语言数据的Emilia数据集上进行训练,展现出超自然的语音克隆、风格迁移以及跨语种生成能力,同时保持了较强的稳定性。MaskGCT已在香港中文大学(深圳)与上海人工智能实验室联合开发的开源系统Amphion发布,Amphion今天登上了Github global trending榜首!

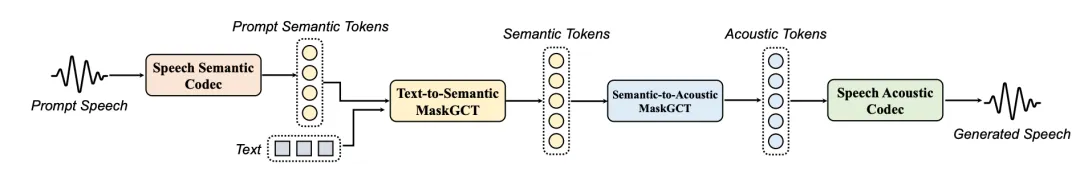

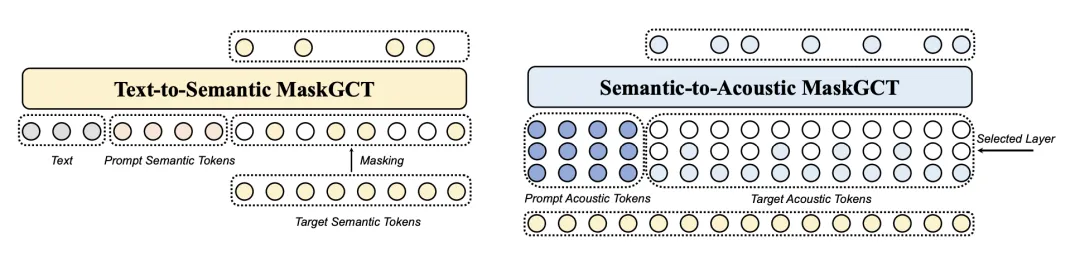

现有大规模文本到语音(TTS)系统通常分为自回归和非自回归系统。自回归系统隐式地建模持续时间,但在鲁棒性和持续时间可控性方面存在一定缺陷。非自回归系统在训练过程中需要显式的文本与语音对齐信息,并预测语言单元(如音素)的持续时间,这可能会影响其自然度。本文介绍了一种名为Masked Generative Codec Transformer(MaskGCT)的全非自回归TTS模型,该模型消除了文本与语音监督之间的显式对齐需求,以及音素级持续时间预测。MaskGCT是一个两阶段模型:在第一阶段,模型使用文本预测从语音自监督学习(SSL)模型中提取的语义标记;在第二阶段,模型基于这些语义标记预测声学标记。MaskGCT遵循掩码预测学习范式。在训练过程中,MaskGCT学习根据给定的条件和提示预测掩码的语义或声学标记。在推理过程中,模型以并行方式生成指定长度的标记。通过对10万小时的自然语音进行实验,结果表明MaskGCT在质量、相似度和可理解性等方面是业内领先的零样本TTS系统。

02方法

MaskGCT模型由四个主要组件组成:

-

语音语义表示编解码器:将语音转换为语义标记。

-

语音声学编解码器:从声学标记重建波形。

-

文本到语义模型:使用文本和提示语义标记预测语义标记。

-

语义到声学模型:基于语义标记预测声学标记。

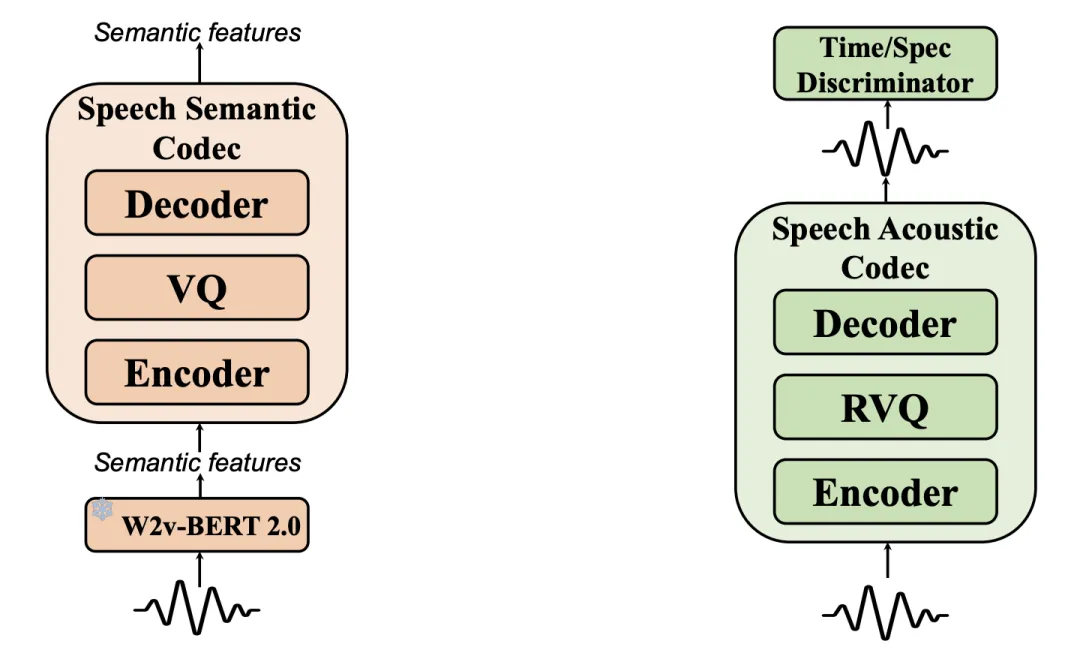

语音语义表示编解码器用于将语音转换为离散的语义标记,这些标记通常通过离散化来自语音自监督学习(SSL)模型的特征获得。与以往使用k-means方法离散化语义特征相比,这种方法可能导致信息损失,从而影响高质量语音的重建或声学标记的精确预测,尤其是在音调丰富的语言中。为了最小化信息损失,本文训练了一个VQ-VAE模型来学习一个向量量化码本,该码本能够从语音SSL模型中重建语音语义表示。具体来说,使用W2v-BERT 2.0模型的第17层隐藏状态作为语音编码器的语义特征,编码器和解码器由多个ConvNext块组成。通过改进的VQ-GAN和DAC方法,使用因子分解码将编码器输出投影到低维潜在变量空间。

语音声学编解码器旨在将语音波形量化为多层离散标记,同时尽可能保留语音的所有信息。本文采用残差向量量化(Residual Vector Quantization, RVQ)方法,将24K采样率的语音波形压缩为12层的离散标记。此外,模型使用Vocos架构作为解码器,以提高训练和推理效率。

文本到语义模型采用非自回归掩码生成Transformer,而不使用自回归模型或任何文本到语音的对齐信息。在训练过程中,我们随机提取语义标记序列的前缀部分作为提示,以利用语言模型的上下文学习能力。我们使用Llama风格的Transformer作为模型的主干,结合门控线性单元(GLU)和GELU激活函数、旋转位置编码等,但将因果注意力替换为双向注意力。还使用了接受时间步t作为条件的自适应RMSNorm。在推理过程中,我们生成任意指定长度的目标语义标记序列,条件是文本和提示语义标记序列。本文还训练了一个基于流匹配的持续时间预测模型,以预测基于文本和提示语音持续时间的总持续时间,利用上下文学习。

语义到声学模型同样采用非自回归掩码生成Transformer,该模型以语义标记为条件,生成多层声学标记序列以重建高质量语音波形。

03效果展示

MaskGCT 能超自然地模拟参考音频音色与风格,并跨语言生成音频:

参考音频:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

中文克隆效果:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

英文克隆效果:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

“耳边细语”也可以实现:

参考音频:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

英文克隆效果:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

中文克隆效果:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

MaskGCT还能够模仿动画人物和名人的声音,猜猜下面的音频都是谁?

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

与基于自回归的TTS系统相比,MaskGCT具有更强的稳定性,绕口令也不在话下:

The great Greek grape growers grow great Greek grapes one one one.

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

墙上画凤凰,凤凰画在粉红墙。红凤凰、粉凤凰,红粉凤凰、花凤凰。红凤凰,黄凤凰,红粉凤凰,粉红凤凰,花粉花凤凰。

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

此外,MaskGCT还可以控制生成音频的语速:

快速:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

中等:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

慢速:

链接:https://www.yuque.com/yuqueyonghuw5np3s/vr4wfs/loor6vtg1vex9usg

04实验结果

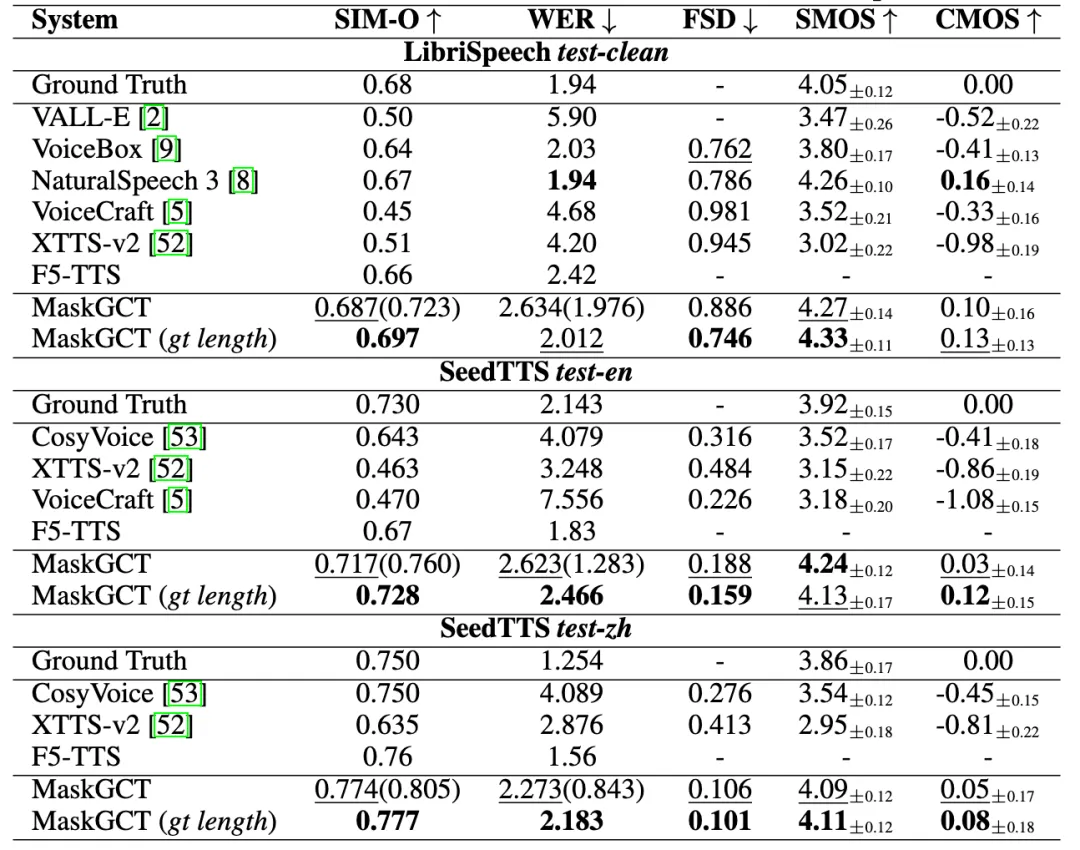

SOTA的语音合成效果:MaskGCT在三个TTS基准数据集上都达到了SOTA的效果,某些指标上甚至超过了人类水平。

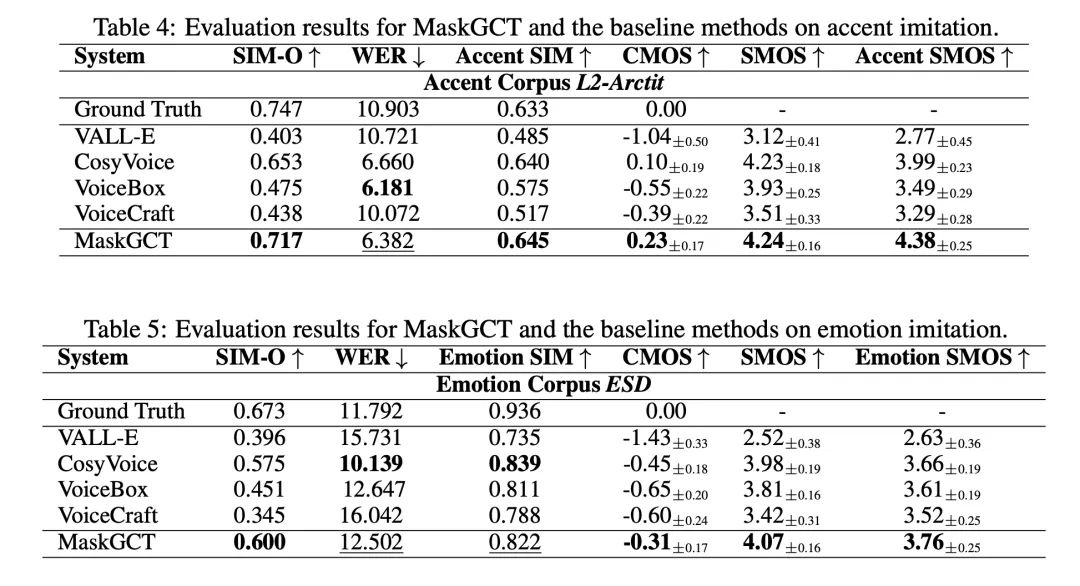

此外,MaskGCT在风格迁移(口音、情感)也达到了SOTA的水准:

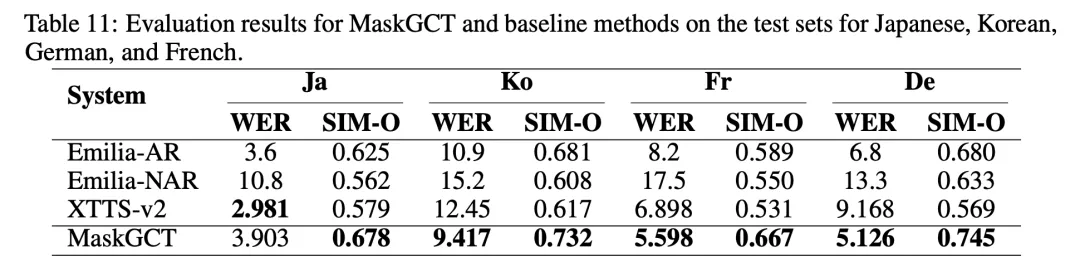

我们还研究了MaskGCT在中、英外其它语言的能力:

05应用场景

目前,MaskGCT在短剧出海、数字人、智能助手、有声读物、辅助教育等领域拥有丰富的应用场景。为了加快落地应用,在安全合规下,趣丸科技打造了多语种速译智能视听平台“趣丸千音”。一键上传视频即可快速翻译成多语种版本,并实现字幕修复与翻译、语音翻译、唇音同步等功能。该产品进一步革新视频翻译制作流程,大幅降低过往昂贵的人工翻译成本和冗长的制作周期,成为影视、游戏、短剧等内容出海的理想选择平台。

《2024年短剧出海白皮书》显示,短剧出海成为蓝海新赛道,2023年海外市场规模高达650亿美元,约为国内市场的12倍,短剧出海成为蓝海新赛道。以“趣丸千音”为代表的产品的出现,将加速国产短剧“走出去”,进一步推动中华文化在全球不同语境下的传播。

06总结

MaskGCT是一个大规模的零样本TTS系统,利用全非自回归掩码生成编解码器Transformer,无需文本与语音的对齐监督和音素级持续时间预测。MaskGCT通过文本预测从语音自监督学习(SSL)模型中提取的语义标记,然后基于这些语义标记预测声学标记,实现了高质量的文本到语音合成。实验表明,MaskGCT在语音质量、相似度和可理解性方面优于最先进的TTS系统,并且在模型规模和训练数据量增加时表现更佳,同时能够控制生成语音的总时长。此外,我们还探索了MaskGCT在语音翻译、语音转换、情感控制和语音内容编辑等任务中的可扩展性,展示了MaskGCT作为语音生成基础模型的潜力。

论文链接:

https://arxiv.org/abs/2409.00750

Demo展示:

https://modelscope.cn/studios/amphion/maskgct

Amphion地址:

https://github.com/open-mmlab/Amphion

模型下载:

https://modelscope.cn/models/amphion/MaskGCT

项目地址:

https://github.com/open-mmlab/Amphion/tree/main/models/tts/maskgct

公测版地址(趣丸千音):

voice.funnycp.com

欢迎大家点击阅读原文,跳转GitHub链接点击Star

更多推荐

已为社区贡献649条内容

已为社区贡献649条内容

所有评论(0)