%pip install ultralytics

import ultralytics

ultralytics.checks()魔搭社区每周速递(9.28-10.12)

503个模型、189个数据集、82个创新应用、9篇应用文章

🙋魔搭ModelScope本期社区进展:

📟503个模型:YOLO11、Ovis1.6-Gemma2-9B、whisper-large-v3-turbo等;

📁189个数据集:MMBench-Video、InternVid、对话-百科(中文)训练集、MedTrinity-25M、fineweb-edu等;

🎨82个创新应用:数字人对话demo、Ovis1.6-Gemma2-9B、OpenMusic等;

📄9篇文章:

-

阿里国际AI开源Ovis1.6,多项得分超GPT-4o-mini!

-

多智能体微调实践:α-UMi 开源

-

xGPU来啦!免费GPU资源开发花样AI应用!

-

ExVideo+CogVideoX,更长、更优!再次升级的开源视频生成能力

-

Ultralytics YOLO11来啦!更快!更强!

-

社区供稿 | OpenCSG开源最大中文合成数据集Chinese Cosmopedia,1500万条数据 60B token

-

智源研究院开源中文互联网语料库CCI3.0,1000GB数据集,498GB高质量子集,魔搭社区可下载!

-

LLaMA-Omni 低延迟高质量语音交互,开源!

-

666条数据,训练LongWriter模型,写万字长文!模型&数据集均开源!

01

精选模型

YOLO11

Ultralytics YOLO11,作为新的SOTA模型,不仅继承了之前YOLO系列的优势,还引入了创新特性和改进,提升了性能和灵活性。它以快速、精准、易用为特点,成为处理目标检测、跟踪、实例分割、图像分类和姿态估计等多种视觉任务的理想选择。

模型合集链接:

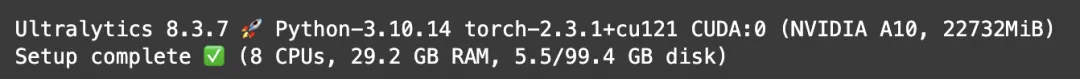

https://modelscope.cn/models/AI-ModelScope/YOLO11 代码示例:

在魔搭社区下载模型并推理,YOLO11 可直接在命令行界面 (CLI) 中使用 `yolo` 命令执行各种任务和模式,并接受其他参数,例如 `imgsz=640`。

!modelscope download --model=AI-ModelScope/YOLO11 --local_dir ./ yolo11n.pt

!yolo predict model="/mnt/workspace/yolo11n.pt" source='https://ultralytics.com/images/zidane.jpg'更多推理、微调实战教程详见:

Whisper-Large-v3-Turbo

Whisper 是一种先进的自动语音识别 (ASR) 和语音翻译模型,由 OpenAI 的 Alec Radford 等人在论文 Robust Speech Recognition via Large-Scale Weak Supervision 中提出。Whisper 经过超过 500 万小时的标记数据训练,在零样本设置中展现出强大的泛化能力,能够应用于许多数据集和领域。 Whisper large-v3-turbo 是经过修剪的Whisper large-v3的微调版本。换句话说,它是完全相同的模型,只是解码层的数量从 32 层减少到了 4 层。因此,该模型的速度更快,但质量略有下降。

模型链接:

https://modelscope.cn/models/iic/Whisper-large-v3-turbo/summary

(内含详细使用代码)

Ovis1.6-Gemma2-9B

阿里国际AI团队开源多模态大模型Ovis1.6,并在多模态权威综合评测基准OpenCompass上,在300亿以下参数开源模型中位居第一。

Ovis由视觉tokenizer、视觉embedding表和LLM三个组件构成。视觉部分,采用可学习的视觉embedding表,将视觉特征转换为概率化的视觉token,并经加权索引得到结构化embedding。文本部分,通过tokenizer转换为one-hot token,并根据文本embedding表查找嵌入向量。最后,Ovis将视觉和文本embedding向量拼接后用Transformer处理多模态任务。

Ovis1.6能胜任视觉感知推理、数学和科学、生活场景等多种多模态任务,尤其是在数学推理和视觉理解等多项任务中,得分甚至超过了闭源的GPT-4o-mini。

模型链接:

https://modelscope.cn/models/AIDC-AI/Ovis1.6-Gemma2-9B

代码示例:

import torch

from PIL import Image

from modelscope import AutoModelForCausalLM

# load model

model = AutoModelForCausalLM.from_pretrained("AIDC-AI/Ovis1.6-Gemma2-9B",

torch_dtype=torch.bfloat16,

multimodal_max_length=8192,

trust_remote_code=True).cuda()

text_tokenizer = model.get_text_tokenizer()

visual_tokenizer = model.get_visual_tokenizer()

# enter image path and prompt

image_path = input("Enter image path: ")

image = Image.open(image_path)

text = input("Enter prompt: ")

query = f'<image>\n{text}'

# format conversation

prompt, input_ids, pixel_values = model.preprocess_inputs(query, [image])

attention_mask = torch.ne(input_ids, text_tokenizer.pad_token_id)

input_ids = input_ids.unsqueeze(0).to(device=model.device)

attention_mask = attention_mask.unsqueeze(0).to(device=model.device)

pixel_values = [pixel_values.to(dtype=visual_tokenizer.dtype, device=visual_tokenizer.device)]

# generate output

with torch.inference_mode():

gen_kwargs = dict(

max_new_tokens=1024,

do_sample=False,

top_p=None,

top_k=None,

temperature=None,

repetition_penalty=None,

eos_token_id=model.generation_config.eos_token_id,

pad_token_id=text_tokenizer.pad_token_id,

use_cache=True

)

output_ids = model.generate(input_ids, pixel_values=pixel_values, attention_mask=attention_mask, **gen_kwargs)[0]

output = text_tokenizer.decode(output_ids, skip_special_tokens=True)

print(f'Output:\n{output}')02

数据集推荐

中文互联网语料库CCI3.0

智源研究院正式发布中文互联网语料库CCI 3.0(Chinese Corpora Internet,简称 CCI),包括1000GB的数据集以及498GB的高质量子集CCI3.0-HQ。CCI 3.0收录超过2.68亿个网页,涵盖新闻、社交媒体、博客等多个领域。CCI 3.0的数据规模相较于CCI 2.0扩大近一倍,数据来源机构扩展至20多家,显著提升数据覆盖面和代表性。

数据集链接:

https://www.modelscope.cn/datasets/BAAI/CCI3-Data

InternVid

InternVid-10M-FLT,这是该数据集的一个子集,包含 1000 万个视频片段,为公开的网络视频生成了高质量的字幕。

数据集链接:

https://modelscope.cn/datasets/OpenGVLab/InternVid

MedTrinity-25M

MedTrinity-25M 是一个全面的大型医学多模态数据集,涵盖 10 种模态的 2500 多万张图像,为 65 多种疾病提供多粒度注释。这些丰富的注释既包括全局文本信息,例如疾病/病变类型、模态、区域特定描述和区域间关系,也包括感兴趣区域 (ROI) 的详细局部注释,包括边界框、分割蒙版。与现有数据集相比,MedTrinity-25M 提供了最丰富的注释,支持全面的多模态任务,例如字幕和报告生成,以及以视觉为中心的任务,例如分类和分割。该数据集可用于支持多模态医疗 AI 模型的大规模预训练,为未来医学领域的基础模型的开发做出贡献。

数据集链接:

https://modelscope.cn/datasets/AI-ModelScope/MedTrinity-25M

Chinese Cosmopedia

数据集共包含1500万条数据,约60B个token,构建合成数据集的两个核心要素是种子数据和prompt。种子数据决定了生成内容的主题,prompt则决定了数据的风格(如教科书、故事、教程或幼儿读物)。数据来源丰富多样,涵盖了中文维基百科、百度百科、知乎问答和技术博客等平台,确保内容的广泛性和权威性。生成的数据形式多样,涵盖大学教科书、中学教科书、幼儿故事、普通故事和WikiHow风格教程等多种不同风格。通过对每条种子数据生成多种不同风格的内容,数据集不仅适用于学术研究,还广泛应用于教育、娱乐和技术领域。

数据集链接:

https://www.modelscope.cn/datasets/opencsg/chinese-cosmopedia

03

精选应用

数字人对话demo

基于开源ASR、LLM、TTS和THG项目,持续更新中。

体验直达:

https://modelscope.cn/studios/AI-ModelScope/video_chat

Ovis1.6-Gemma2-9B

Ovis1.6-Gemma2-9B提供基于9亿参数Gemma2模型的先进AI交互体验

体验直达:

https://modelscope.cn/studios/AIDC-AI/Ovis1.6-Gemma2-9B

OpenMusic

提供创新的音乐生成和编辑体验

体验直达:

https://modelscope.cn/studios/paper_author_team/OpenMusic_demo

04

社区精选文章

更多推荐

已为社区贡献634条内容

已为社区贡献634条内容

所有评论(0)