社区供稿 | RWKV-6-World 14B正式开源发布,迄今最强的稠密纯RNN大语言模型

2024年7月19日,RWKV 开源基金会宣布正式向全球开源 RWKV-6-World 14B 模型。

2024年7月19日,RWKV 开源基金会宣布正式向全球开源 RWKV-6-World 14B 模型。

RWKV-6-World 14B 是迄今最强的稠密纯 RNN 大语言模型。

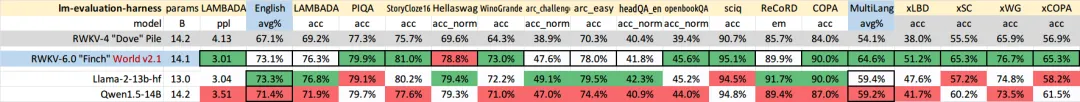

在最新的性能测试中, RWKV-6-World 14B 模型英文性能相当于 Llama2 13b。此外,在同参数的模型评测中,RWKV-6-World 14B 的多语言性能显著最强,且支持全球100+种语言和代码。

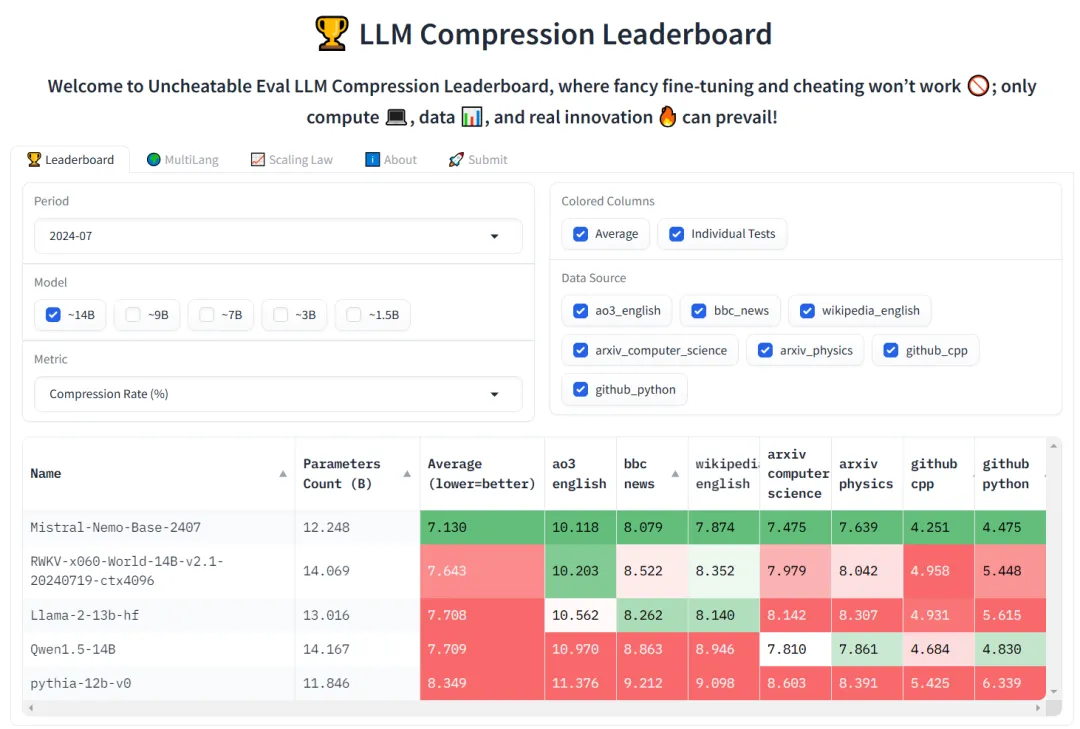

在“无法作弊的模型评测” Uncheatable Eval 排行榜中,RWKV-6-World 14B 的综合评测分数比 llama2 13B 和 Qwen1.5 14B 更强。

评测数据

本次模型基准测试涵盖了 4 款接近 14B 参数规模的开源大语言模型。

在测试中,英语的性能测试将通过 12 个独立的基准测试来衡量大模型在常识推理和世界知识等英语内容上的表现。

多语言能力的评估中,则采用了 xLAMBDA、xStoryCloze、 xWinograd 和 xCopa 四种基准测试,深度探索了评估模型在多语言环境中的逻辑推理、故事理解、歧义解决和因果推理能力。

由于 RWKV-5 系列模型最大只有 7B 参数,我们选择了 RWKV-4 14B 模型作为纵向对比。

可以看到,相比于此前发布的 RWKV-4 14B 模型,RWKV-6-World 14B 的英文性能和多语言性能都获得巨大提升。

RWKV-6-World-14B 模型的性能改进,大大得益于从 RWKV-4 到 RWKV-6 的架构改进,有关 RWKV-6 架构的优化细节,请参考文章:

不作弊的 RWKV 模型

值得强调的是,我们在训练 RWKV 模型时,并未加入任何基准测试的数据集。换言之,我们没有为了获取更佳的评分结果而进行特殊优化。

RWKV 不刷榜也不刷星,因此 RWKV 模型的实际能力比它的各种评分排行更强。

既然承诺不作弊,我们也第一时间对 RWKV-6-World-14B 模型进行了 “无法作弊的模型评测” —— Uncheatable Eval[1]。

Uncheatable Eval 会使用最新的 arXiv 论文、新闻文章、小说数据和 GitHub 代码等实时语料库,以此来评估语言模型的真实建模能力和泛化能力。

有关 Uncheatable Eval 的详细介绍,可参见此文章:RWKV在“不可作弊的模型评测”中获得良好成绩

RWKV-6-World 14B 的 Uncheatable Eval 评测

此次 Uncheatable Eval 评测选取了常见的 5 款开源 14B 参数模型,测评数据则选择 7 月最新发布的 arXiv 论文、新闻、ao3 小说和 GitHub 代码等实时数据。

具体评分和综合排名如下:

可以看到,RWKV-6-World 14B 在此次测试中排行第 2,综合评测分数比相同尺寸的 llama2 和 Qwen1.5 更强。

而 Mistral 最新发布的 12B 模型使用了比 RWKV-6 多几倍的数据,它的性能更强。我们会继续为 RWKV 模型补充优质数据,与它看齐。

模型下载和体验

目前 RWKV-6-World 14B 模型还没有在线 Demo,可以从以下平台下载 RWKV-6-World 14B 模型并本地部署:

-

Hugging Face:https://huggingface.co/BlinkDL/rwkv-6-world/tree/main

-

ModelScope:https://modelscope.cn/models/RWKV/rwkv-6-world/files

-

WiseModel:https://wisemodel.cn/models/rwkv4fun/Rwkv-6-world/file

由于 Ai00 只支持 safetensor(.st)格式的模型,如果你打算使用 Ai00 体验 RWKV-6-World 14B 模型 ,可以在 Ai00 HF 仓库[2]中下载已经转成 .st 格式的模型。

本地部署 14B 模型的显存需求

如果你计划本地部署并推理 RWKV-6-World 14B 模型,参考的 VRAM (显存)消耗如下:

|

量化方式 |

显存参考 |

|

fp16 |

约 28G |

|

int8 -量化 56 层 |

约 15G |

|

nf4 - 量化 56 层 |

约 10G |

新模型效果预览

以下为 RWKV-6-World 14B 模型的实测效果:

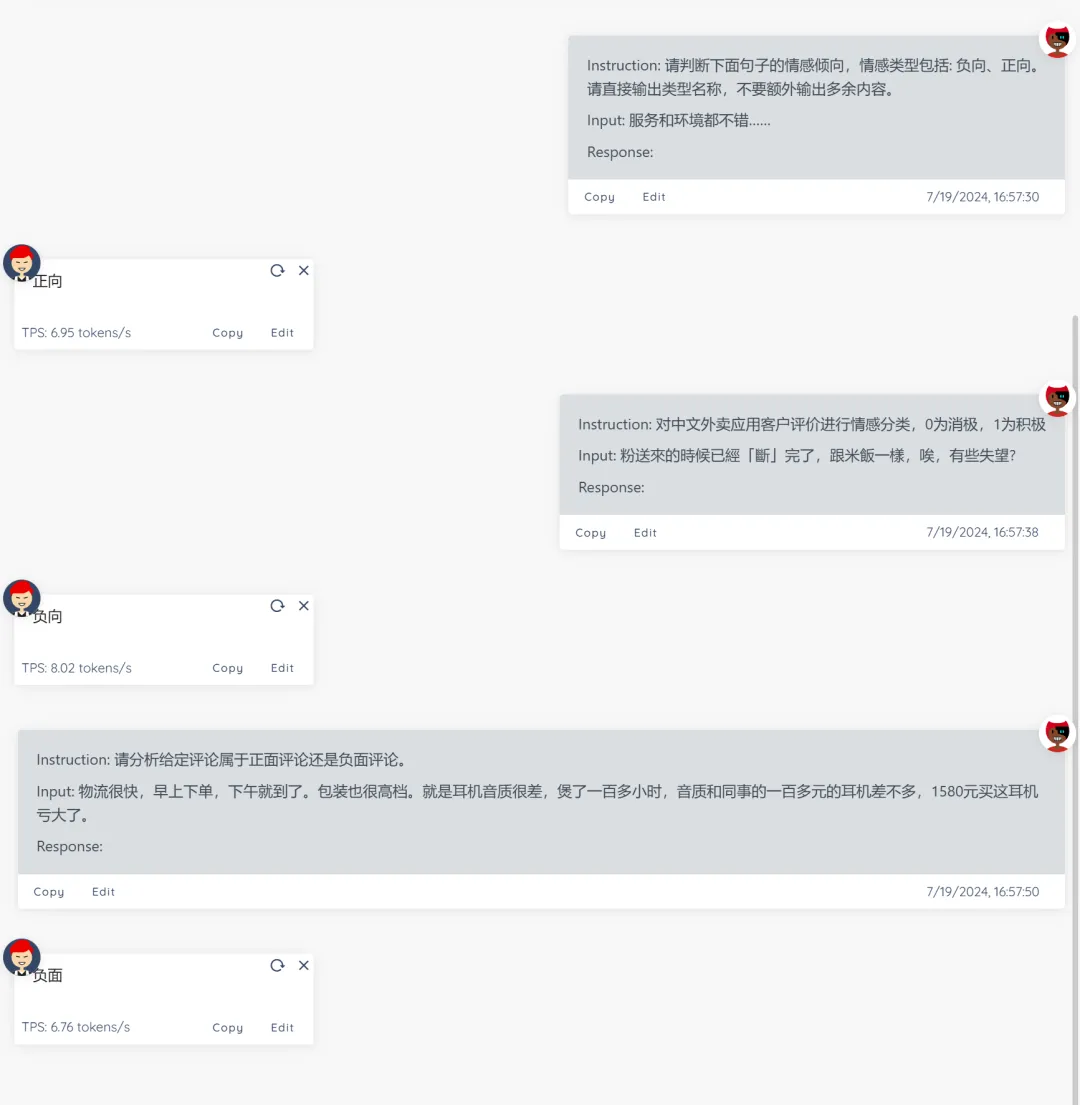

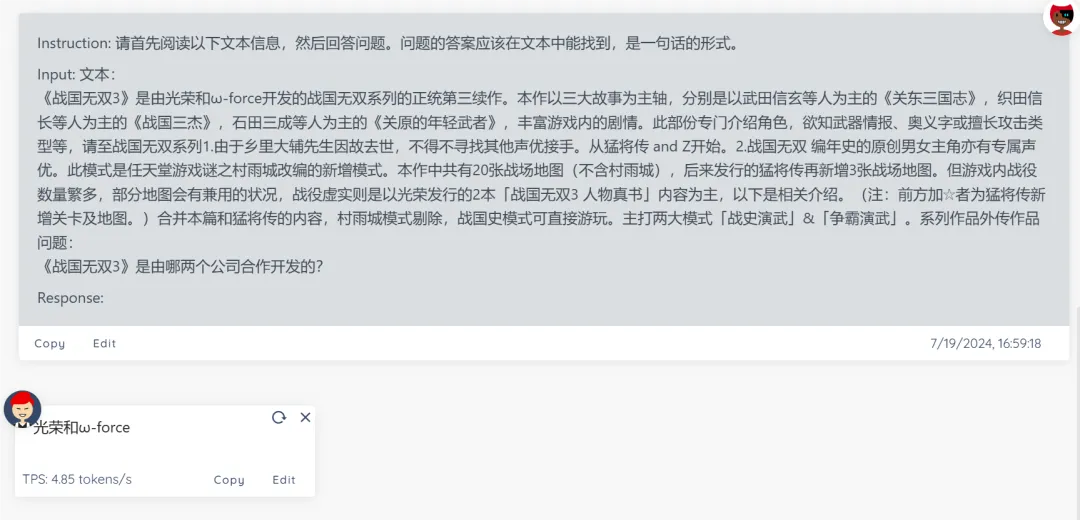

以下案例使用 Ai00[3] 作为推理服务器,int8 + 30 层量化,未加载任何 State

自然语言处理(情感分析)

自然语言处理(机器阅读理解)

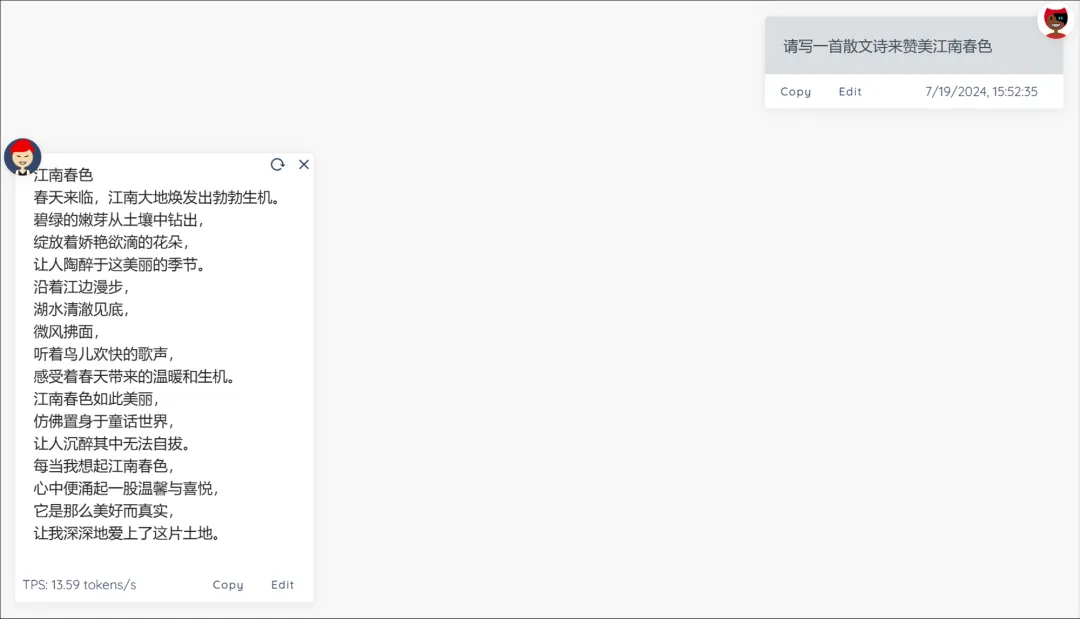

散文诗文学创作

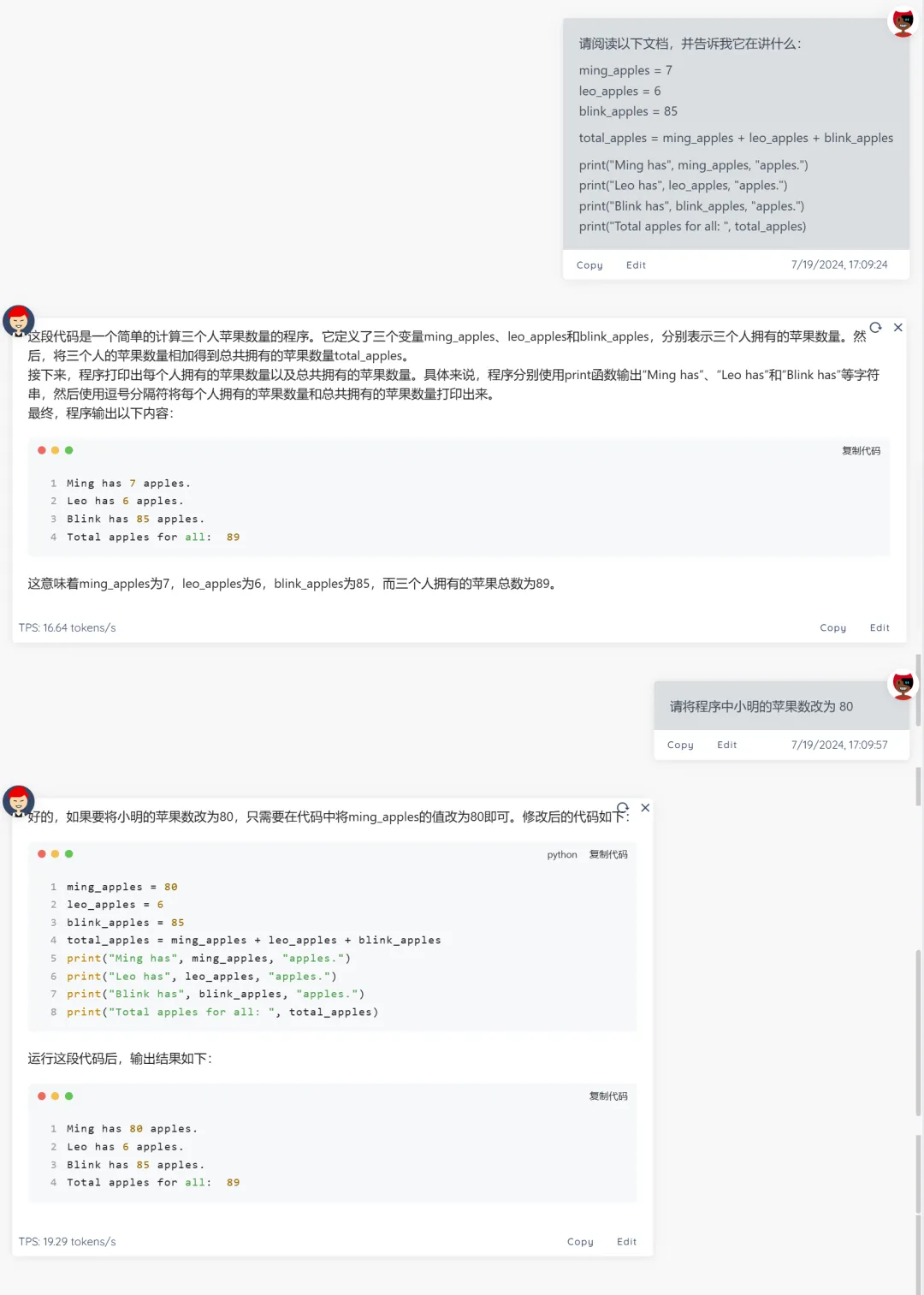

阅读并修改一段代码

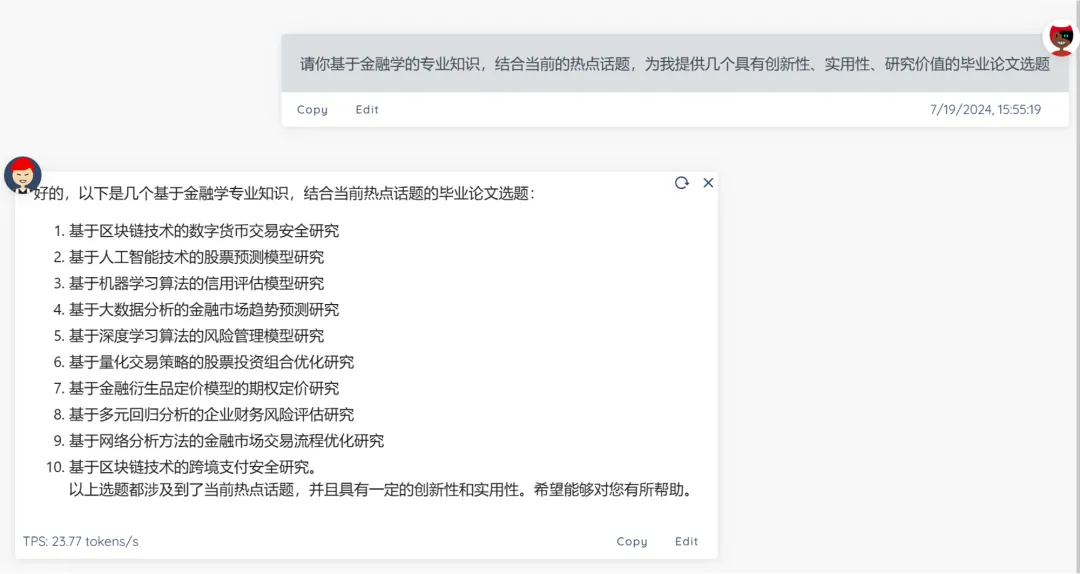

金融学论文选题建议

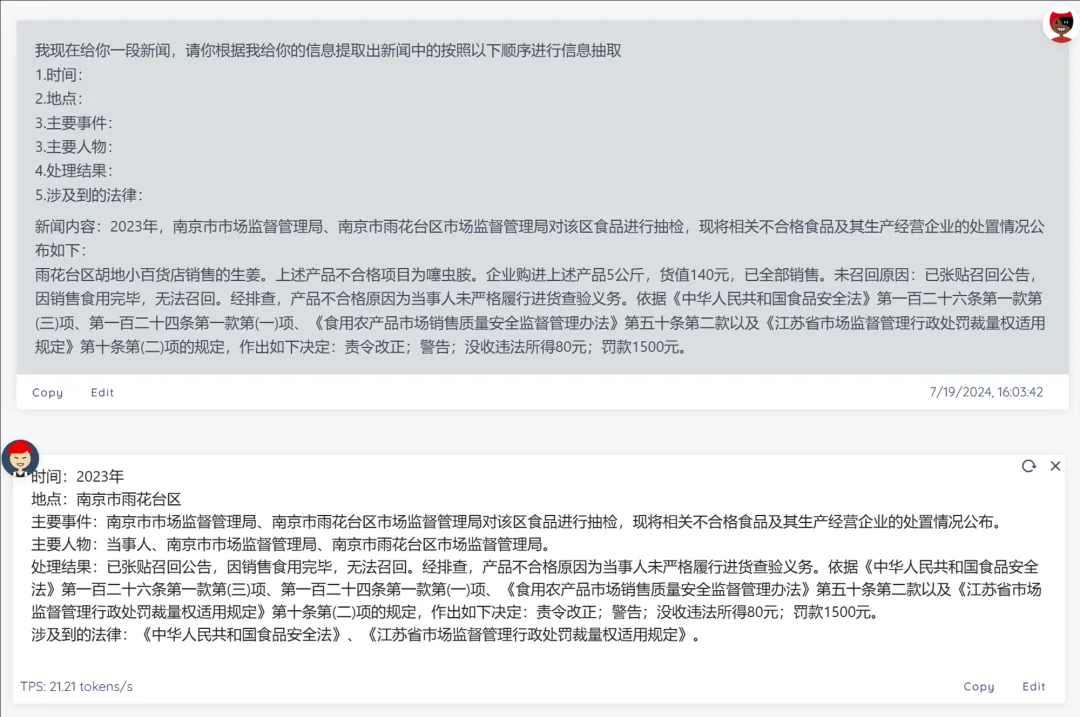

提取新闻关键内容

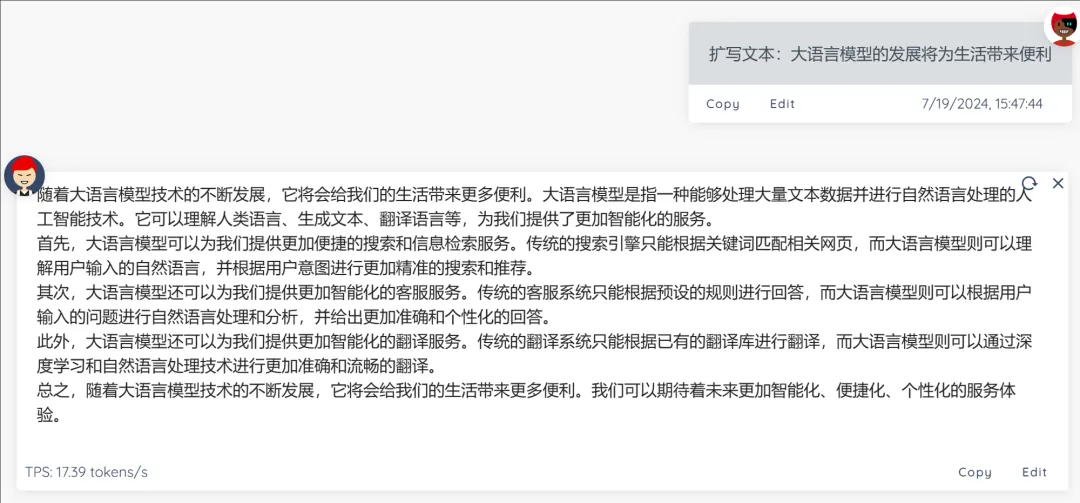

一句话扩写文本

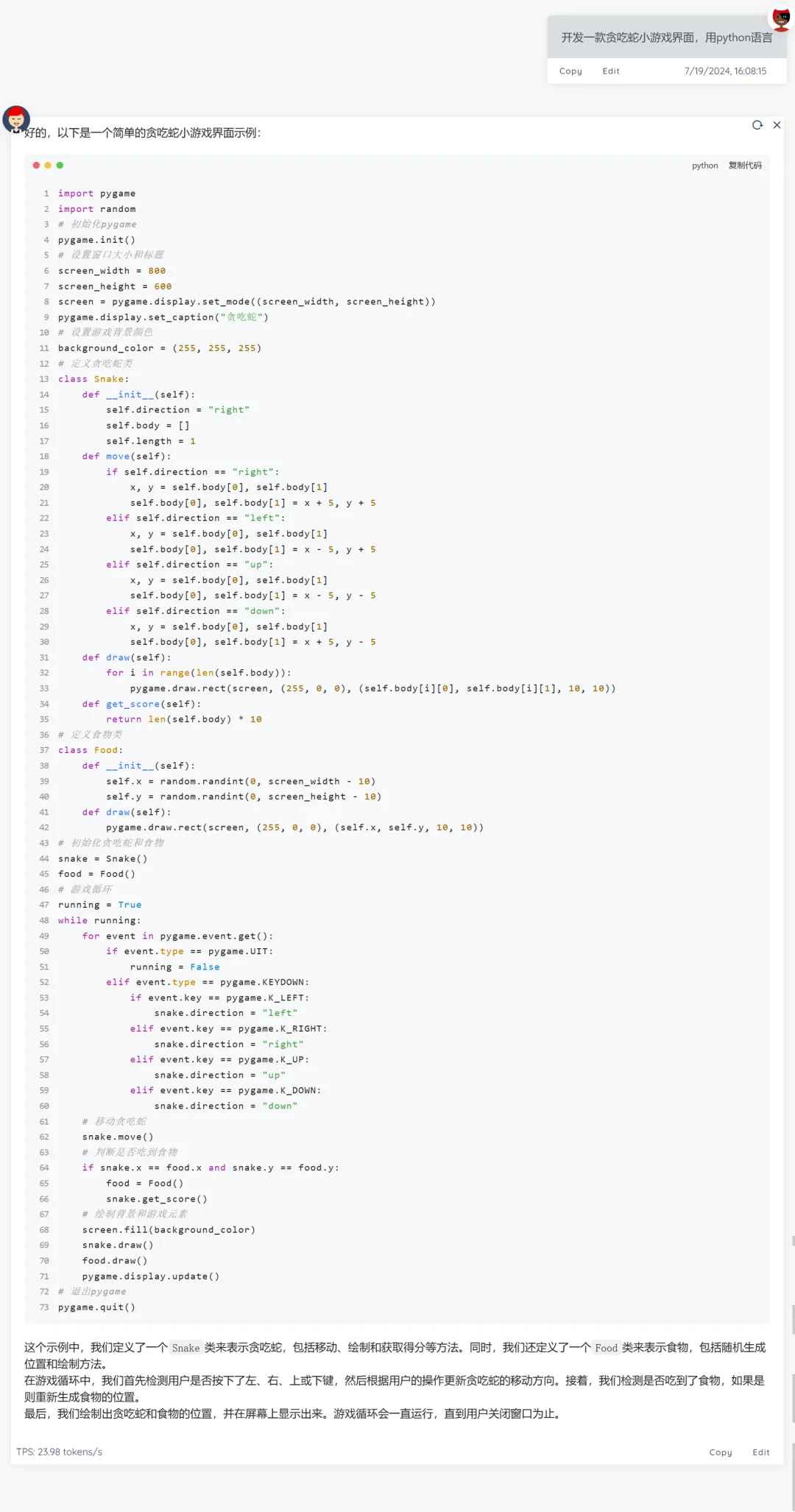

python 贪吃蛇小游戏

注意:目前开源发布的所有 RWKV 模型均为基底模型。

基底模型具备一定的指令和对话能力,但为了保持其通用性和泛化能力,基底模型未进行任何对齐,也未针对某一类任务做优化。因此,基底模型在特定任务上的表现并不代表 RWKV 模型最优水准。

如果希望 RWKV 模型在某种类型的任务上表现良好且稳定,建议使用此类任务的数据集对 RWKV 模型进行微调训练。

目前我们已经发布了一些 RWKV 基底模型对特定任务进行微调训练的教程,详情可以在 RWKV 中文文档 - RWKV 微调教程[4] 中查看。

随着 RWKV-6 架构发布 14B 模型,RWKV-7 架构的测试工作也在紧密地进行中。

此外,RWKV 社区近期有很多新的研究,比如首个基于 RWKV 的医学图像修复模型 Restore-RWKV[5] 、海外社区做的 RWKV + Attention 混合架构 GoldFinch [6]。

RWKV 模型介绍

RWKV 是一种创新的深度学习网络架构,它将 Transformer 与 RNN 各自的优点相结合,同时实现高度并行化训练与高效推理。

RWKV 模型架构论文:

-

RWKV-5/6(Eagle & Finch): https://arxiv.org/abs/2404.05892

-

RWKV-4:https://arxiv.org/abs/2305.13048

相关链接

[1]Uncheatable Eval: https://huggingface.co/spaces/Jellyfish042/UncheatableEval

[2]Ai00 HF 仓库: https://huggingface.co/cgisky/ai00_rwkv_x060/tree/main

[3]Ai00: https://rwkv.cn/ai00/Introduction

[4]RWKV 中文文档 - RWKV 微调教程: https://rwkv.cn/RWKV-Fine-Tuning/Introduction

[5]Restore-RWKV: Efficient and Effective Medical Image Restoration with RWKV: https://arxiv.org/abs/2407.11087

[6]GoldFinch: High Performance RWKV/Transformer Hybrid with Linear Pre-Fill and Extreme KV-Cache Compression: https://arxiv.org/abs/2407.12077

更多推荐

已为社区贡献634条内容

已为社区贡献634条内容

所有评论(0)