魔搭社区模型速递(5.18-5.24)

魔搭ModelScope本期社区进展:3790个模型,307个数据集,90个创新应用, 7 篇内容

🙋魔搭ModelScope本期社区进展:

📟3790个模型:Index-AniSora、Gemma-3n-Preview系列、Devstral-Small-2505、AetherV1等;

📁307个数据集:CCI4.0-M2系列、BandwidthEstimationDataset、DMind_Benchmark、OpenVid-1M等;

🎨90个创新应用:热门MCP服务一键评测、有声课件制作、妆容百宝箱等;

📄 7 篇内容:

- Reasoning模型蒸馏实践:用大模型提升小模型能力

- 智源研究院发布开源中文互联网语料库CCI 4.0,新增高质量英文数据与合成数据

- 通义灵码 + 魔搭MCP:全流程构建创空间应用

- 4G手机内存玩转Qwen2.5-Omni?MNN全面支持Qwen2.5-Omni与Qwen3!

- 阿里云发布可观测MCP!支持自然语言查询和分析多模态日志

- B站开源SOTA动画视频生成模型 Index-AniSora!

- 合成数据也能通吃真实世界?首个融合重建-预测-规划的生成式世界模型AETHER开源

01.模型推荐

Index-AniSora

Bilibili为动漫世界带来的礼物——Index-AniSora,SOTA开源动漫视频生成模型。 它支持一键创建多种动漫风格的视频片段,包括系列剧集、中国原创动画、漫画改编、VTuber内容、动漫PV、鬼畜动画等

模型地址:

https://modelscope.cn/models/bilibili-index/Index-anisora

B站开源SOTA动画视频生成模型 Index-AniSora!

Devstral-Small-2505

Devstral 是近期由 Mistral AI 和 All Hands AI 合作构建的面向软件工程任务的代理型大语言模型。Devstral 在使用工具探索代码库、编辑多个文件和驱动软件工程代理方面表现出色。在SWE-bench基准测试中表现卓越,位列开源模型榜首。

Devstral是在 Mistral-Small-3.1 的基础上微调而来的,具有长达 128k token的上下文窗口。作为编码代理,Devstral 仅限于文本处理,在从 Mistral-Small-3.1 微调之前移除了视觉编码器。同时,Devstral紧凑的大小仅为 240 亿个参数,足够轻便可以在单个 RTX 4090 或配备 32GB RAM 的 Mac 上运行,适合本地部署和设备上使用。

模型地址:

https://www.modelscope.cn/models/mistralai/Devstral-Small-2505

示例代码:

官方建议使用 OpenHands 架构来使用 Devstral

按照以下文档说明创建 Mistral 账户并获取 API 密钥

文档:

https://docs.mistral.ai/getting-started/quickstart/#account-setup

API

运行以下命令以启动 OpenHands Docker 容器

export MISTRAL_API_KEY=<MY_KEY>

docker pull docker.all-hands.dev/all-hands-ai/runtime:0.39-nikolaik

mkdir -p ~/.openhands-state && echo '{"language":"en","agent":"CodeActAgent","max_iterations":null,"security_analyzer":null,"confirmation_mode":false,"llm_model":"mistral/devstral-small-2505","llm_api_key":"'$MISTRAL_API_KEY'","remote_runtime_resource_factor":null,"github_token":null,"enable_default_condenser":true}' > ~/.openhands-state/settings.json

docker run -it --rm --pull=always \

-e SANDBOX_RUNTIME_CONTAINER_IMAGE=docker.all-hands.dev/all-hands-ai/runtime:0.39-nikolaik \

-e LOG_ALL_EVENTS=true \

-v /var/run/docker.sock:/var/run/docker.sock \

-v ~/.openhands-state:/.openhands-state \

-p 3000:3000 \

--add-host host.docker.internal:host-gateway \

--name openhands-app \

docker.all-hands.dev/all-hands-ai/openhands:0.39

本地推理-OpenHands (推荐)

- 启动服务器以部署 Devstral-Small-2505

确保已按上述说明启动了一个与 OpenAI 兼容的服务器,然后通过运行以下命令启动一个 vLLM 服务器,并使用 OpenHands 与 Devstral-Small-2505 进行交互

VLLM_USE_MODELSCOPE=true vllm serve mistralai/Devstral-Small-2505 --tokenizer_mode mistral --config_format mistral --load_format mistral --tool-call-parser mistral --enable-auto-tool-choice --tensor-parallel-size 2

服务器地址应采用以下格式:http://<your-server-url>:8000/v1

启动 OpenHands

参考安装 OpenHands。

启动 OpenHands 的最简单方法是使用 Docker 镜像:

docker pull docker.all-hands.dev/all-hands-ai/runtime:0.38-nikolaik

docker run -it --rm --pull=always \

-e SANDBOX_RUNTIME_CONTAINER_IMAGE=docker.all-hands.dev/all-hands-ai/runtime:0.38-nikolaik \

-e LOG_ALL_EVENTS=

true

\

-v /var/run/docker.sock:/var/run/docker.sock \

-v ~/.openhands-state:/.openhands-state \

-p 3000:3000 \

--add-host host.docker.internal:host-gateway \

--name openhands-app \

docker.all-hands.dev/all-hands-ai/openhands:0.38连接到服务器

当访问 OpenHands UI 时,系统会提示连接到一个服务器,可以使用高级模式连接到之前启动的服务器。

填写以下字段:

-

-

- 自定义模型:

openai/mistralai/Devstral-Small-2505 基础 URL: http://<your-server-url>:8000/v1API 密钥: token(或在启动服务器时使用的任何其他令牌)

- 自定义模型:

-

使用由 Devstral 支持的 OpenHands

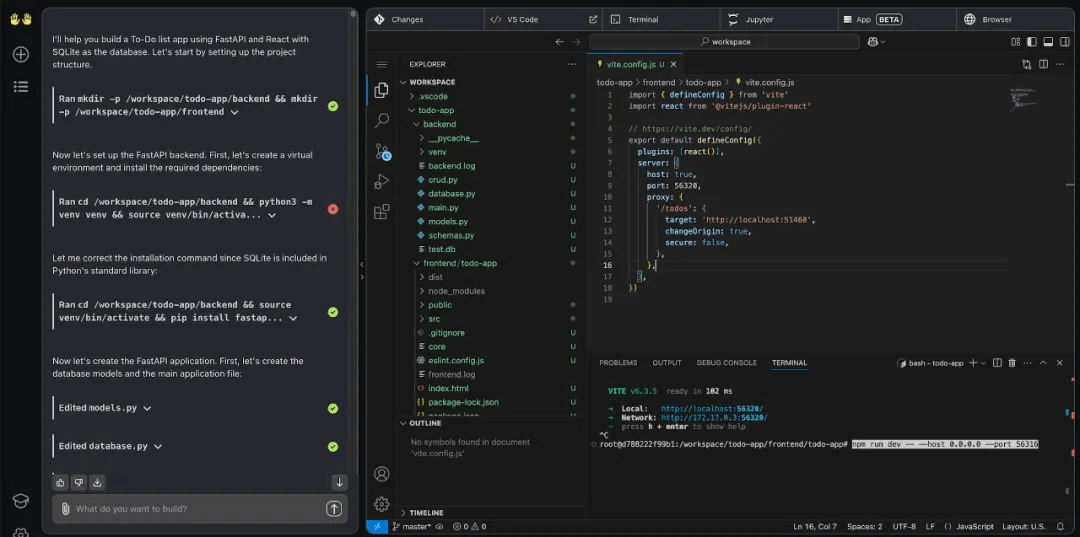

通过开始新的对话在 OpenHands 中使用 Devstral Small,以构建一个待办事项列表应用为例:

Build a To-Do list app with the following requirements:

- Built using FastAPI and React.

- Make it a one page app that:

- Allows to add a task.

- Allows to delete a task.

- Allows to mark a task as done.

- Displays the list of tasks.

- Store the tasks in a SQLite database.

Gemma-3n-Preview系列

Gemma-3n是Google在2025年I/O大会上开源发布的一款专为低资源设备打造的多模态模型,仅需2GB RAM即可在手机、平板和轻薄笔记本上流畅运行,处理音频、文本、图片和视频多种数据类型,支持140+语言的文本和视觉处理,覆盖全球用户需求。

Gemma3n继承了Gemini Nano的轻量化架构,通过知识蒸馏和量化感知训练(QAT),在保持高性能的同时大幅降低资源需求。本次开源向社区提供预览版(gemma-3n-E2B-it-litert-preview 和 E4B。

模型地址:

https://www.modelscope.cn/collections/Gemma-3n-Preview-865a7e2c20e245

AetherV1

近日,上海人工智能实验室开源了生成式世界模型 AETHER。该模型全部由合成数据训练而成,不仅在传统重建与生成任务中表现领先,更首次赋予大模型在真实世界中的 3D 空间决策与规划能力,可助力机器人完成目标导向的视觉规划、4D 动态重建、动作条件的视频预测等复杂任务。

研究团队将几何重建与生成式建模深度融合,首创「重建 — 预测 — 规划」 一体化框架,通过 AETHER 使大模型能够感知周围环境,理解物体之间的位置、运动和因果关系,从而做出更智能的行动决策。

模型地址:

https://modelscope.cn/models/AetherWorldModel/AetherV1

深度讲解详见文章:

合成数据也能通吃真实世界?首个融合重建-预测-规划的生成式世界模型AETHER开源

02.数据集推荐

CCI4.0-M2系列

CCI 4.0兼顾多样性与高质量,从单一语言数据集扩展为多语种数据集。本次发布包括了中、英语两种语言,并将在随后的发布中,开源更多语言的版本。此外,CCI 4.0首次采用CoT方法进行推理轨迹数据合成,以提升预训练模型的基础推理能力。CCI 4.0数据集由智源研究院牵头,联合包括阿里云、上海人工智能实验室、华为、出门问问、金山办公、昆仑万维、面壁智能、奇虎科技、美团、稀宇科技、月之暗面、紫东太初、中科闻歌、科大讯飞等多个机构共同贡献。

数据集链接:

https://modelscope.cn/organization/BAAI?tab=dataset

BandwidthEstimationDataset

BandwidthEstimationDataset 是由字节跳动提供的一个高质量带宽估计数据集,适用于学术研究和工业应用,涵盖多种网络条件和设备类型,可助力开发更精准的带宽预测模型。

数据集链接:

https://modelscope.cn/datasets/ByteDance/BandwidthEstimationDataset

DMind_Benchmark

DMind_Benchmark 是一个基准测试数据集,用于评估和比较不同模型的性能。

数据集链接:

https://modelscope.cn/datasets/AI-ModelScope/DMind_Benchmark

OpenVid-1M

OpenVid-1M 是一个大规模视频数据集,包含超过100万段视频,旨在支持视频理解、分析和生成等多模态人工智能任务的研究与开发。

数据集链接:

https://modelscope.cn/datasets/AI-ModelScope/OpenVid-1M

03.精选应用

热门MCP服务一键评测

体验直达:

https://modelscope.cn/studios/hicicada/MCP2PK

有声课件制作

体验直达:

https://modelscope.cn/studios/lpcarl/PPTVoiceMaker

04.社区精选文章

- Reasoning模型蒸馏实践:用大模型提升小模型能力

- 智源研究院发布开源中文互联网语料库CCI 4.0,新增高质量英文数据与合成数据

- 通义灵码 + 魔搭MCP:全流程构建创空间应用

- 4G手机内存玩转Qwen2.5-Omni?MNN全面支持Qwen2.5-Omni与Qwen3!

- 阿里云发布可观测MCP!支持自然语言查询和分析多模态日志

- B站开源SOTA动画视频生成模型 Index-AniSora!

- 合成数据也能通吃真实世界?首个融合重建-预测-规划的生成式世界模型AETHER开源

更多推荐

已为社区贡献652条内容

已为社区贡献652条内容

所有评论(0)