“一丹一世界”三等奖 | 绮影录 创作分享

“一丹一世界”三等奖 | 绮影录 创作分享

大家好我是圆香芹,一位专注 A IGC图像领域的创作者,以下是一个简单的自我介绍:

非常荣幸,本次”绮影录”lora作品获得魔搭平台”一丹一世界风格lora大赛”三等奖!感谢魔搭平台与麦乐园的认可。作为非专业模型训练师,我由衷感谢魔搭社区与麦乐园降低了技术门槛,让我得以顺利进入这个领域。在此分享一些经验与心得。

1.对lora的看法

一直以来我们对lora模型的训练都望而却步,但其实我们把lora训练的流程拆解来看的话,无非就是三个步骤,素材、参数、测试最优选。

简单来说,训练LORA本质上是将你的审美偏好转化为数字编码的过程。你选择的训练图像质量越高,审美越独特,最终效果就越接近你心目中的理想状态。因此,数据收集与清洗阶段实际上决定了你模型的潜力上限。

2.见解

在参数调优方面,首要任务是评估基础大模型的固有优势。以麦橘超然为例,这个模型专门针对亚洲人脸进行了微调训练,着力改善胶皮质感,核心优势在于呈现真实质感。

在场景写实度上,原版 F lux DVE确实存在不足。基于这一认知,我在收集素材时将插画类与写实类素材混合使用。理由很简单:既然底层模型本身具有写实特性,它在写实表现上自然强于插画风格。利用这一特点,我们是否就能创造出一种介于真实与虚幻之间的独特质感呢?

训练绮影录时,我的目标就是打造超现实风格。我们都知道写实系大模型在超现实表现上通常较弱。那么,通过混合超现实插画与写实风格素材,再结合麦橘超然模型优秀的肢体表现能力,是否就能达到最佳的泛化效果?结果证明确实如此:最终的模型既能生成超现实插画,又能呈现写实质感的人像,同时显著减少了肢体畸变的问题。

3.参数与测试

魔搭平台的训练器已经相当友好。从我的测试经验来看,最关键的参数是学习率、rank d im和 A lpha。

对于类似绮影录这样的人像+风格类模型,学习率保持在5e-5最为理想。这个参数能够细腻地学习人像细节(如毛孔纹理),同时作为超现实风格模型,也能捕捉到整体画风。

更重要的是 rank d im和 A lpha的设置,我都选择了16。为什么这样配置?可以这样理解:rank d im就像一个立方体容器架构,数值越大,能容纳的细节就越多,反之越少。而容器越大,就越需要控制过拟合风险。Alpha则像一个水龙头开关,值越小,模型在生成图像时影响全局的权重就越小,反之越大。因此我选择了两者持平。

关于模型测试,找到最优选择可分几步进行。当训练出30个模型后,最佳选择通常不会是最后几个,因为模型训练质量并非线性提升。测试时应该使用不同权重配比进行多轮比较。重要的是,避免用训练集中的提示词测试,这没有太大意义,既然已经训练模型,直接测试泛化能力才更有价值。

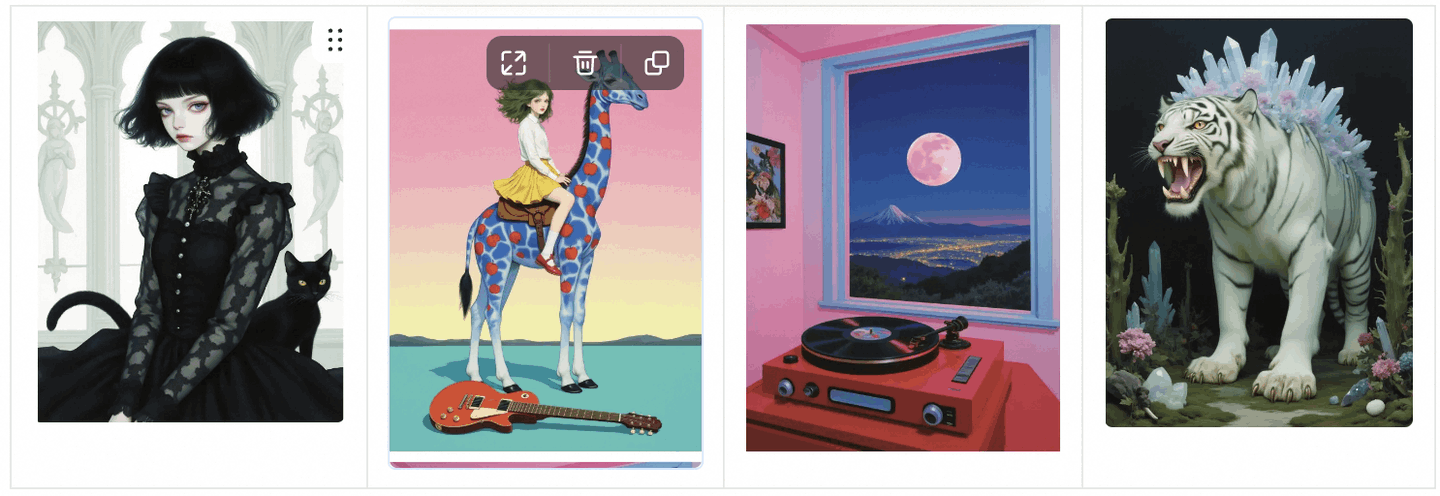

绮影录展示图:

再次感谢魔搭与麦乐员对我的认可,本次经验就分享到这里讲的不对的地方欢迎大伙锐评~

更多推荐

已为社区贡献592条内容

已为社区贡献592条内容

所有评论(0)