DeepSeek-V3小版本升级,非推理模型王者归来

今天,DeepSeek低调地在魔搭社区开源 DeepSeek-V3-0324 模型,虽然官方低调称之为小版本升级,但能力提升一点也不小。

今天,DeepSeek低调地在魔搭社区开源 DeepSeek-V3-0324 模型,虽然官方低调称之为小版本升级,但能力提升一点也不小。

模型地址:

https://www.modelscope.cn/models/deepseek-ai/DeepSeek-V3-0324

01.模型表现

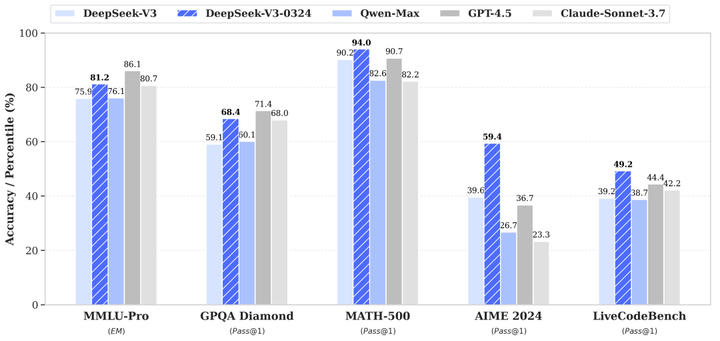

DeepSeek-V3-0324 在多个关键方面展示了相较于其前代产品 DeepSeek-V3 的显著改进。

推理能力

-

基准测试性能显著提升:

-

MMLU-Pro: 75.9 → 81.2 (+5.3)

-

GPQA: 59.1 → 68.4 (+9.3)

-

AIME: 39.6 → 59.4 (+19.8)

-

LiveCodeBench: 39.2 → 49.2 (+10.0)

前端网页开发

-

提高了代码的可执行性

-

更美观的网页和游戏前端

中文写作能力

-

增强了风格和内容质量:

-

符合 R1 写作风格

-

在中长篇写作中的质量更高

-

功能增强

-

改进了多轮交互式重写

-

优化了翻译质量和书信写作

中文搜索能力

-

增强了报告分析请求,输出更详细

函数调用改进

-

提高了函数调用的准确性,修复了 V3 之前版本的问题

02.使用建议

系统提示

在官方 DeepSeek 网站/应用程序中,使用带有特定日期的相同系统提示。

该助手为DeepSeek Chat,由深度求索公司创造。

今天是{current date}。例如

该助手为DeepSeek Chat,由深度求索公司创造。

今天是3月24日,星期一。温度设置

在deepseek的网页和应用环境中,温度参数被设置为 0.3。因为许多用户在 API 调用时使用默认的温度 1.0,所以DeepSeek实现了一个 API 温度 TapiT_{api}Tapi 映射机制,将输入的 API 温度值 1.0 调整为最适合模型的温度设置 0.3。

文件上传和网络搜索的提示

对于文件上传,请按照模板创建提示,其中 {file_name}, {file_content} 和 {question} 是参数。

file_template = \

"""[file name]: {file_name}

[file content begin]

{file_content}

[file content end]

{question}"""对于网络搜索,{search_results}, {cur_date}, 和 {question} 是参数。

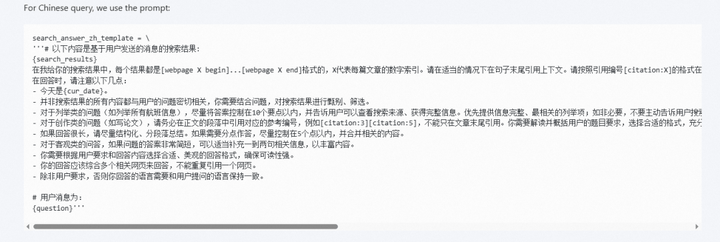

对于中文查询,使用的提示是:

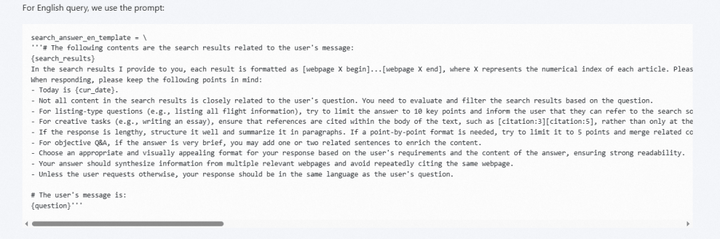

对于英文查询,使用的提示是:

03.本地运行

使用SGLang进行推理(官方推荐)

SGLang目前支持MLA 优化、DP Attention、FP8(W8A8)、FP8 KV Cache 和 Torch Compile,在开源框架中提供最先进的延迟和吞吐量性能。

同时,SGLang v0.4.1完全支持在NVIDIA 和 AMD GPU上运行 DeepSeek-V3 ,使其成为一种高度通用且强大的解决方案。

SGLang 还支持多节点张量并行,能够在多台联网的机器上运行此模型。

推理代码:

# Installation

pip install "sglang[all]>=0.4.3" --find-links https://flashinfer.ai/whl/cu124/torch2.5/flashinfer-python

# Launch

python3 -m sglang.launch_server --model /Your_Model_Path/DeepSeek-V3-0324 --tp 8 --trust-remote-code

根据需要添加性能优化选项。

许可证

仓库及模型权重遵循 MIT License

欢迎点击链接跳转模型详情~

更多推荐

已为社区贡献651条内容

已为社区贡献651条内容

所有评论(0)