魔搭llamafile集成:让大模型开箱即用

Llamafile是一个将大模型和其所需运行环境,全封装在一个可执行文件中的开源创新项目。为了方便广大开发者能以更低的门槛使用大模型,魔搭社区上提供了大量优秀模型的llamafile格式。

01.背景

Llamafile是一个将大模型和其所需运行环境,全封装在一个可执行文件中的开源创新项目。为了方便广大开发者能以更低的门槛使用大模型,魔搭社区上提供了大量优秀模型的llamafile格式。而现在,通过ModelScope命令行,就能在包括Linux/MacOS/Windows等不同操作系统上,直接上手使用社区上的这些优秀模型。

02.上手魔搭llamafile

当前只需要安装ModelScope库,不需要其他额外的配置,就可以不同的操作系统平台上,运行所有魔搭上提供的丰富的Llamafile模型。以Qwen2.5-3B-Instruct模型为例步骤如下:

-

确保安装了最新的ModelScope库,方便使用ModelScope的命令行

pip install modelscope -U

-

运行ModelScope命令行:

modelscope llamafile --model Qwen-Llamafile/Qwen2.5-3B-Instruct-llamafile

在不同的操作系统上,运行的体验如下:

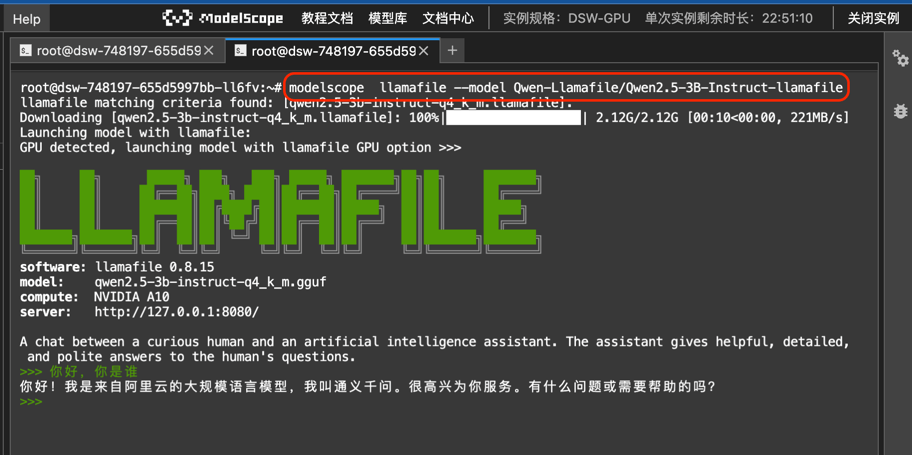

在Linux环境上:

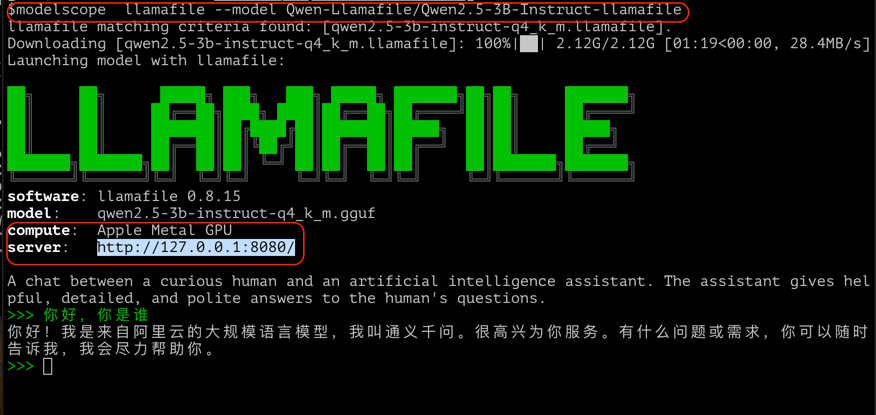

在Mac笔记本上:

只需要有ModelScope命令行,以及与ModelScope站点的网络连接,无需其他任何本地机器上的安装配置,拉起和使用大模型,就是如此的简单。

03.模型选择

从上面的范例里,大家可以看到使用ModelScope命令行运行llamafile,只需按照如下格式

modelscope llamafile --model {model-id}

其中model-id就是魔搭上的模型ID,格式为 {org}/{model},比如:

-

Qwen-Llamafile/Qwen2.5-3B-Instruct-llamafile

-

Qwen-Llamafile/QwQ-32B-Preview-llamafile

-

bartowski-llamafile/gemma-2-9b-it-llamafil

等等。

当前魔搭平台上提供了数百个Llamafile格式的大模型,基本涵盖了所有头部的开源大模型。您可以如同下图所示,在模型页面左侧的框架选项中,选中Lllamfile,即可以直接筛选出平台上的Llamafile格式的模型。

当然您也可以通过对应的链接(https://www.modelscope.cn/models?libraries=Llamafile) 直达Llamafile模型列表页。

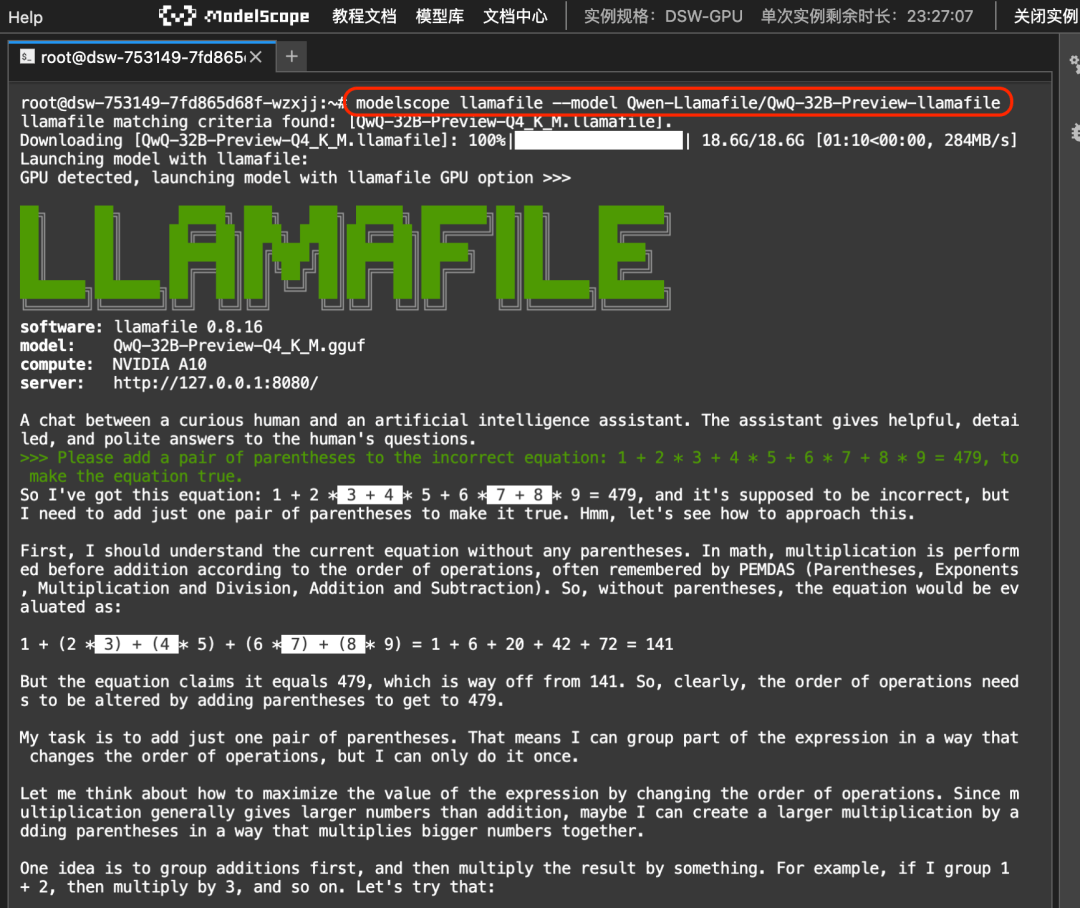

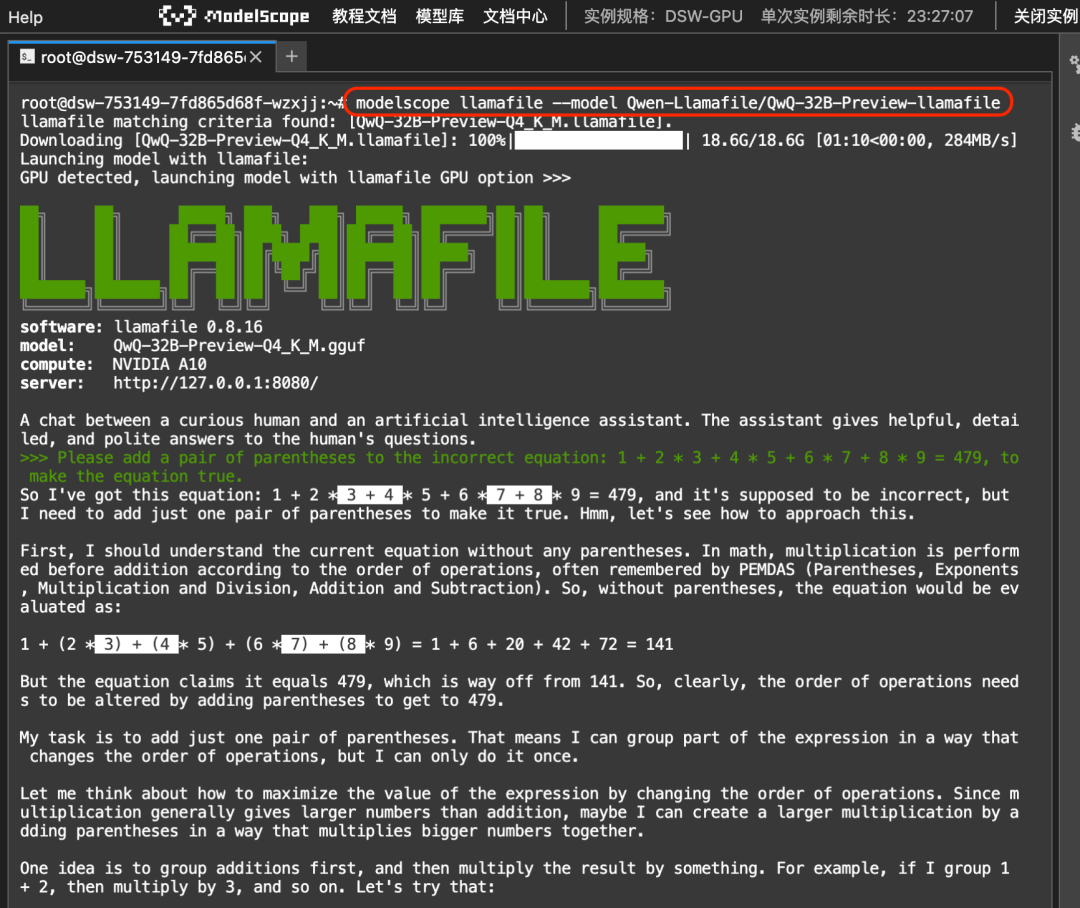

可以看看用llamafiel运行QwQ-32B-Preview模型的效果:

04.运行选项

除了上述基本用法以外,使用ModelScope命令行拉起llamafile大模型时,还可以指定精度,或指定模型库里的llamafile文件等配置。例如如果要使用不同精度的llamafile文件,可以通过--accuracy参数来指定,例如Q2_K,Q5_0等等。同时也可以通过--file参数,来直接指定模型库里的llamafile文件名,比如如下两种调用方式,是等效的,都是选择模型库里,精度为“Q2_K”的模型。

modelscope llamafile --model Qwen-Llamafile/Qwen2.5-3B-Instruct-llamafile --accuracy Q2_K

或

modelscope llamafile --model Qwen-Llamafile/Qwen2.5-3B-Instruct-llamafile --file qwen2.5-3b-instruct-q2_k.llamafile

更多的命令行选项,可以参见通过命令行帮助modelscope llamafile --help,或者参考ModelScope命令行工具的具体文档:https://www.modelscope.cn/docs/sdk/cli

05.多种调用方式

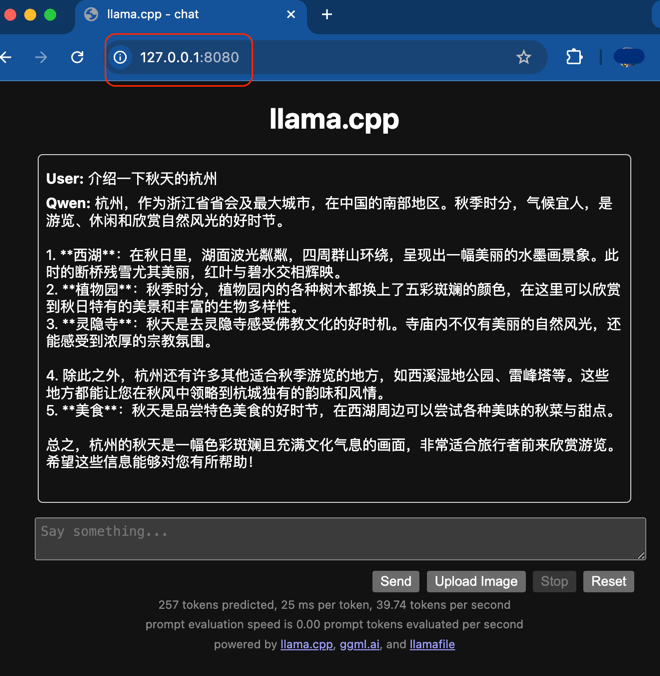

llamafile底层基于llama.cpp搭建。所以其也天然支持了llama.cpp的调用生态,包括在运行的同时,可以通过默认的http://127.0.0.1:8080/ 地址访问其WebUI,或者通过OpenAI兼容的API来进行模型调用。

06.One More Thing

魔搭平台上,当前已经支持了业界最为丰富的llamafile生态,如果还有什么模型的llamafile格式是你需要的,也欢迎留言里举手,我们会第一时间补充。

点击链接阅读原文:命令行介绍

更多推荐

已为社区贡献463条内容

已为社区贡献463条内容

所有评论(0)