ModernBERT-base:终于等到了 BERT 回归

BERT于 2018 年发布(史前人工智能!),但它至今仍被广泛使用,BERT的纯编码器架构使其成为每天出现的各种场景的理想选择,例如检索、分类和实体提取。

01.引言

BERT于 2018 年发布(史前人工智能!),但它至今仍被广泛使用,BERT的纯编码器架构使其成为每天出现的各种场景的理想选择,例如检索、分类和实体提取。

6 年后,社区终于推出了替代品!今天,Answer.AI和LightOn发布了 ModernBERT。ModernBERT 是一个新的模型系列,在速度和准确性方面都比 BERT 系列实现了改进。该模型采用了近年来在大型语言模型 (LLM) 方面的数十项进展,并将它们应用于 BERT 风格的模型,包括对架构和训练过程的更新。

Decoder-Only 模型生成类似人类内容的能力使 GenAI 能够实现令人惊叹的全新应用领域,例如生成艺术和交互式聊天。但是许多实际应用需要一个精简的模型!而且它不需要是一个生成模型。对于大多数公司来说,大参数量的Decoder-Only模型过于复杂且成本高昂,难以复制。比如Llama的405B模型,或者闭源模型,通常需要等待几秒钟才能获得完整的 API 回复。而实际上更加精简,处理速度更快的小模型,可能更加适合传统的自然语言理解场景。

Encoder-Only模型的输出是数值列表(embedding tensor)。您可能会说,编码器模型不是用文本回答,而是将其“答案”直接编码为这种压缩的数字形式。该向量是模型输入的压缩表示,这就是为什么仅编码器模型有时被称为表征模型。

与参数量较大的Decoder-Only的模型相比,Encoder-Only的 Transformer 模型(例如 BERT)在检索和分类任务中提供了出色的性能和尺寸权衡。ModernBERT,它将现代模型优化引入Encoder-Only的模型,并且与旧编码器相比实现了重大的改进。ModernBERT 模型在 2 万亿个具有原生 8192 序列长度的 token 上进行训练,在大量评估中表现出最佳结果,这些评估涵盖了各种分类任务以及不同域(包括代码)上的单向量和多向量检索。除了强大的下游性能外,ModernBERT 还是速度和内存效率最高的编码器,专为在常见 GPU 上进行推理而设计。

02.模型概述

ModernBERT 是一种现代化的双向编码器 Transformer 模型(BERT 风格),预训练于 2 万亿个英文和代码数据标记,原生上下文长度可达 8,192 个标记。ModernBERT 利用了最近的架构改进,如:

-

Rotary Positional Embeddings 支持最多 8192 个标记的序列。

-

Unpadding 以确保不会在填充标记上浪费计算资源,从而加快混合长度序列批次的处理时间。

-

GeGLU用 GeGLU 层替换原来的 MLP 层,可提高性能。

-

Alternating Attention :大多数注意力层采用 128 个标记的滑动窗口,而全局注意力机制每 3 层才使用一次。

-

Flash Attention 注意加速处理。

-

按照最近的“与硬件共同设计模型架构的案例”设计的模型,确保跨推理 GPU 的最高效率。

-

现代训练数据规模(2 trillion tokens)和混合数据(包括代码和数学数据)

模型表现

添加图片注释,不超过 140 字(可选)

ModernBERT 的原生长上下文长度使其非常适合需要处理长文档的任务,例如检索、分类和大型语料库内的语义搜索。该模型在大量的文本和代码语料库上进行了训练,适用于广泛的下游任务,包括代码检索和混合(文本 + 代码)语义搜索。

模型下载

ModernBERT有以下几种大小可供选择:

-

ModernBERT-base - 22 层,1.49 亿参数:https://modelscope.cn/models/AI-ModelScope/ModernBERT-base

-

ModernBERT-large - 28 层,3.95 亿参数:https://modelscope.cn/models/AI-ModelScope/ModernBERT-larg

03.模型推理

在魔搭社区长期免费的CPU资源上,即可流畅的运行ModernBERT模型,ModernBERT-base所需内存仅500M,处理速度ms级。

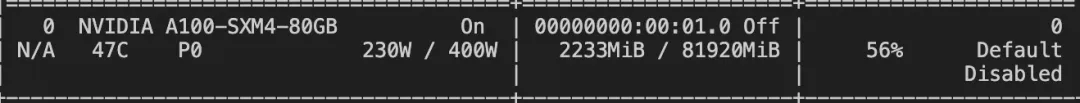

同时也可以使用GPU机器,更好的结合flash attention对ModernBERT模型加速。

添加图片注释,不超过 140 字(可选)

环境安装

!pip install git+https://github.com/huggingface/transformers.git使用 AutoModelForMaskedLM模型推理

from transformers import AutoTokenizer, AutoModelForMaskedLM

from modelscope import snapshot_download

model_id = snapshot_download("answerdotai/ModernBERT-base")

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForMaskedLM.from_pretrained(model_id)

text = "The capital of France is [MASK]."

inputs = tokenizer(text, return_tensors="pt")

outputs = model(**inputs)

# To get predictions for the mask:

masked_index = inputs["input_ids"][0].tolist().index(tokenizer.mask_token_id)

predicted_token_id = outputs.logits[0, masked_index].argmax(axis=-1)

predicted_token = tokenizer.decode(predicted_token_id)

print("Predicted token:", predicted_token)

# Predicted token: Paris使用pipeline:

import torch

from transformers import pipeline

from pprint import pprint

pipe = pipeline(

"fill-mask",

model="answerdotai/ModernBERT-base",

torch_dtype=torch.bfloat16,

)

input_text = "He walked to the [MASK]."

results = pipe(input_text)

pprint(results)04.模型微调

我们使用ms-swift对ModernBERT-base进行分类任务微调。ms-swift是魔搭社区官方提供的大模型与多模态大模型微调部署框架。

ms-swift开源地址:

https://github.com/modelscope/ms-swift

微调数据集:

https://modelscope.cn/datasets/simpleai/HC3

在开始微调之前,请确保您的环境已准备妥当。

git clone https://github.com/modelscope/ms-swift.git

cd ms-swift

pip install -e .[llm]微调脚本如下:

CUDA_VISIBLE_DEVICES=0 \

swift sft \

--model answerdotai/ModernBERT-base \

--dataset simpleai/HC3:finance_cls#20000 \

--task_type seq_cls \

--num_labels 2 \

--train_type lora \

--torch_dtype bfloat16 \

--num_train_epochs 1 \

--per_device_train_batch_size 16 \

--per_device_eval_batch_size 16 \

--learning_rate 1e-4 \

--lora_rank 8 \

--lora_alpha 32 \

--target_modules all-linear \

--freeze_vit true \

--gradient_accumulation_steps 1 \

--eval_steps 100 \

--save_steps 100 \

--save_total_limit 5 \

--logging_steps 5 \

--max_length 2048 \

--output_dir output \

--warmup_ratio 0.05 \

--dataloader_num_workers 4训练显存资源:

添加图片注释,不超过 140 字(可选)

自定义数据集格式如下,只需要指定`--dataset <dataset_path>`即可:

{"messages": [{"role": "user", "content": "今天天气真好呀"}], "label": 1}

{"messages": [{"role": "user", "content": "今天真倒霉"}], "label": 0}

{"messages": [{"role": "user", "content": "好开心"}], "label": 1}训练分类acc:

添加图片注释,不超过 140 字(可选)

训练完成后,使用以下命令对训练时的验证集进行推理:

这里`--adapters`需要替换成训练生成的last checkpoint文件夹. 由于adapters文件夹中包含了训练的参数文件,因此不需要额外指定`--model`。

CUDA_VISIBLE_DEVICES=0 \

swift infer \

--adapters output/vx-xxx/checkpoint-xxx \

--max_batch_size 16 \

--load_data_args true微调后模型部署:

CUDA_VISIBLE_DEVICES=0 \

swift deploy \

--adapters output/vx-xxx/checkpoint-xxx部署完成后,使用以下命令进行客户端调用:

curl http://localhost:8000/v1/chat/completions -H "Content-Type: application/json" -d '{

"model": "ModernBERT-base",

"messages": [{"role": "user", "content": "<content>"}]

}'05.结论

本文介绍了 ModernBERT 模型,这是一组新型、先进的小型高效编码器模型,最终使 BERT 得到了急需的改造。

ModernBERT 证明,Encoder-Only的模型可以通过现代方法得到改进。它们在某些任务上继续提供非常强大的性能,提供极具吸引力的尺寸/性能比。

注:本文部分内容引用自blog:https://huggingface.co/blog/modernbert

点击链接阅读原文:ModelScope 魔搭社区

更多推荐

已为社区贡献652条内容

已为社区贡献652条内容

所有评论(0)