音频语言模型正在获得显著的关注,但边缘部署选项仍然非常有限。虽然 llama.cpp 和 Ollama 支持文本和视觉模型,但它们目前不支持音频模型。

Qwen2-Audio是一个 70亿参数量 SOTA 多模态模型,可处理音频和文本输入。它无需 ASR 模块即可实现语音交互,提供音频分析功能,并支持超过8种语言和方言,例如中文、英语、粤语、法语、意大利语、西班牙语、德语和日语。

魔搭社区和Nexa SDK合作,一键运行魔搭社区GGUF模型,包括本次发布的Qwen2-Audio的GGUF格式。

Github repo:

https://github.com/NexaAI/nexa-sdk

NexaAI 魔搭模型repo:

https://modelscope.cn/organization/NexaAIDev

01.Nexa SDK:一句话运行魔搭社区模型

使用魔搭社区免费CPU算力使用Nexa一键运行魔搭社区GGUF模型。

首先,安装Nexa SDK

pip install nexaai

一句话运行魔搭社区模型

nexa run -ms Qwen/Qwen2.5-3B-Instruct-GGUF

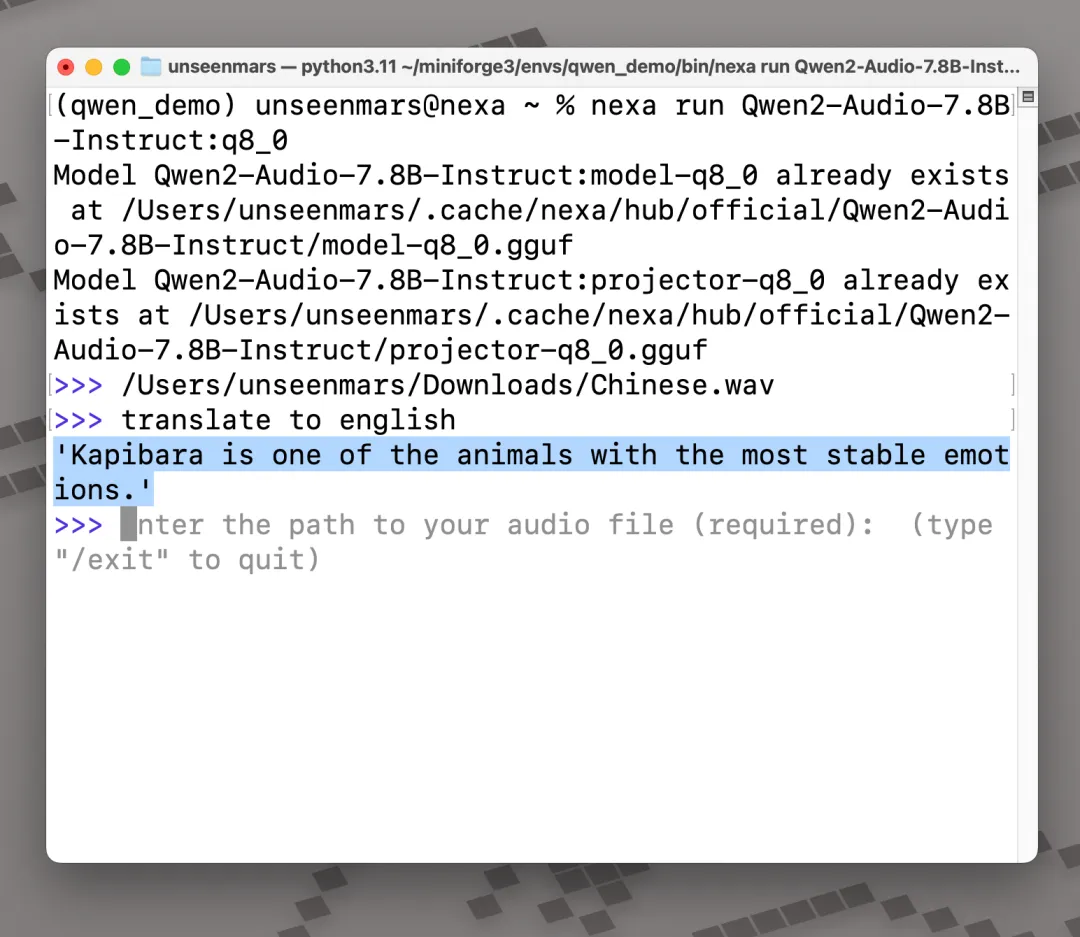

02.Nexa SDK:将Qwen2-Audio引入边缘设备

在魔搭社区的免费Notebook算力上运行Qwen-Audio-7B-GGUF

首先,安装Nexa SDK(更多安装方式参考:https://github.com/NexaAI/nexa-sdk?tab=readme-ov-file#install-option-1-executable-installer)

curl -fsSL https://public-storage.nexa4ai.com/install.sh | sh

然后,运行Qwen2-Audio模型

nexa run qwen2audio

或者运行的同时支持Streamlit 本地WebUI

nexa run qwen2audio -st

也可以直接在ModelScope上运行Qwen-Audio-7B-GGUF

nexa run -ms NexaAIDev/Qwen2-Audio-7B-GGUF

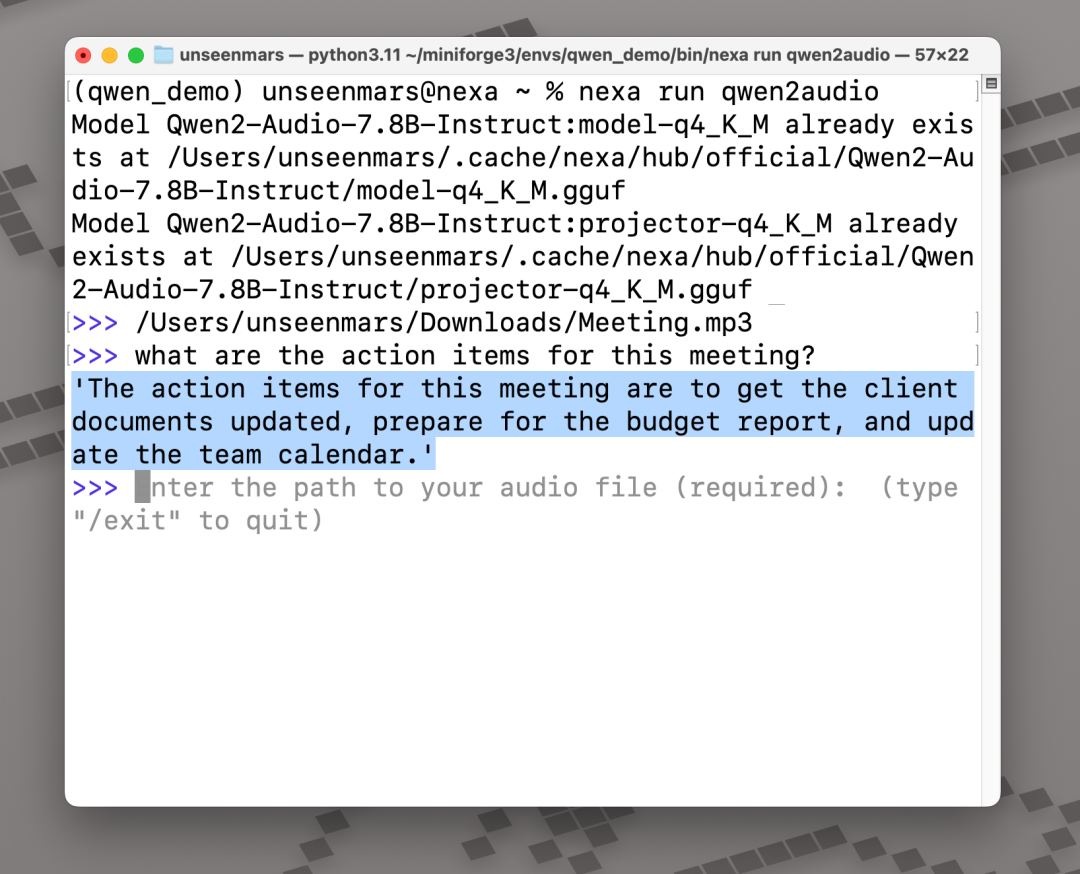

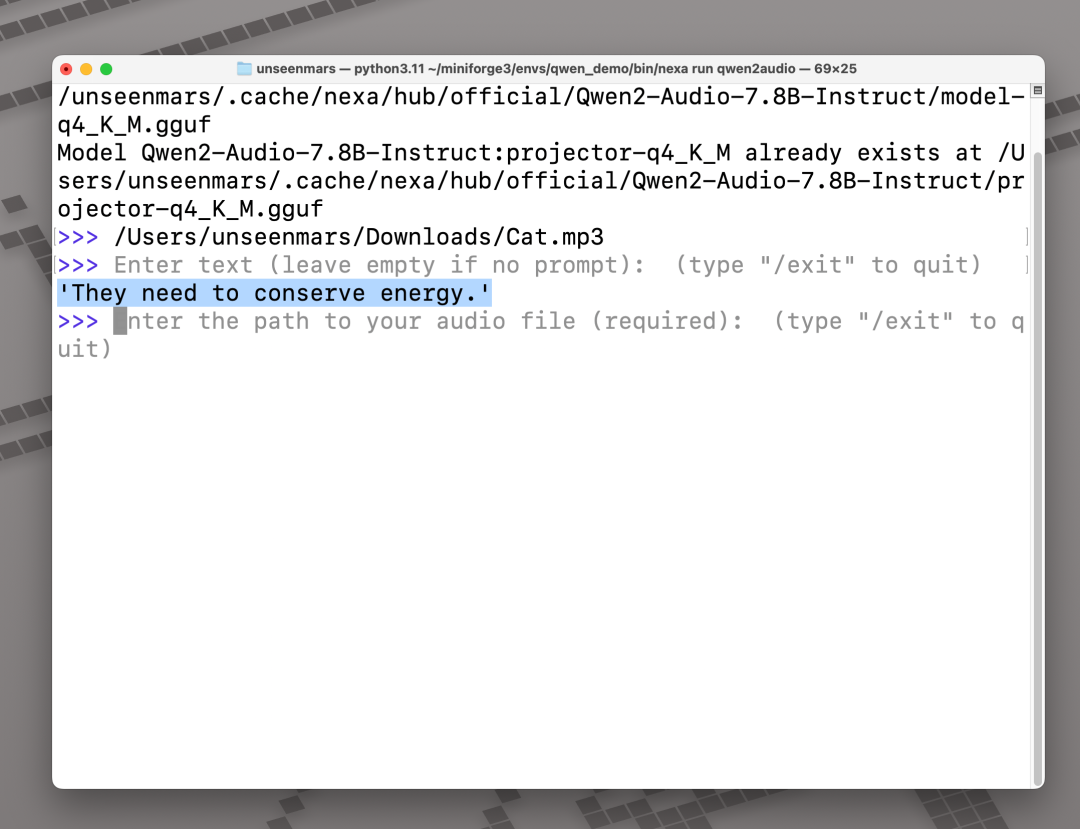

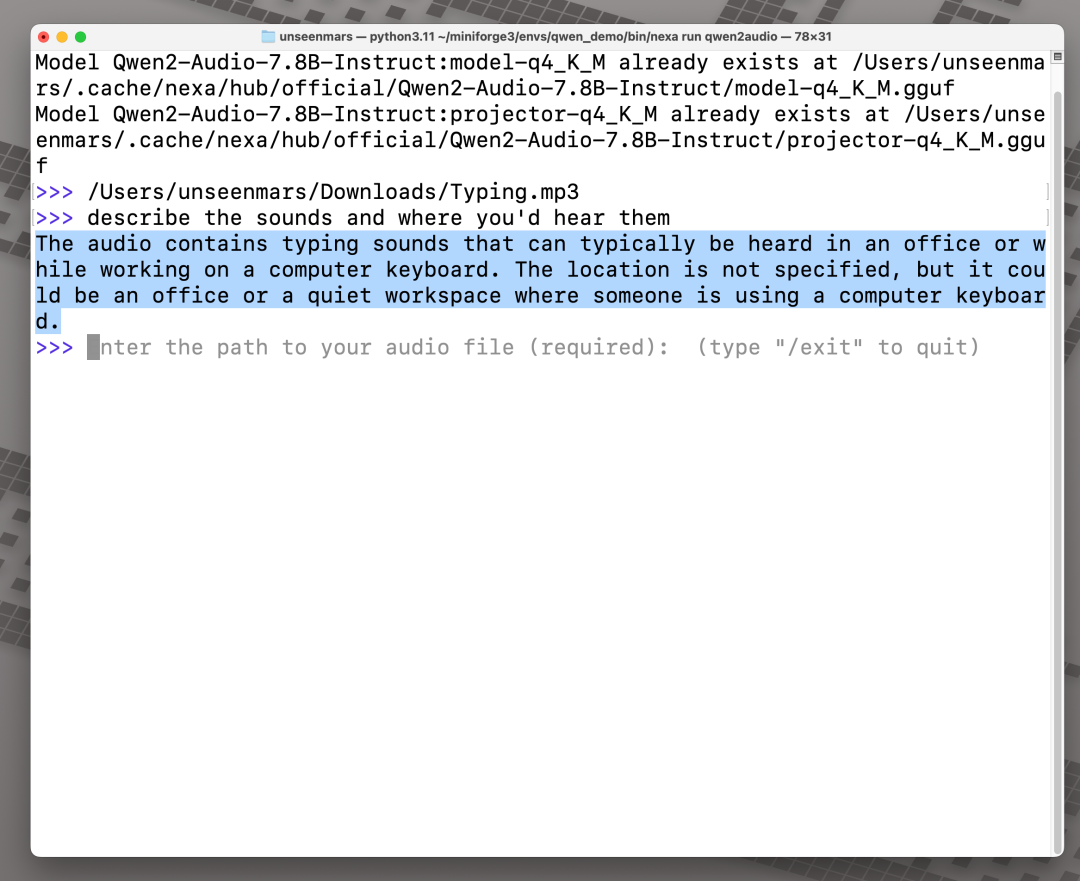

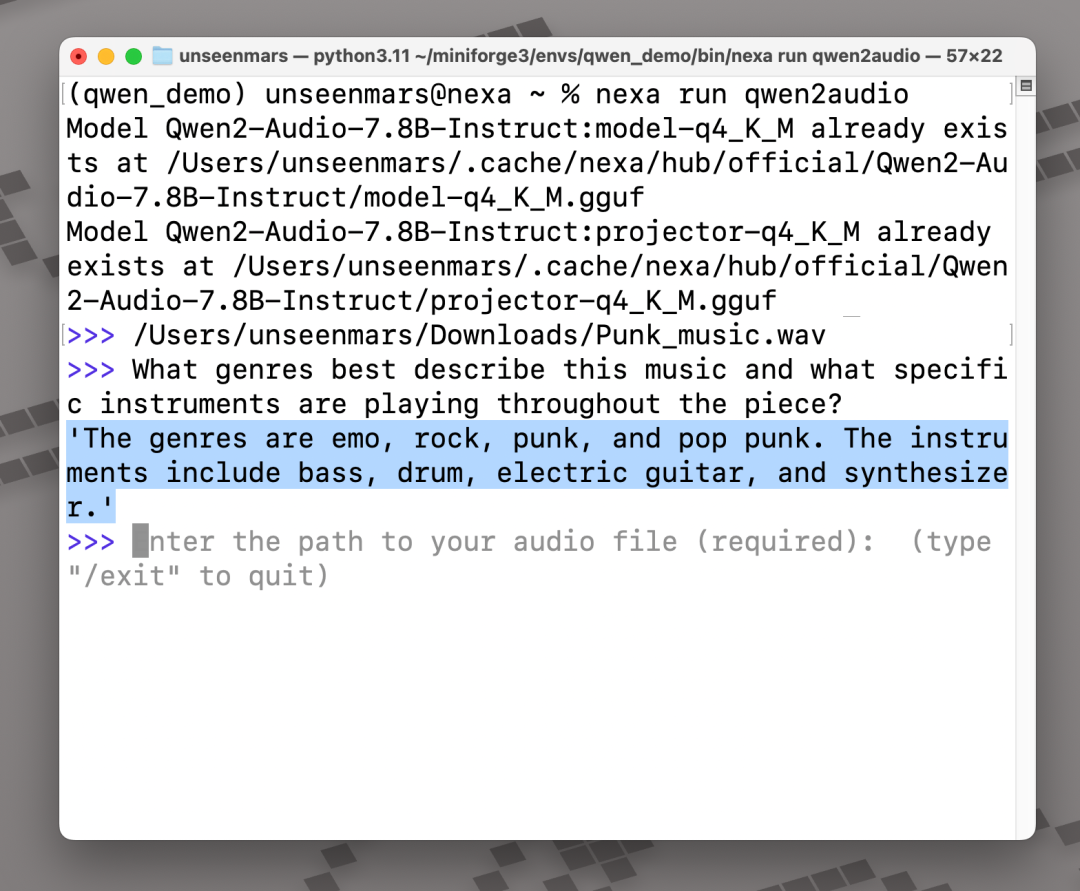

将音频文件存储在终端中(或在 Linux 上输入文件路径)。将文本提示以及语音文件地址直接输入模型。

01.快速说明

💻 默认的 q4_K_M 版本需要 4.2GB 的 RAM。

下图列出了在您的设备上运行 Qwen2-Audio 需要多少 RAM

|

Qwen2-Audio量化版本 |

模型权重文件 |

所需RAM |

|

gguf-fp16 |

14.50 GB |

16.80 GB |

|

gguf-q4_0 |

4.20 GB |

4.20 GB |

|

gguf-q8_0 |

7.70 GB |

8.40 GB |

|

gguf-q2_K |

2.90 GB |

2.10 GB |

|

gguf-q3_K_L |

3.90 GB |

3.15 GB |

|

gguf-q3_K_M |

3.70 GB |

3.15 GB |

|

gguf-q3_K_S |

3.30 GB |

3.15 GB |

|

gguf-q4_1 |

4.60 GB |

4.20 GB |

|

gguf-q4_K_M |

4.50 GB |

4.20 GB |

|

gguf-q4_K_S |

4.30 GB |

4.20 GB |

|

gguf-q5_0 |

5.10 GB |

5.25 GB |

|

gguf-q5_1 |

5.50 GB |

5.25 GB |

|

gguf-q5_K_M |

5.20 GB |

5.28 GB |

|

gguf-q5_K_S |

5.10 GB |

5.28 GB |

|

gguf-q6_K |

5.90 GB |

6.30 GB |

🎵 为了获得最佳性能,请使用 16kHz.wav音频格式。支持其他音频格式和采样率,并将自动转换为所需格式。

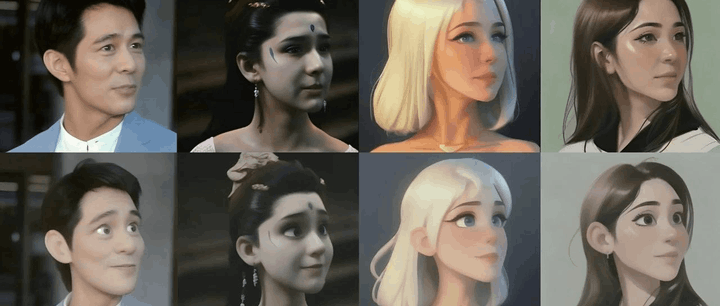

02.使用案例

语音处理与理解

会议录音

多模式聊天

why do you think cat sleep so much?

音频分析与识别

键盘打字的声音

音乐分析和识别

Punk music (loud sound warning)

翻译

Chinese

要了解更多用例和模型功能,请查看Qwen的博客和Github:

博客:

https://qwenlm.github.io

Github:

https://github.com/QwenLM/Qwen2-Audio

对于开发人员来说,下一步将是服务器部署和 Python 接口。请关注Nexa SDK以获取更新,并提交您的任何需求。

感谢 Nexa AI 团队。

点击链接阅读原文:https://modelscope.cn/organization/NexaAIDev

已为社区贡献456条内容

已为社区贡献456条内容

所有评论(0)