Qwen2.5-Coder震撼深夜发布开源,开启Prompt编程新纪元!

通义千问团队开源「强大」、「多样」、「实用」的 Qwen2.5-Coder 全系列,致力于持续推动 Open Code LLMs 的发展。强大:Qwen2.5-Coder-32B-Instruct 成为目前 SOTA 的开源代码模型,代码能力追平 GPT-4o。在展现出强大且全面的代码能力的同时,具备良好的通用和数学能力;多样:在之前开源的两个尺寸 1.5B/7B 的基础上,本次开源共带来四个尺寸

01.引 言

通义千问团队开源「强大」、「多样」、「实用」的 Qwen2.5-Coder 全系列,致力于持续推动 Open Code LLMs 的发展。

-

强大:Qwen2.5-Coder-32B-Instruct 成为目前 SOTA 的开源代码模型,代码能力追平 GPT-4o。在展现出强大且全面的代码能力的同时,具备良好的通用和数学能力;

-

多样:在之前开源的两个尺寸 1.5B/7B 的基础上,本次开源共带来四个尺寸的模型,包括 0.5B/3B/14B/32B。截止目前 Qwen2.5-Coder 已经覆盖了主流的六个模型尺寸,以满足不同开发者的需要;

-

实用:在两种场景下探索 Qwen2.5-Coder 的实用性,包括代码助手和 Artifacts,一些样例展示出 Qwen2.5-Coder 在实际场景中应用的潜力;

强大:代码能力达到开源模型 SOTA

-

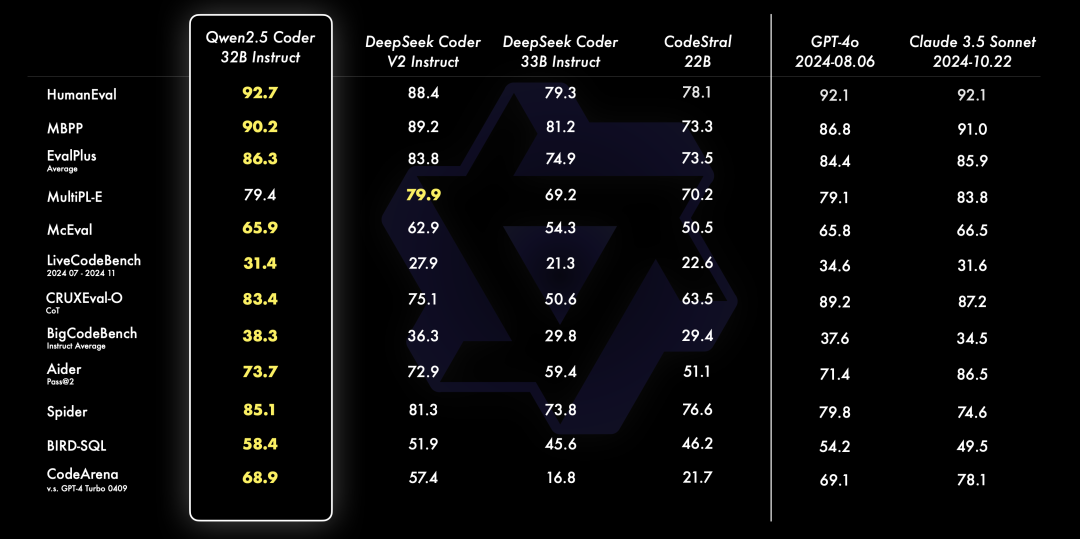

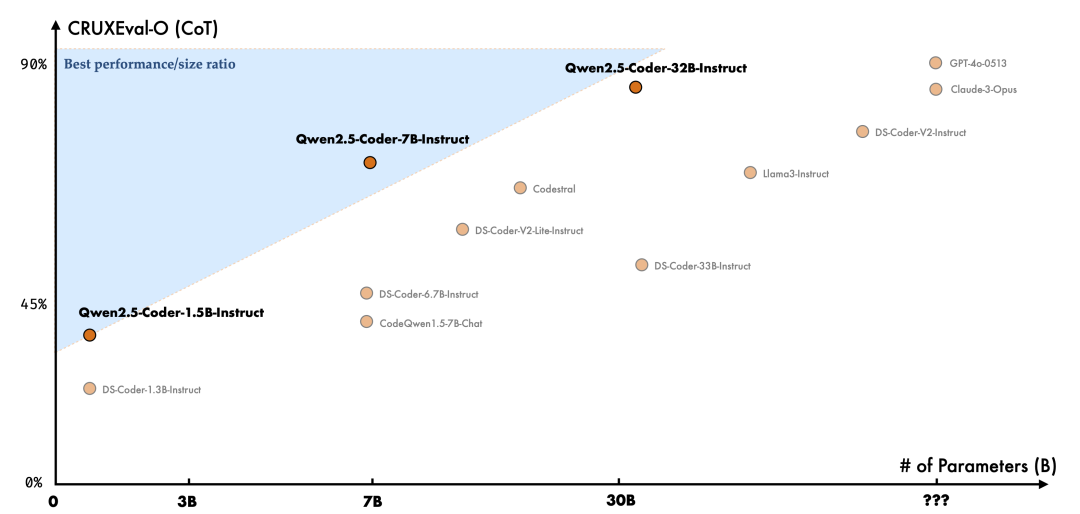

代码生成:Qwen2.5-Coder-32B-Instruct 作为本次开源的旗舰模型,在多个流行的代码生成基准(EvalPlus, LiveCodeBench, BigCodeBench)上都取得了开源模型中的最佳表现,并且达到和 GPT-4o 有竞争力的表现。

-

代码修复:代码修复是一个重要的编程能力,Qwen2.5-Coder-32B-Instruct 可以帮助用户修复代码中的错误,让编程更加高效。Aider 是流行的代码修复的基准,Qwen2.5-Coder-32B-Instruct 达到 73.7 分,在 Aider 上的表现与 GPT-4o 相当。

-

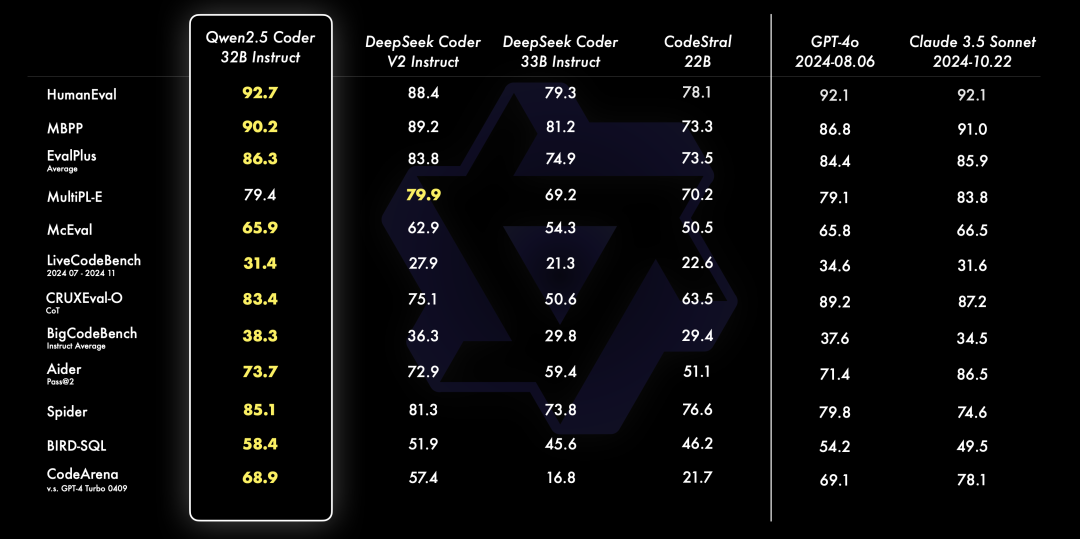

代码推理:代码推理指的是模型能否学习代码执行的过程,准确的预测模型的输入与输出。上个月发布的 Qwen2.5-Coder-7B-Instruct 已经在代码推理能力上展现出了不俗的表现,本次 32B 模型在代码推理上更进一步。

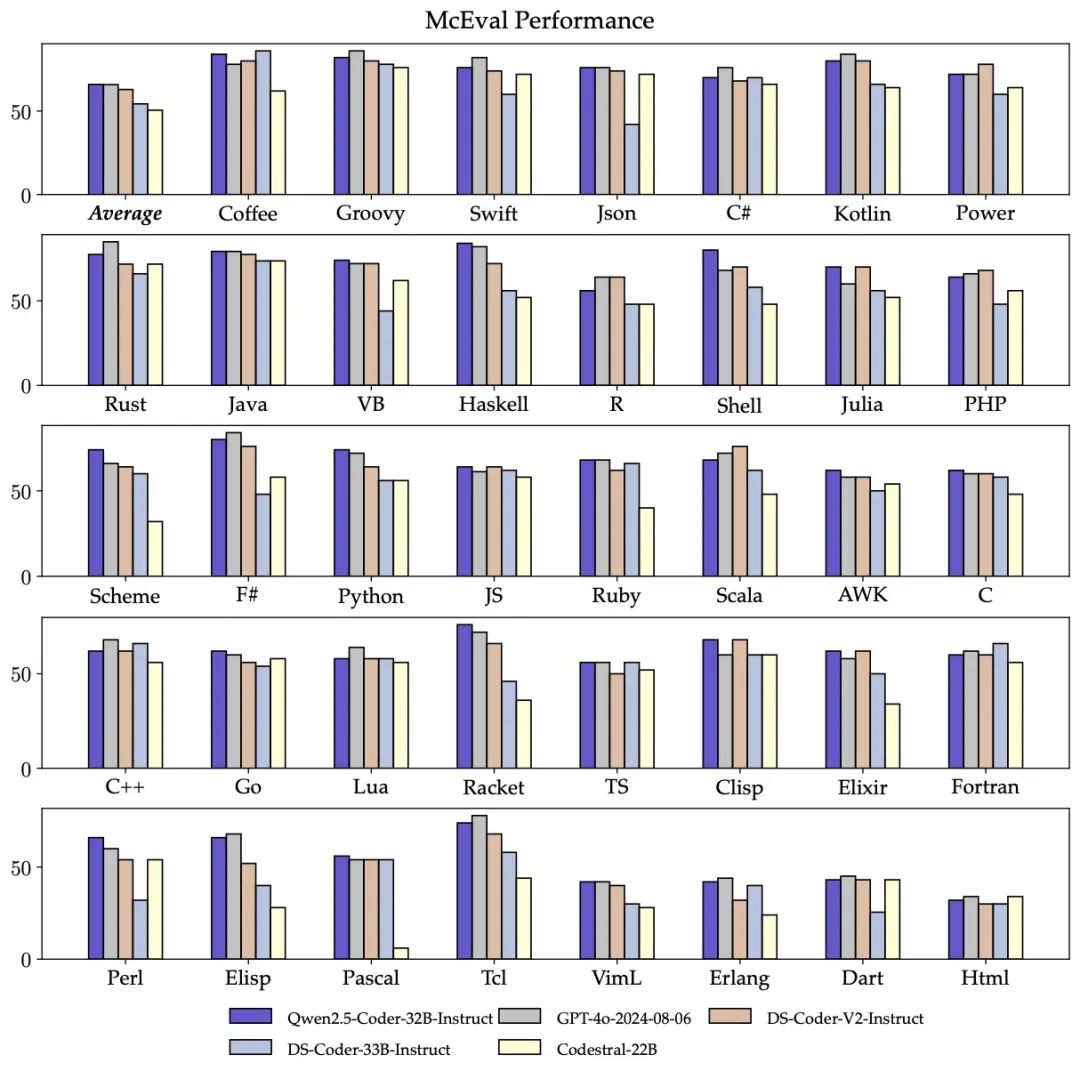

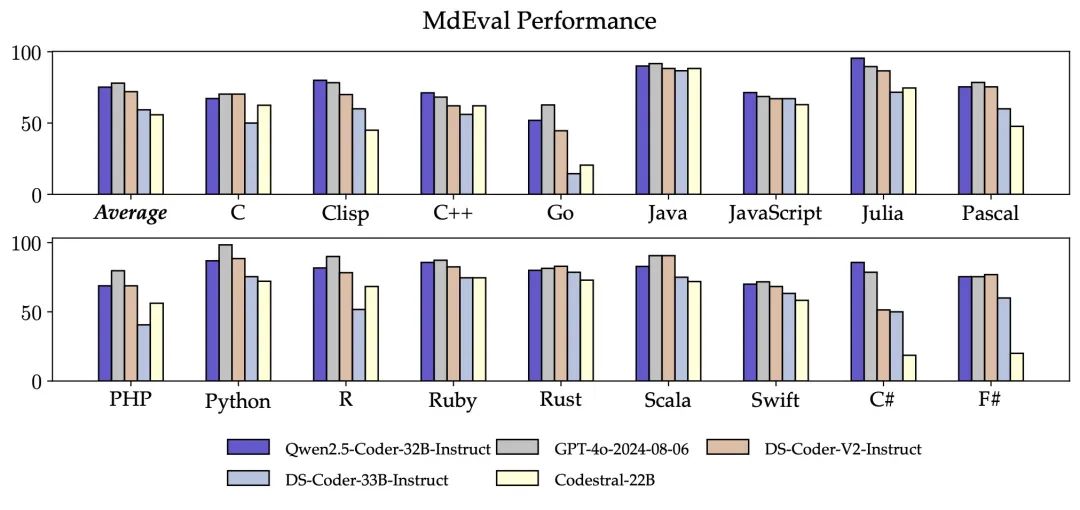

- 多编程语言:智能的编程助手应该熟悉所有编程语言,Qwen2.5-Coder-32B-Instruct 在 40 多种编程语言上表现出色,在 McEval 上取得了 65.9 的分数,其中 Haskell, Racket 等语言表现令人印象深刻,这得益于在预训练阶段独特的数据清洗和配比。

另外,Qwen2.5-Coder-32B-Instruct 的多编程语言的代码修复能力仍然令人惊喜,这将有助于用户理解和修改自己熟悉的编程语言,极大缓解陌生语言的学习成本。与 McEval 类似,MdEval 是多编程语言的代码修复基准,Qwen2.5-Coder-32B-Instruct 在 MdEval 上取得了 75.2 的分数,在所有开源模型中排名第一。

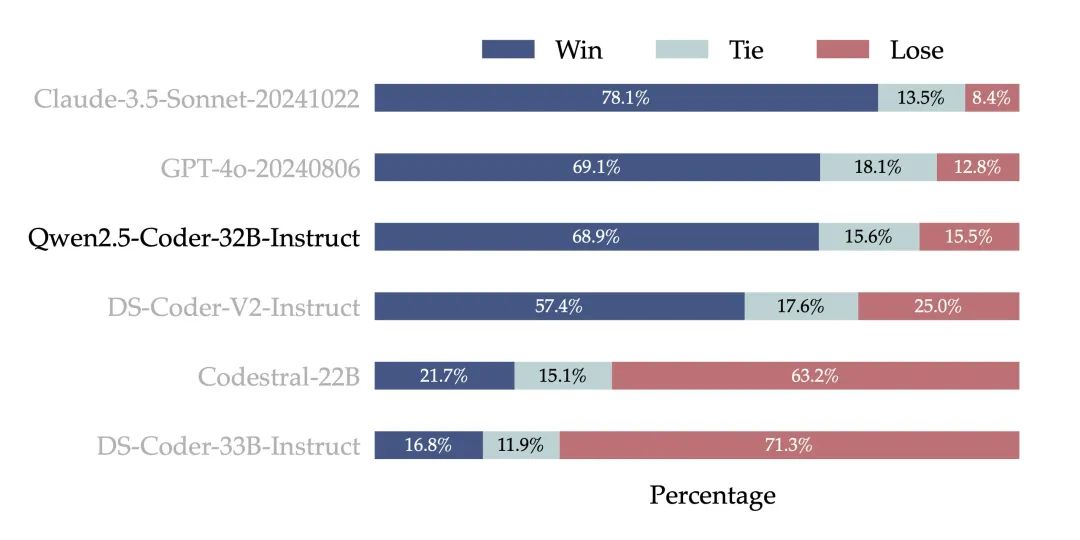

- 人类偏好对齐:为了检验 Qwen2.5-Coder-32B-Instruct 在人类偏好上的对齐表现,构建了一个来自内部标注的代码偏好评估基准 Code Arena(类似 Arena Hard)。采用 GPT-4o 作为偏好对齐的评测模型,采用 ‘A vs. B win’ 的评测方式,即在测试集实例中,模型 A 的分数超过模型 B 的百分比。下图结果表现出 Qwen2.5-Coder-32B-Instruct 在偏好对齐方面的优势。

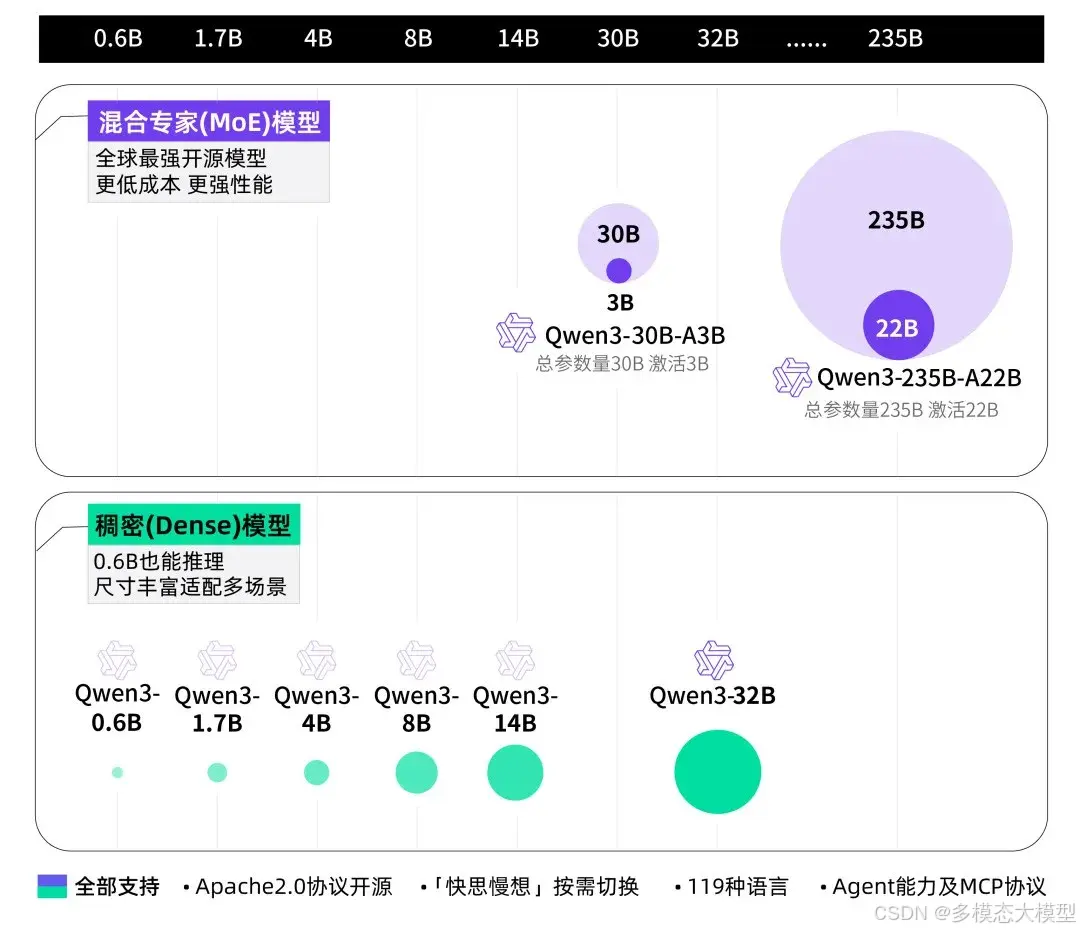

全面:丰富的模型尺寸

本次 Qwen2.5-Coder 开源了丰富的模型尺寸,共包含 0.5B/1.5B/3B/7B/14B/32B 六个尺寸,不仅能够满足开发者在不同资源场景下的需求,还能给研究社区提供良好的实验场。下表是详细的模型信息:

|

Models |

Params |

Non-Emb Params |

Layers |

Heads (KV) |

Tie Embedding |

Generation Length |

License |

|

Qwen2.5-Coder-0.5B |

0.49B |

0.36B |

24 |

14 / 2 |

Yes |

32K |

Apache 2.0 |

|

Qwen2.5-Coder-1.5B |

1.54B |

1.31B |

28 |

12 / 2 |

Yes |

32K |

Apache 2.0 |

|

Qwen2.5-Coder-3B |

3.09B |

2.77B |

36 |

16 / 2 |

Yes |

32K |

Qwen Research |

|

Qwen2.5-Coder-7B |

7.61B |

6.53B |

28 |

28 / 4 |

No |

128K |

Apache 2.0 |

|

Qwen2.5-Coder-14B |

14.7B |

13.1B |

48 |

40 / 8 |

No |

128K |

Apache 2.0 |

|

Qwen2.5-Coder-32B |

32.5B |

31.0B |

64 |

40 / 8 |

No |

128K |

Apache 2.0 |

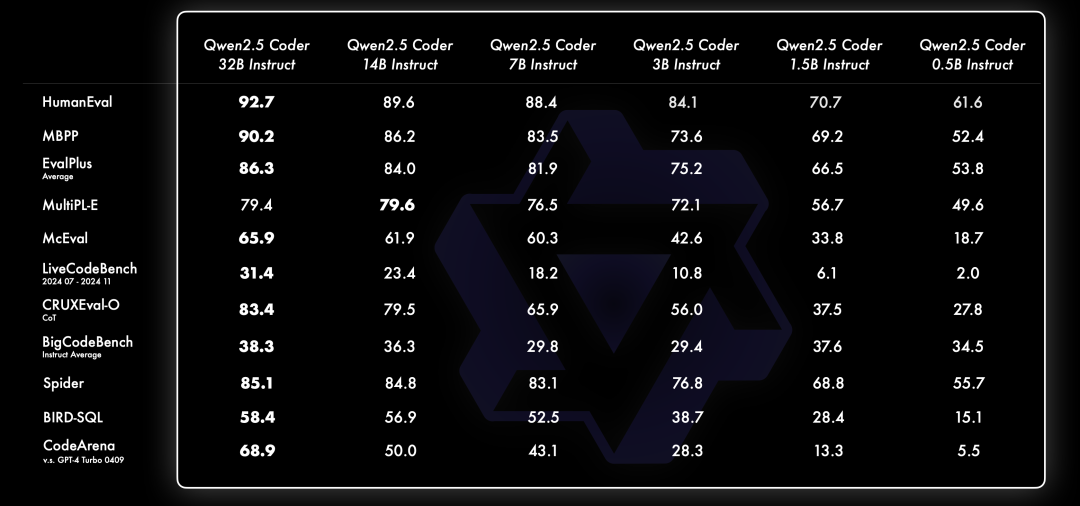

一直相信 Scaling Law 哲学。评估了不同尺寸的 Qwen2.5-Coder 在所有数据集上的表现,以验证 Scaling 在 Code LLMs 上的有效性。对于每一个尺寸,都开源了 Base 和 Instruct 模型,其中 Instruct 模型作是一个可以直接聊天的官方对齐模型,Base 模型作为开发者微调自己模型的基座。

下面是不同尺寸的 Instruct 模型表现:

模型尺寸和模型效果之间符合预期的存在正相关,并且 Qwen2.5-Coder 在所有尺寸下都取得了 SOTA 的表现,这鼓励着继续探索更大尺寸的 Coder。

模型许可

Qwen2.5-Coder 0.5B/1.5B/7B/14B/32B 采用 Apache 2.0 的许可,3B 为 Research Only 许可;

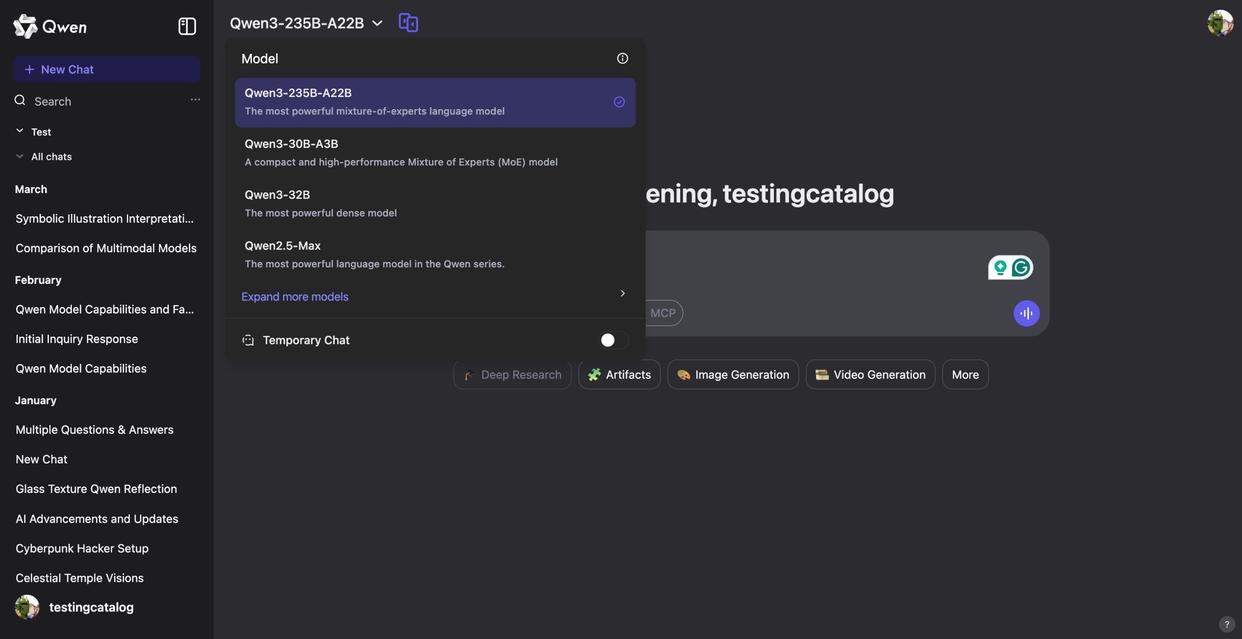

02.模型链接和体验

Qwen2.5-Coder模型链接:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

模型集合demo链接:

https://modelscope.cn/studios/Qwen/Qwen2.5-Coder-demo

- 小程序体验:

Artifacts体验链接:

https://modelscope.cn/studios/Qwen/Qwen2.5-Coder-Artifacts

03.模型推理

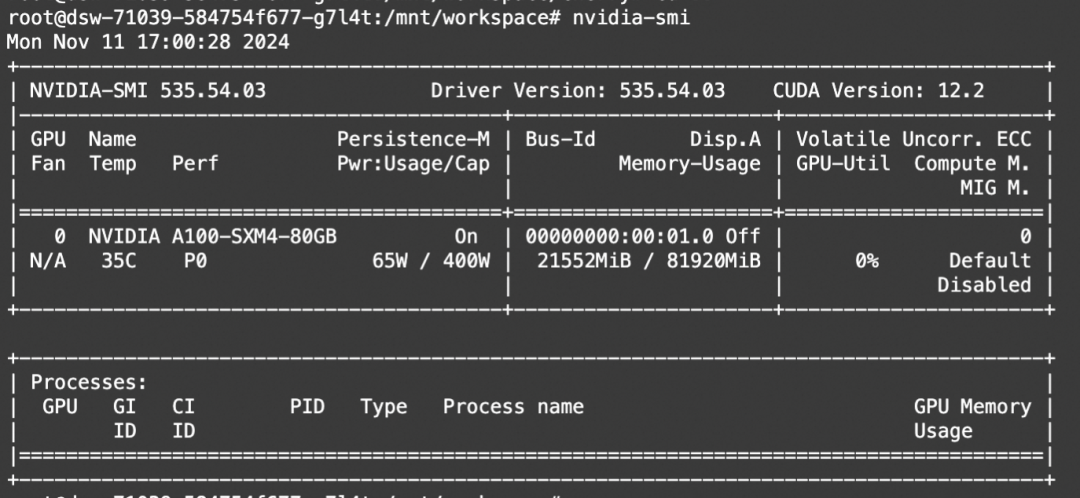

transformers: 单卡运行Qwen2.5-32B-Instrtuct量化模型。

from modelscope import AutoModelForCausalLM, AutoTokenizer`` ``model_name = "Qwen/Qwen2.5-Coder-32B-Instruct-GPTQ-Int4"`` ``model = AutoModelForCausalLM.from_pretrained(` `model_name,` `torch_dtype="auto",` `device_map="auto"``)``tokenizer = AutoTokenizer.from_pretrained(model_name)`` ``prompt = "write a quick sort algorithm."`` ``messages = [` `{"role": "system", "content": "You are Qwen, created by Alibaba Cloud. You are a helpful assistant."},` `{"role": "user", "content": prompt}``]``text = tokenizer.apply_chat_template(` `messages,` `tokenize=False,` `add_generation_prompt=True``)``model_inputs = tokenizer([text], return_tensors="pt").to(model.device)`` ``generated_ids = model.generate(` `**model_inputs,` `max_new_tokens=512``)``generated_ids = [` `output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)``]`` ``response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]``

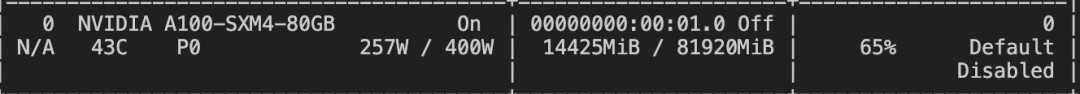

显存占用:

Ollama:一行命令使用Ollama运行魔搭Qwen2.5-Coder GGUF模型

- 设置

ollama下启用

ollama serve

- ollama run ModelScope任意GGUF模型

ollama run modelscope.cn/Qwen/Qwen2.5-32B-Instruct-GGUF

在安装了Ollama的环境上(建议使用>=0.3.12版本),直接通过上面的命令行,就可以直接在本地运行 Qwen2.5-32B-Instruct-GGUF模型。

vLLM,推理加速

pip install vllm -U``export VLLM_USE_MODELSCOPE=True``vllm serve Qwen/Qwen2.5-Coder-7B-Instruct

推理代码:

from openai import OpenAI`` ``# Modify OpenAI's API key and API base to use vLLM's API server.``openai_api_key = "EMPTY"``openai_api_base = "http://localhost:8000/v1"``client = OpenAI(` `api_key=openai_api_key,` `base_url=openai_api_base,``)``completion = client.completions.create(model="Qwen/Qwen2.5-Coder-1.5B-Instruct",` `prompt="San Francisco is a")``print("Completion result:", completion)

04.模型微调

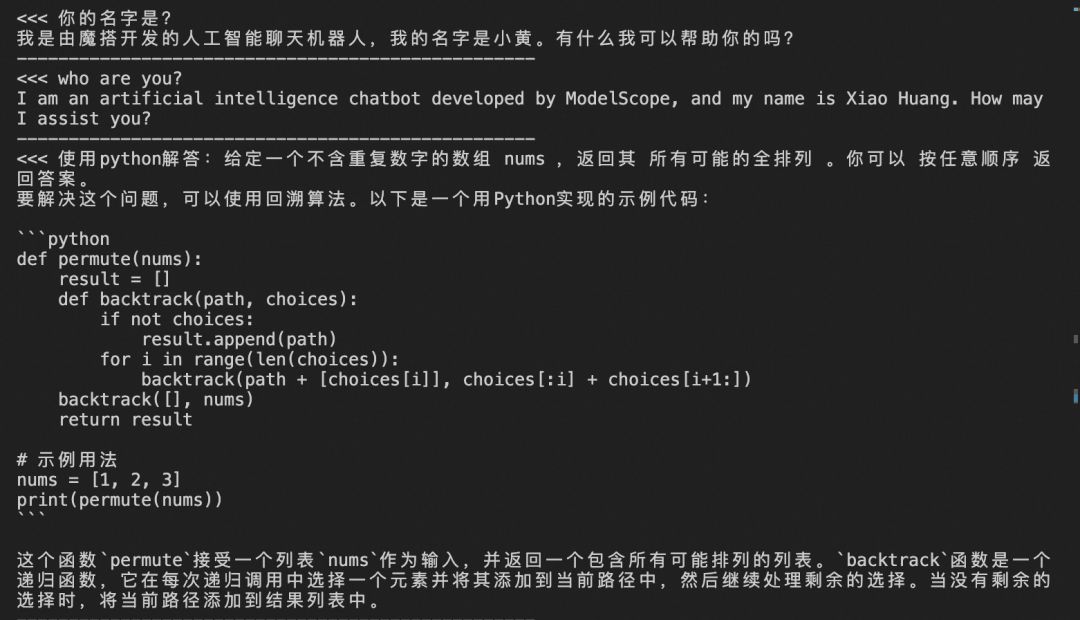

我们介绍使用ms-swift对qwen2.5-coder进行自我认知微调,并对微调后模型进行推理。swift开源地址:https://github.com/modelscope/ms-swift

自我认知数据集链接:https://modelscope.cn/datasets/swift/self-cognition

如果需要使用其他数据集进行微调,只需要修改 --dataset即可。自定义dataset支持传入本地路径、modelscope和huggingface中的dataset_id。文档可以查看:https://swift.readthedocs.io/zh-cn/latest/Instruction/%E8%87%AA%E5%AE%9A%E4%B9%89%E4%B8%8E%E6%8B%93%E5%B1%95.html#id3

在开始微调之前,请确保您的环境已正确安装:

# 安装ms-swift``git clone https://github.com/modelscope/ms-swift.git``cd swift``pip install -e .[llm]

微调脚本:

# Experimental environment: A10, 3090, V100, ...``# 15GB GPU memory``CUDA_VISIBLE_DEVICES=0 swift sft \` `--model_type qwen2_5-coder-3b-instruct \` `--model_id_or_path qwen/Qwen2.5-Coder-3B-Instruct \` `--dataset swift/self-cognition#500 \` `AI-ModelScope/Magpie-Qwen2-Pro-200K-Chinese#500 \` `AI-ModelScope/Magpie-Qwen2-Pro-200K-English#500 \` `--logging_steps 5 \` `--max_length 4096 \` `--learning_rate 1e-4 \` `--output_dir output \` `--lora_target_modules ALL \` `--model_name 小黄 'Xiao Huang' \` `--model_author 魔搭 ModelScope \` `--system 'You are a helpful assistant.'

微调显存消耗:

微调后推理脚本如下,这里的ckpt_dir需要修改为训练生成的last checkpoint文件夹。

# Experimental environment: A10, 3090, V100, ...``# 直接推理``CUDA_VISIBLE_DEVICES=0 swift infer \` `--ckpt_dir output/qwen2_5-coder-3b-instruct/vx-xxx/checkpoint-xxx`` ``# 使用vLLM进行推理加速``CUDA_VISIBLE_DEVICES=0 swift infer \` `--ckpt_dir output/qwen2_5-coder-3b-instruct/vx-xxx/checkpoint-xxx \` `--infer_backend vllm --max_model_len 8192 --merge_lora true

推理结果:

05.模型应用:Cursor,Artifacts 和 interpreter

实用的 Coder 一直是Qwen的愿景,为此本次探索了 Qwen2.5-Coder 在代码助手、 Artifacts 、interpreter场景下的实际表现。

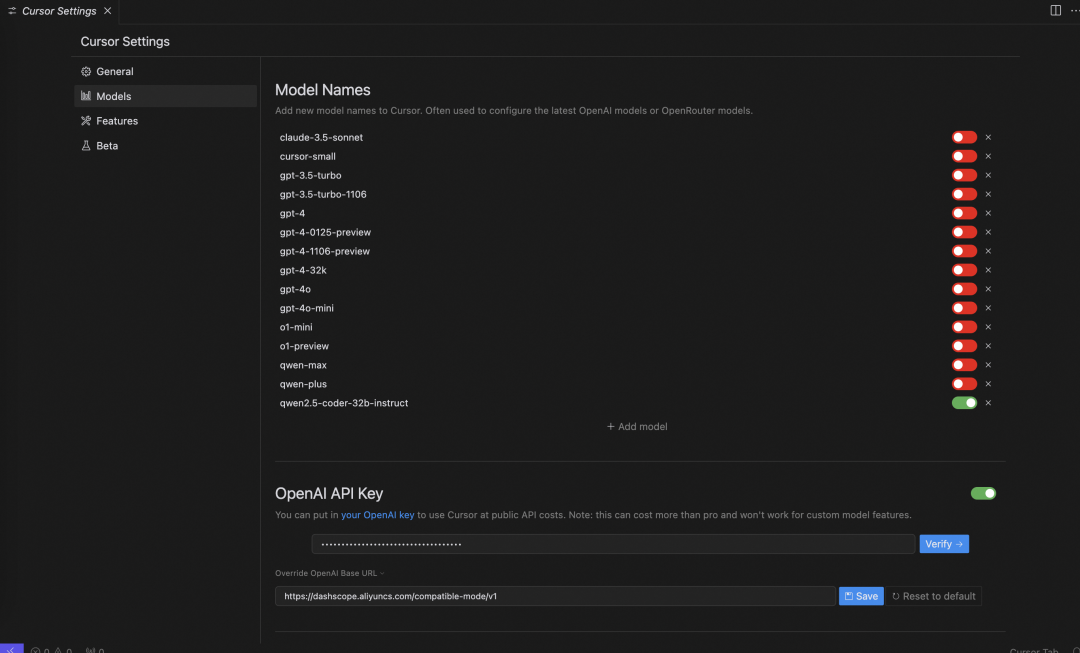

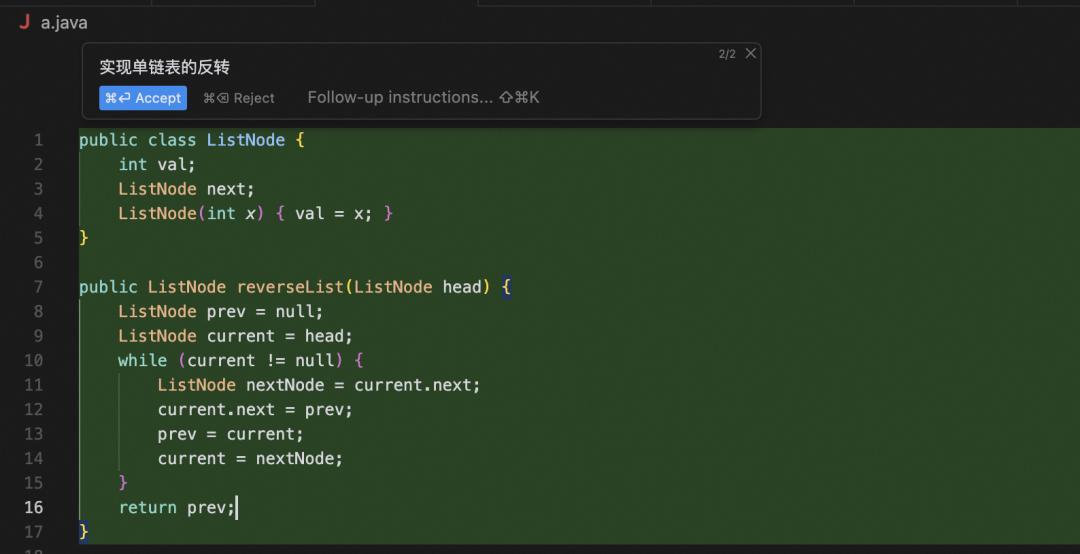

Qwen2.5-Coder 遇到 Cursor:万能代码小助手

智能代码助手目前已经得到广泛的应用,但目前大多依赖闭源模型,希望 Qwen2.5-Coder 的出现能够为开发者提供一个友好且强大的选择。

配置Qwen2.5-Coder-32B-Instruct的openai兼容api(URL和API Key)

体验Qwen2.5-Coder强大的生成/编辑/补全能力吧!(Command+K)

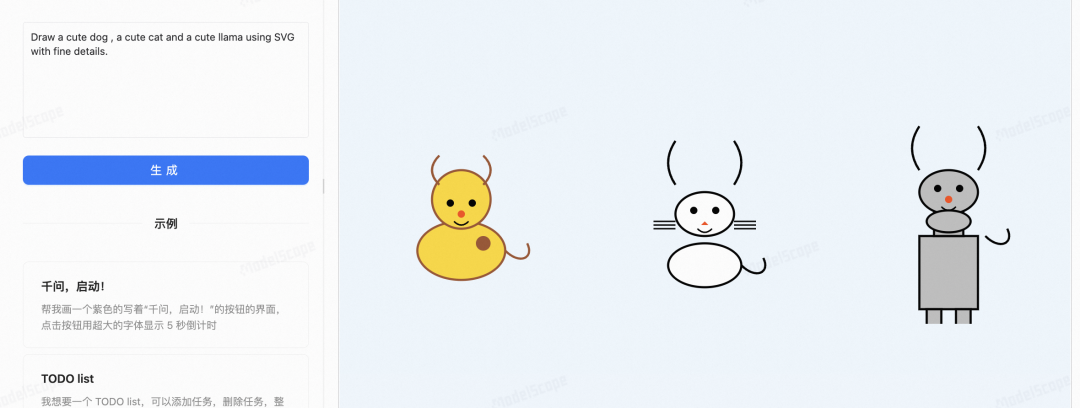

Qwen2.5-Coder 遇到 Artifacts:prompt编程不是梦

Artifacts 是代码生成的重要应用之一,帮助用户创作一些适合可视化的作品,clone魔搭创空间,即可本地搭建一个Artifacts。

git clone https://www.modelscope.cn/studios/Qwen/Qwen2.5-Coder-Artifacts.git``cd Qwen2.5-Coder-Artifacts``pip install -r requirements.txt``pip install gradio``python app.py

制作游戏

制作动图

SVG作画

Qwen2.5-Coder 遇到 Interpreter:AI操作电脑

在MAC安装环境

pip install open-interpreter

进入Python环境:

from interpreter import interpreter``interpreter.llm.api_base = "YOUR_BASE_URL"``interpreter.llm.api_key = "YOUR_API_KEY"``interpreter.llm.model = "openai/Qwen-Coder-32B-Instruct"``interpreter.chat("Can you set my system to light mode?")

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)