通义灵码 + 魔搭MCP:全流程构建创空间应用

最近,通义灵码上线 MCP(ModelScope Cloud Platform)功能,从之前代码生成及修改的基础功能,到可以使用MCP服务连接更多功能,开发者可以实现从 代码爬取、模型推理到应用部署

00.前言

最近,通义灵码上线 MCP(ModelScope Cloud Platform)功能,从之前代码生成及修改的基础功能,到可以使用MCP服务连接更多功能,开发者可以实现从 代码爬取、模型推理到应用部署 的全流程自动化服务。同时,通过对魔搭社区的MCP广场的接入,不断扩展其应用范围和能力。本文将介绍如何通过通义灵码+魔搭MCP实现低代码、高效率的AI应用构建,实现一站式应用开发与部署流程。

01.魔搭MCP广场及通义灵码MCP集成

魔搭MCP广场

魔搭MCP广场提供了中文开源社区最丰富的MCP服务,目前上线了3000多种MCP服务器,涵盖搜索、地图、文件系统、开发者工具等最热门领域。魔搭也提供简单易上手的工具和调试环境MCP实验场,让开发者在1分钟内就能搭建好自己需要的复杂MCP服务。魔搭上的这些MCP服务支持云上托管或本地部署,且均可开放被集成至第三方平台,大大降低开发者使用MCP服务的门槛。

点击链接查看详情:

https://modelscope.cn/mcp

通义灵码集成魔搭MCP广场

通义灵码目前已经具备多文件代码修改和MCP工具使用的能力,可以与开发者协同完成AI应用的开发任务,比如网页搜索、代码生成、需求实现、问题解决、单元测试用例生成、批量代码修改、代码上传部署等。

02.魔搭创空间部署

ModelScope的创空间(Studio)提供了自由灵活的AI应用展示和部署空间。我们可以使用ModelScope平台自行搭建与展示基于Gradio或Streamlit的AI应用,包括自定义的模型输入输出,多模型的组合,以及可视化交互展现形式等等。同时,创空间平台支持xGPU的部署形态, 为开发者提供了免费的多种类型GPU资源,提供了根据用户实时请求,进行实时GPU资源调度的能力。

03.具体开发流程

环境配置

在魔搭测试MCP服务

首先,我们可以在魔搭的MCP实验场测试需要的MCP服务

地址:https://www.modelscope.cn/studios/modelscope/mcp-playground

AI应用开发中推荐的MCP服务:

-

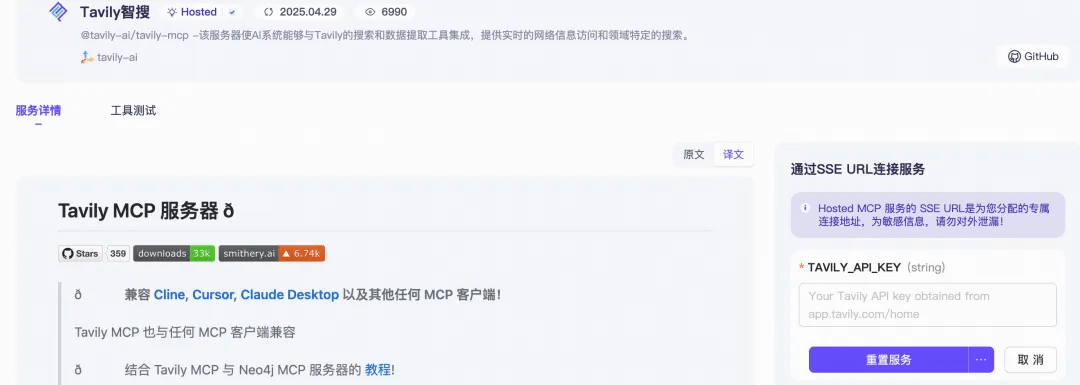

搜索服务(如Tavily智搜):解决直接AI生成的代码框架不可用、环境配置、运行版本等问题多的问题。使用Tavily智搜让AI系统能够与Tavily的搜索和数据提取工具集成,提供实时的网络信息访问和代码的搜索。

-

UI组件(如21st.dev):解决直接生成代码时模型不了解“美观”、“现代化”等模糊描述的问题。从自然语言描述生成现代UI组件,以简化UI开发工作流程。

-

文件系统(filesystem):不需要创建文件目录,所有操作由AI完成。文件系统可以进行读写文件、创建/列出/删除目录、移动文件/目录、搜索文件、获取文件元数据等操作。

-

代码仓库管理(github):自动化管理代码仓库,避免代码丢失、github push不上去等多种问题,应对多版本合作开发场景。可以做到自动分支创建(在创建/更新文件或推送更改时,如果分支不存在则会自动创建)、全面的错误处理(针对常见问题提供清晰的错误信息)、Git 历史记录保留(操作过程中保持 Git 历史记录,不会强制推送)等

测试流程(以Tavily智搜为例):

-

进入tavily官网(https://tavily.com),获取访问API

-

进入魔搭MCP广场,点击Tavily智搜,填写API后点击

去试验场试用

|

|

-

在MCP试验场中会自动提供调用MCP工具的prompt示例,我们可以选择示例进行测试,测试中我们可以根据大模型的MCP调用提示来判断是否正常运行。

通义灵码配置

-

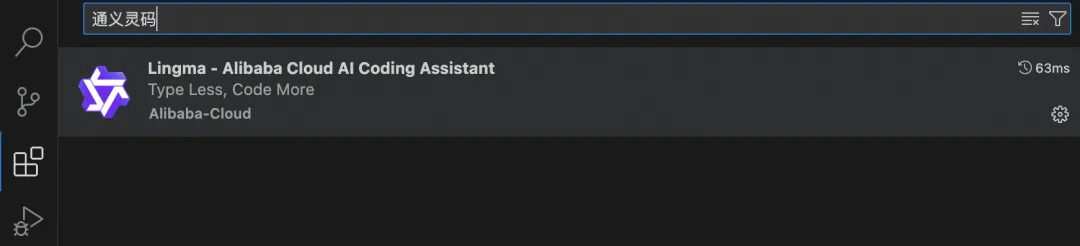

在IDE平台下载通义灵码插件(以vscode为例),在扩展商店搜索“通义灵码”进行安装

-

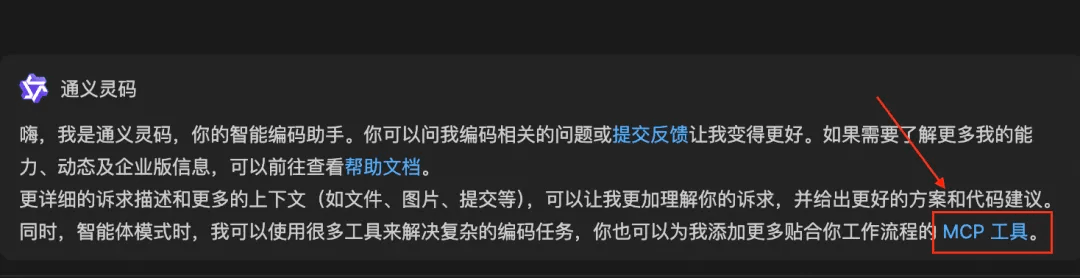

进入通义灵码,选择模式为

智能体来调用MCP服务

-

推荐选择

qwen-thinking模型,方便查看模型调用MCP情况

-

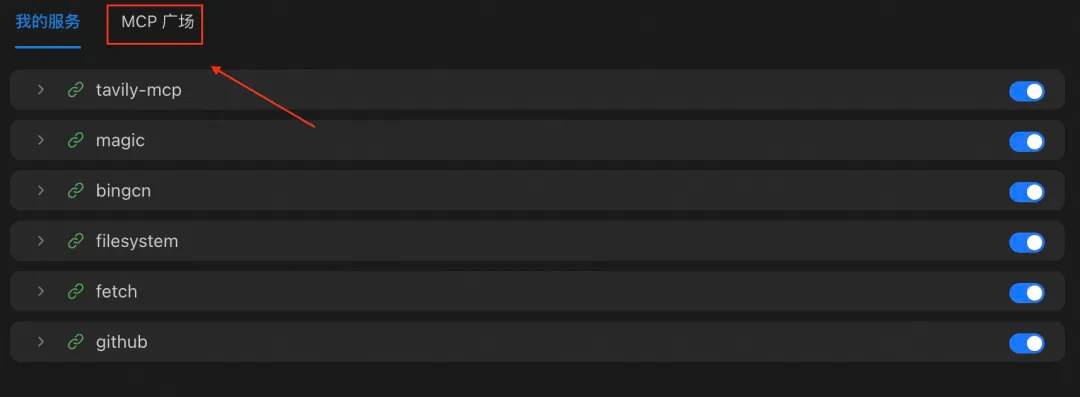

点击

MCP工具→MCP广场填写对应API-KEY后进行进行相关MCP的安装

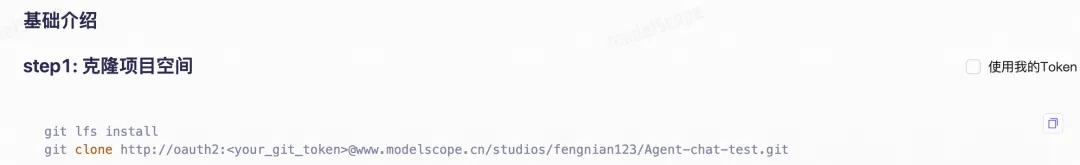

创空间配置

-

在魔搭社区进行创空间创建,选择编程式创建

-

复制step1与step3的命令行代码,以便后续通义灵码进行处理

获取模型调用API

在魔搭的模型库中选择合适的模型,点击右下角的“查看代码范例”,复制对应的API-Inference代码(或者使用模型的下载运行代码用于本地部署)

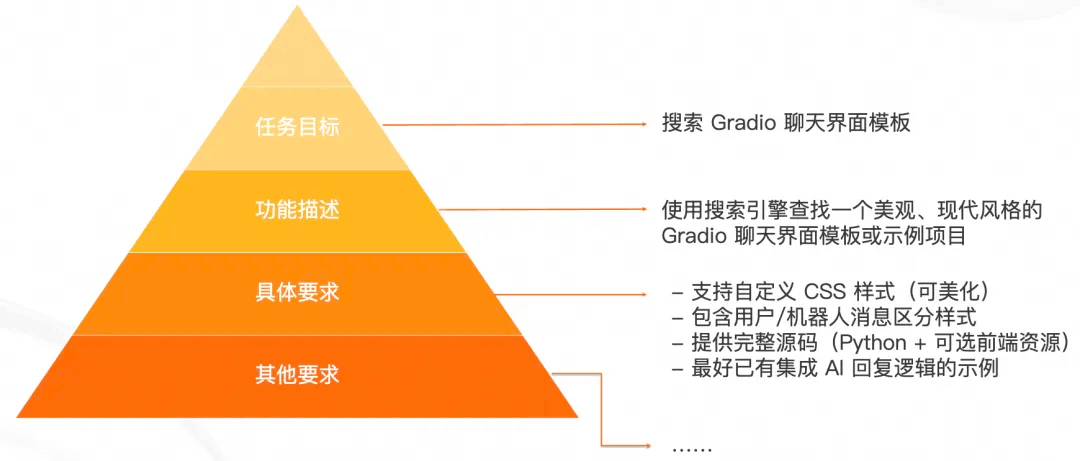

代码框架提示词编写

使用如下的提示词,主要包括任务目标、功能描述、具体要求、其他要求等:

以AI聊天Agent为例,示例提示词如下(在具体使用时可以修改需求以及提供给通义灵码的代码):

请按照以下分步指令完成任务:

1. **搜索 Gradio 聊天界面模板**

- 使用搜索引擎查找一个美观、现代风格的 **基于Gradio的聊天Agent界面模板或示例项目**,要求:

- 支持自定义 CSS 样式(可美化)

- 包含用户/机器人消息区分样式

- 提供完整源码(Python + 可选前端资源)

- 最好已有集成 AI 回复逻辑的示例

2. **本地文件创建**

- 在当前文件夹创建以下结构:

```

ai_chat_template_new/

├── app.py # Gradio应用主代码(整合模板+魔搭API)

├── static/ # 存放CSS/图片等静态资源(如有)

├── README.md # 项目说明文件

└── requirements.txt # 包含 gradio, requests 等依赖

```

- 将找到的 Gradio 示例项目核心代码复制到 `app.py` 中。

3. **集成魔搭社区 API 调用示例**

- 查找如何使用魔搭社区提供的 API 进行 AI 聊天的相关示例或文档。重点关注以下方面:

- API 认证机制(如 API Key)

- 发起请求的方式(GET/POST 请求)

- 数据格式(JSON)

- 错误处理及响应解析

- 根据找到的示例,修改 `app.py` 中的聊天函数(例如 `chatbot_response` 或 `respond`),使其通过魔搭 API 发送用户消息并接收 AI 响应。

示例API Inference:

from openai import OpenAI

client = OpenAI(

base_url='https://api-inference.modelscope.cn/v1/',

api_key='9b16f530-adcd-4711-a998-2**********d', # ModelScope Token

)

# set extra_body for thinking control

extra_body = {

# enable thinking, set to False to disable

"enable_thinking": True,

# use thinking_budget to contorl num of tokens used for thinking

# "thinking_budget": 4096

}

response = client.chat.completions.create(

model='Qwen/Qwen3-235B-A22B', # ModelScope Model-Id

messages=[

{

'role': 'user',

'content': '9.9和9.11谁大'

}

],

stream=True,

extra_body=extra_body

)

done_thinking = False

for chunk in response:

thinking_chunk = chunk.choices[0].delta.reasoning_content

answer_chunk = chunk.choices[0].delta.content

if thinking_chunk != '':

print(thinking_chunk, end='', flush=True)

elif answer_chunk != '':

if not done_thinking:

print('\n\n === Final Answer ===\n')

done_thinking = True

print(answer_chunk, end='', flush=True)

4. **Gradio 界面定制与集成**

- 修改 `app.py` 实现以下功能:

- 使用 Gradio 的 `Blocks` 或 `ChatInterface` 构建聊天界面

- 若有额外 CSS,引入至 Gradio 应用中(支持主题美化)

- 添加基础对话功能(用户输入 → 调用魔搭 API → 显示回复 → 历史记录)

5. **GitHub 仓库创建**

- 在 GitHub 上创建一个新仓库,要求:

- 仓库名称:`ai-chat-template_new`

- 描述:包含关键词 `"AI Chat Template"`, `"Gradio Integration"`, `"ModelScope API"`

- 添加 `.gitignore`, `LICENSE`, `README.md` 等标准开发文件

6. **代码验证**

- 执行以下验证步骤:

- 运行 `python3 app.py` 验证 Gradio 服务能否正常启动

- 测试是否能成功调用魔搭 API 并显示回复

- 确保 UI 美观且交互流畅(包括移动端适配)

- 确保所有文件符合 GitHub 项目规范

7. **魔搭创空间部署**

- 执行以下步骤:

- 新建一个文件夹,复制ai_chat_template的所有内容

- 克隆项目空间:

git lfs install

git clone http://oauth2:<your_git_token>@www.modelscope.cn/studios/fengnian123/Agent-chat-test.git

- 提交文件:

git add .

git commit -m "Add application file"

git push通义灵码执行过程

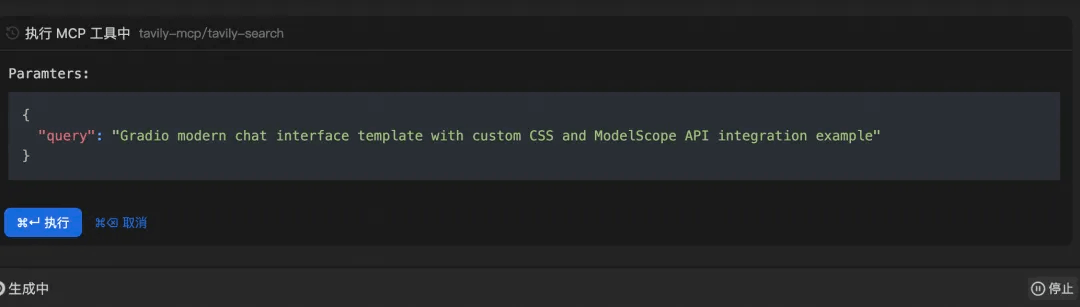

-

在调用MCP的每一步,通义灵码会给出调用情况并询问是否执行

-

可以通过模型的思考链看到指令运行情况,从而调整提示词以及运行过程

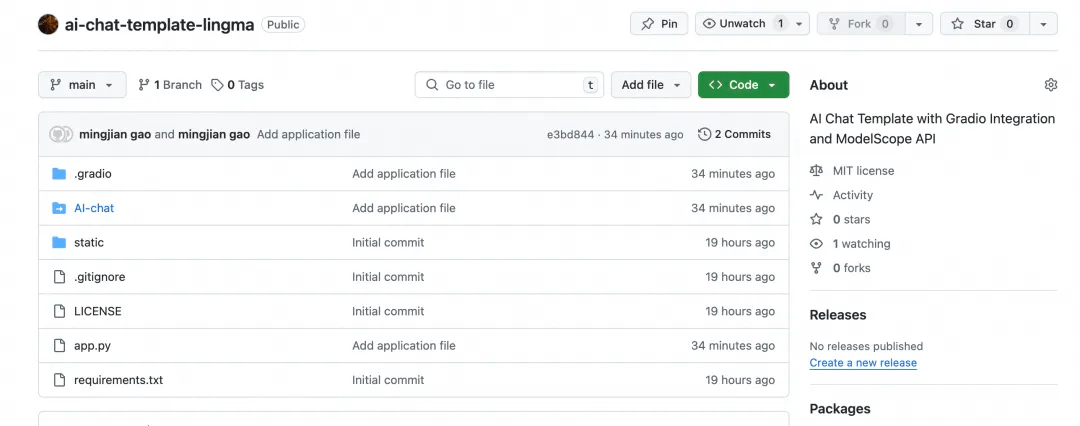

05.结果展示

在经过通义灵码的任务处理之后,我们可以查看执行的结果

-

创空间构建:可以看到,通义灵码完成了基本的代码要求,完成了界面生成以及API调用,并且将我们的代码部署在创空间平台

-

github上传:在github仓库中,通义灵码为我们创建了新的代码仓库,并且已经将代码完成上传,符合预期效果

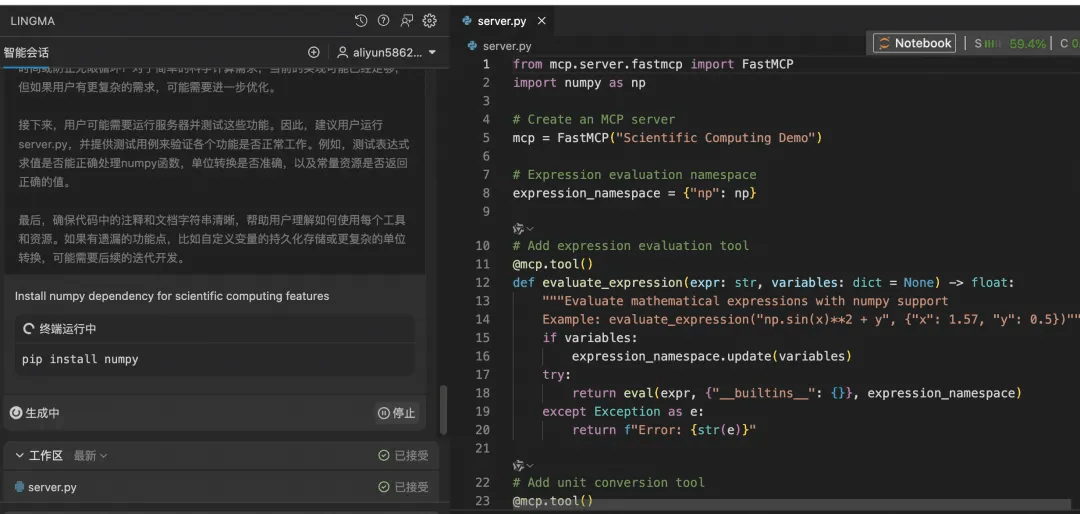

06.扩展:使用通义灵码快速开发并配置个人专属MCP

我们可以使用通义灵码快速构建自己的专属 MCP

-

首先,找到MCP代码的官方示例(https://github.com/modelcontextprotocol/python-sdk)复制我们需要的MCP功能代码(可以找到功能方向大致相同的示例代码)

-

将示例代码与个人需求提交给通义灵码进行代码生成(以Quickstart代码为例,做一个科学计算器):

# server.py

from mcp.server.fastmcp import FastMCP

# Create an MCP server

mcp = FastMCP("Demo")

# Add an addition tool

@mcp.tool()

def add(a: int, b: int) -> int:

"""Add two numbers"""

return a + b

# Add a dynamic greeting resource

@mcp.resource("greeting://{name}")

def get_greeting(name: str) -> str:

"""Get a personalized greeting"""

return f"Hello, {name}!"

根据上面的代码生成一个用于科学计算的 MCP 服务器,功能:

- 表达式解析

- 支持numpy函数和自定义变量

- 常见单位转换

- 提供常用物理常数、数学常数-

通义灵码生成的

server.py:

-

修改通义灵码配置文件并添加MCP服务

-

找到lingma_mcp.json文件添加如下内容(填入实际的代码文件夹路径):

{

"mcpServers": {

"science_compute": {

"command": "/Users/{username}/.local/bin/uv",

"args": [

"--directory",

"/Users/{username}/path_to/code", // 代码文件夹路径

"run",

"server.py" // MCP Server 文件名

]

}

}-

在通义灵码的MCP设置中选择手动添加MCP

-

依据

lingma_mcp.json文件中添加的args配置参数

07.总结

MCP服务基于模型上下文协议(Model Context Protocol),标准化大模型与外部数据源、工具的交互,实现动态调用和安全协作。在魔搭MCP广场目前提供了3000+MCP服务(如支付、多模态工具),通过MCP协议集成AI模型与特定功能,通义灵码可以实现从需求分析到代码生成部署的端到端流程自动化。

快来体验吧!

更多推荐

已为社区贡献663条内容

已为社区贡献663条内容

所有评论(0)