可控文生图:EliGen控制实体的位置细节变化

为文生图模型增加额外的控制条件一直是AIGC社区研究的重点之一,如ControlNet, IP-Adapter等一直是热门可控生成方法。近期,魔搭社区联合浙江大学对实体级可控文生图进行了探索,并开发了

01.引言

为文生图模型增加额外的控制条件一直是AIGC社区研究的重点之一,如ControlNet, IP-Adapter等一直是热门可控生成方法。近期,魔搭社区联合浙江大学对实体级可控文生图进行了探索,并开发了EliGen模型。EliGen可以对想要生成的图像中的每个实体的位置和细节进行控制,从而生成具有复杂场景和构图的图像。

EliGen提出了Regional Attention的注意力机制,对扩散模型中的Attention模块进行了通用扩展。同时,基于FLUX和Qwen2-VL,团队构建了500k样本的含有实体级标注的数据集,采用LoRA对EliGen进行了训练。EliGen不仅可以完成实体级的可控文生图任务,还可以对已有图像进行实体级局部重绘。同时,EliGen与社区模型:IP-Adapter、In-Context LoRA等结合,还可以应用在给定风格和角色的实体控制、Logo迁移等场景,具有无限可能。

论文链接:

https://arxiv.org/abs/2501.01097

代码链接:

https://github.com/modelscope/DiffSynth-Studio/tree/main/examples/EntityControl

模型链接:

https://www.modelscope.cn/models/DiffSynth-Studio/Eligen

在线Demo:

https://www.modelscope.cn/studios/DiffSynth-Studio/EliGen

02.EliGen技术方案

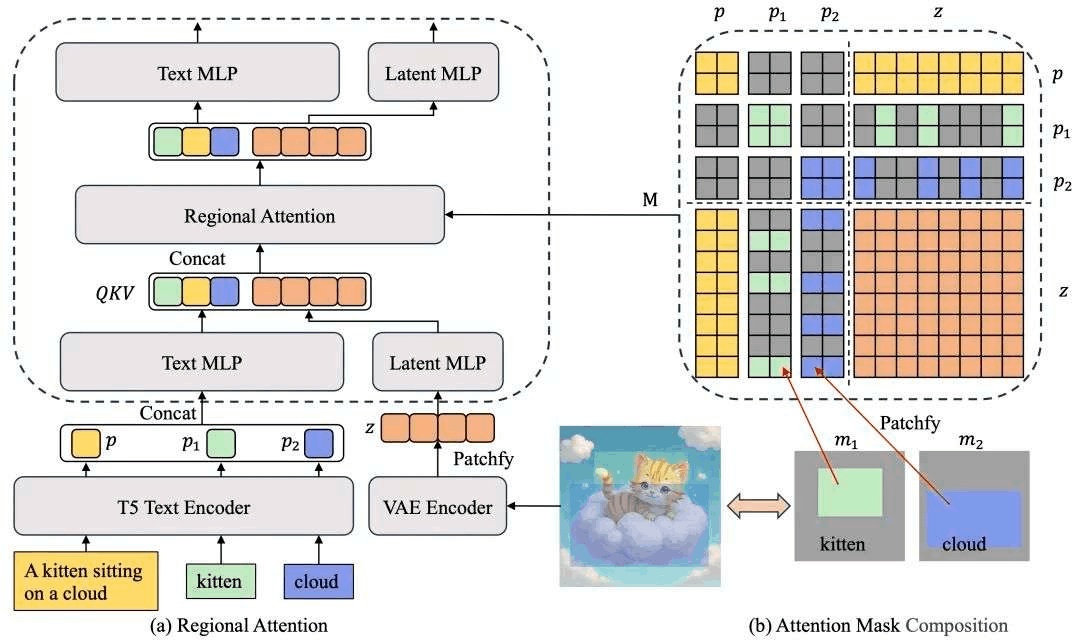

Regional Attention实现

EliGen提出了Regional Attention的机制,对扩散模型的注意力机制进行了扩展,使其支持基于任意形状空间信息的实体级控制。我们采用结构化文本向量来表示条件控制信息,包括描述图像整体内容的全局提示词(global prompt)和描述具体细节的多个局部提示词(local prompts)。每个local prompt都附带一个掩码(mask),用于表示其生成区域。基于这些mask,我们针对实体内、实体间和实体与图像的关系构建了attention mask,保证了每个实体的token序列只作用于特定区域。

训练数据生成和模型训练

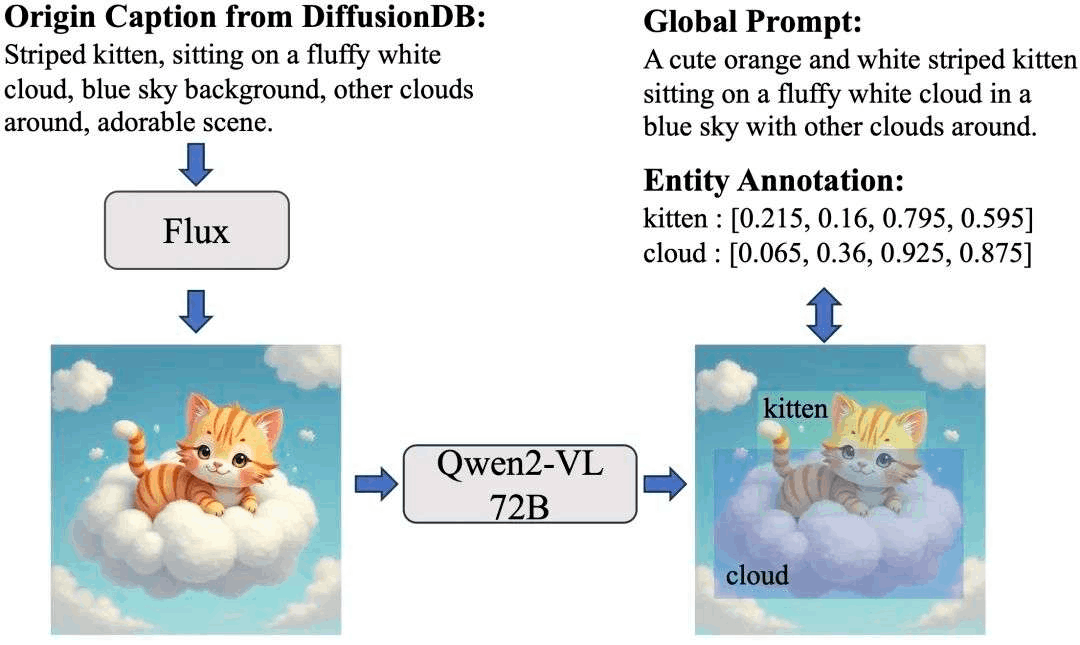

使用Regional Attention对模型进行扩展后,可以发现它不经过训练也能改变某些区域的实体属性,比如颜色。但是未经训练的模型无法控制图像的布局。为了激活EliGen的空间控制能力,我们构建了带实体标注的数据集,采用LoRA,对实体控制任务进行了特化训练。

如下图所示,我们从DiffusionDB数据集的文本Prompt出发,使用FLUX.1-dev生成了500k训练图像。进一步,利用Qwen2-VL 72B的强大图像理解和grounding能力,对训练样本进行了重描述 (recaption),同时对图像中的实体的语义和位置信息进行了标注。

最终,经过训练,EliGen模型具有出色的实体级位置和细节控制能力,图像生成质量远超同类模型,在许多场景都有应用的潜力。

03.应用场景

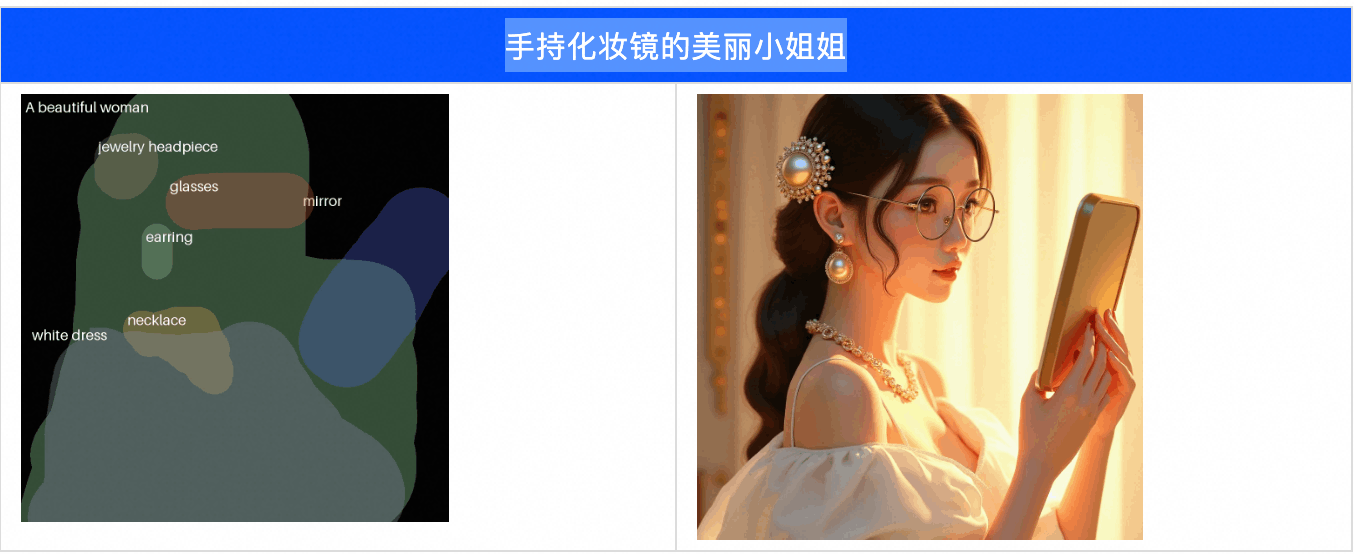

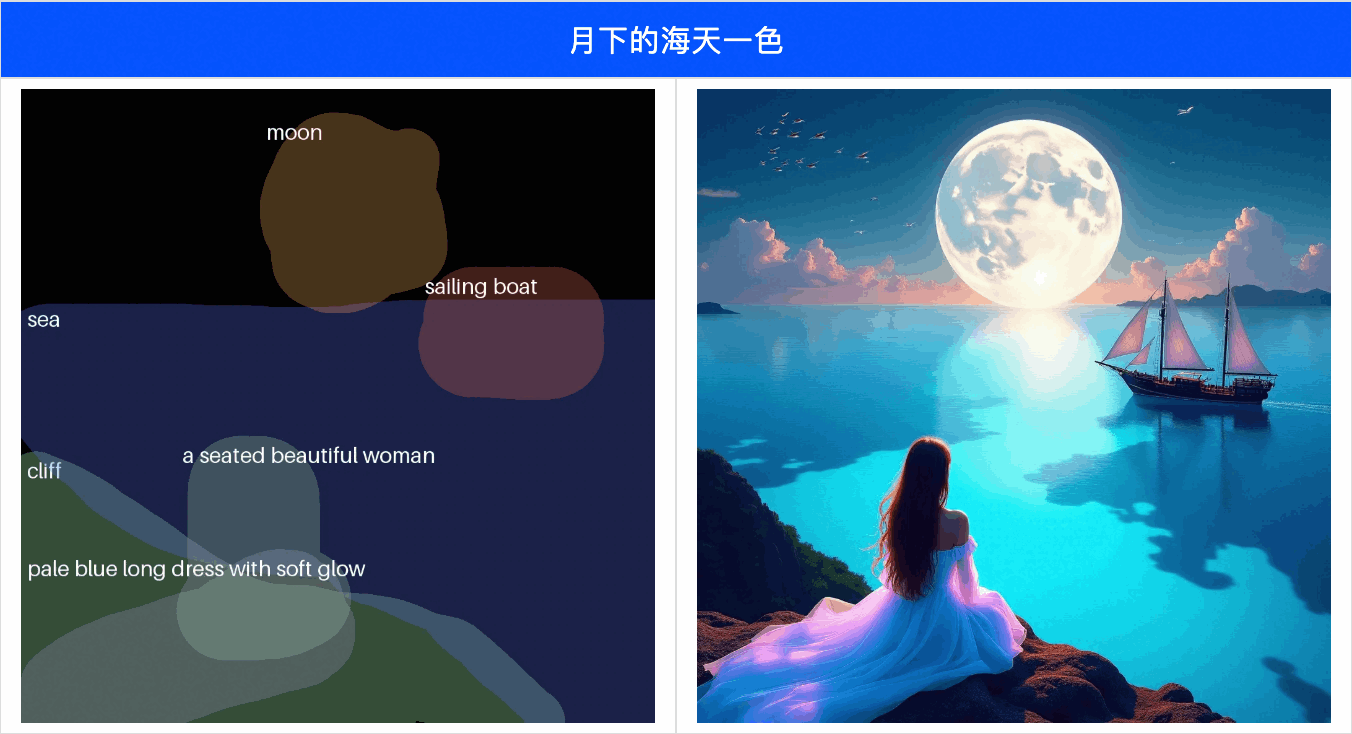

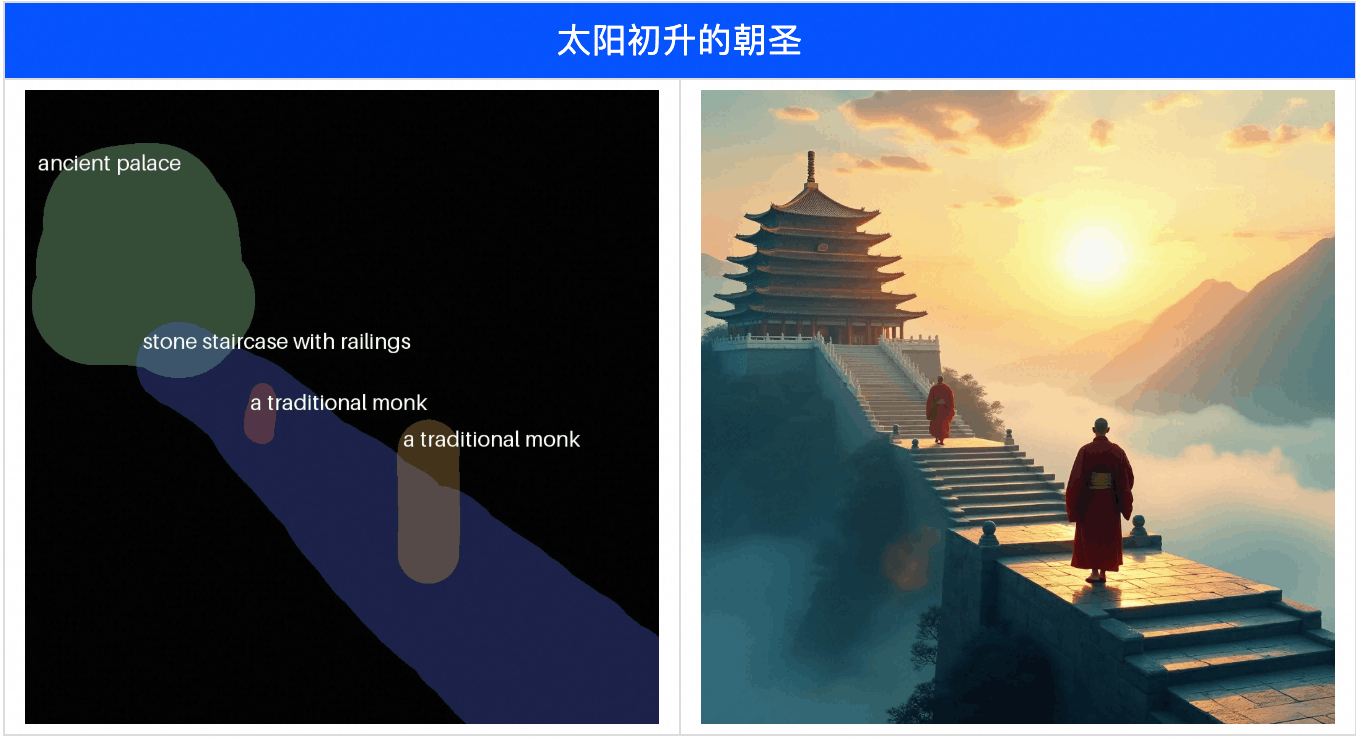

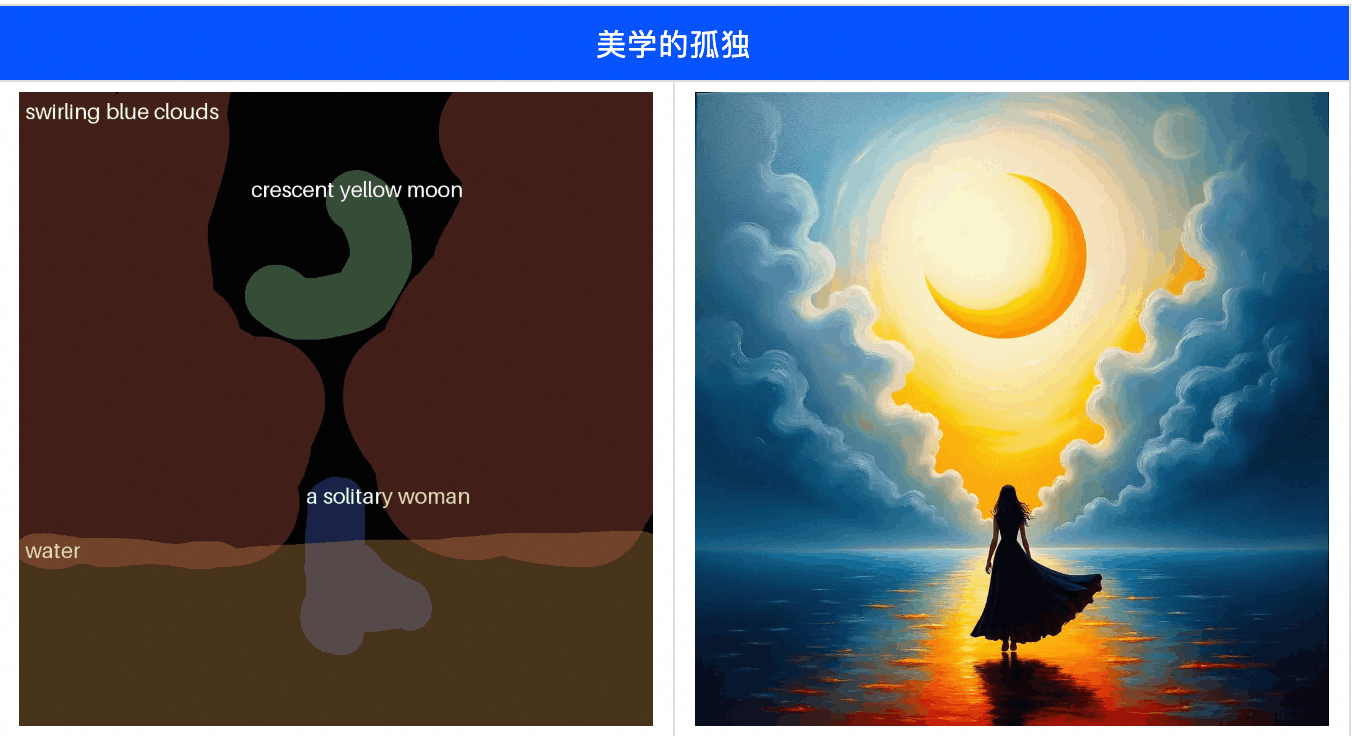

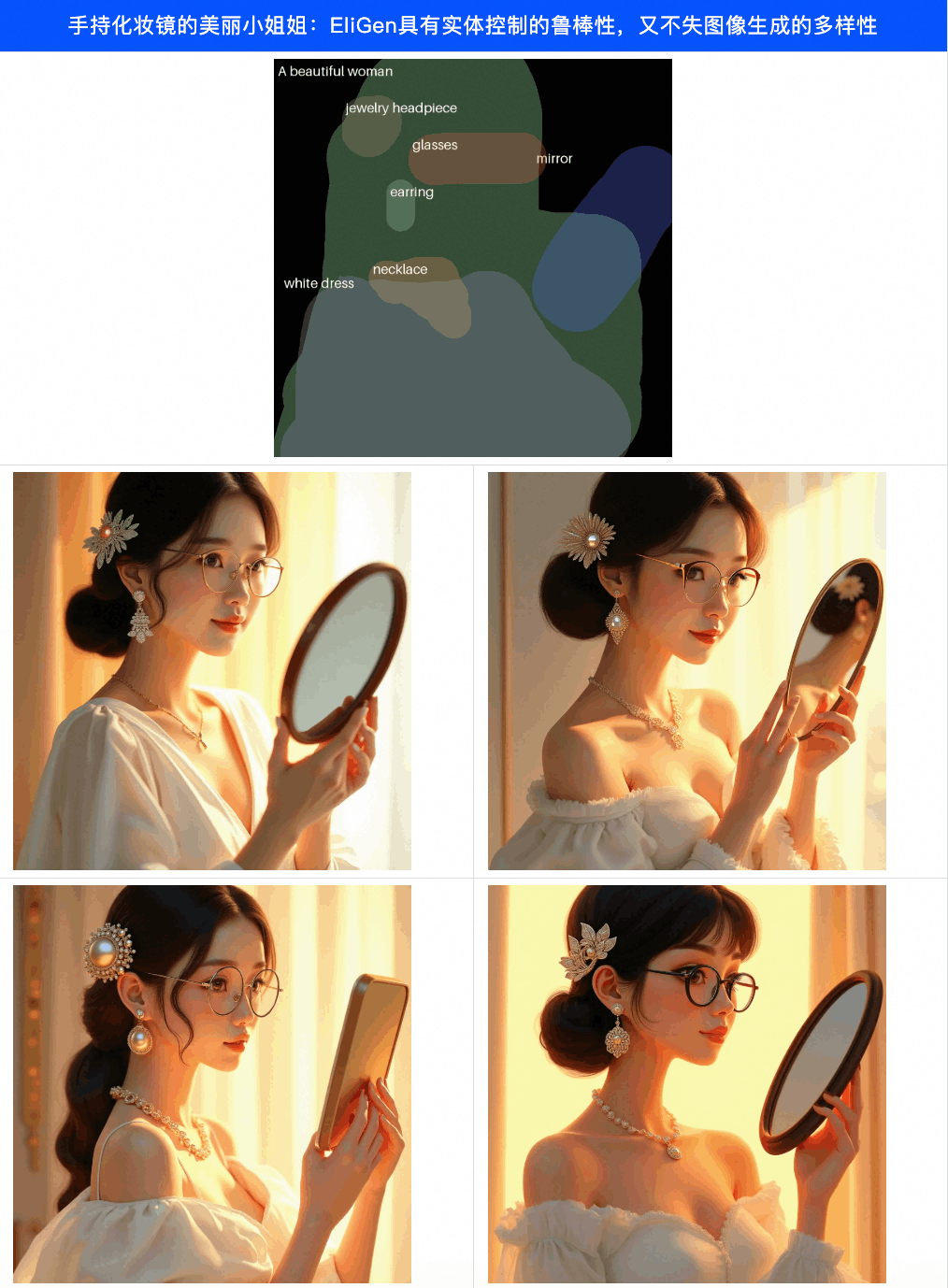

复杂构图的实体级构建

代码:

https://github.com/modelscope/DiffSynth-Studio/blob/main/examples/EntityControl/entity_control.py

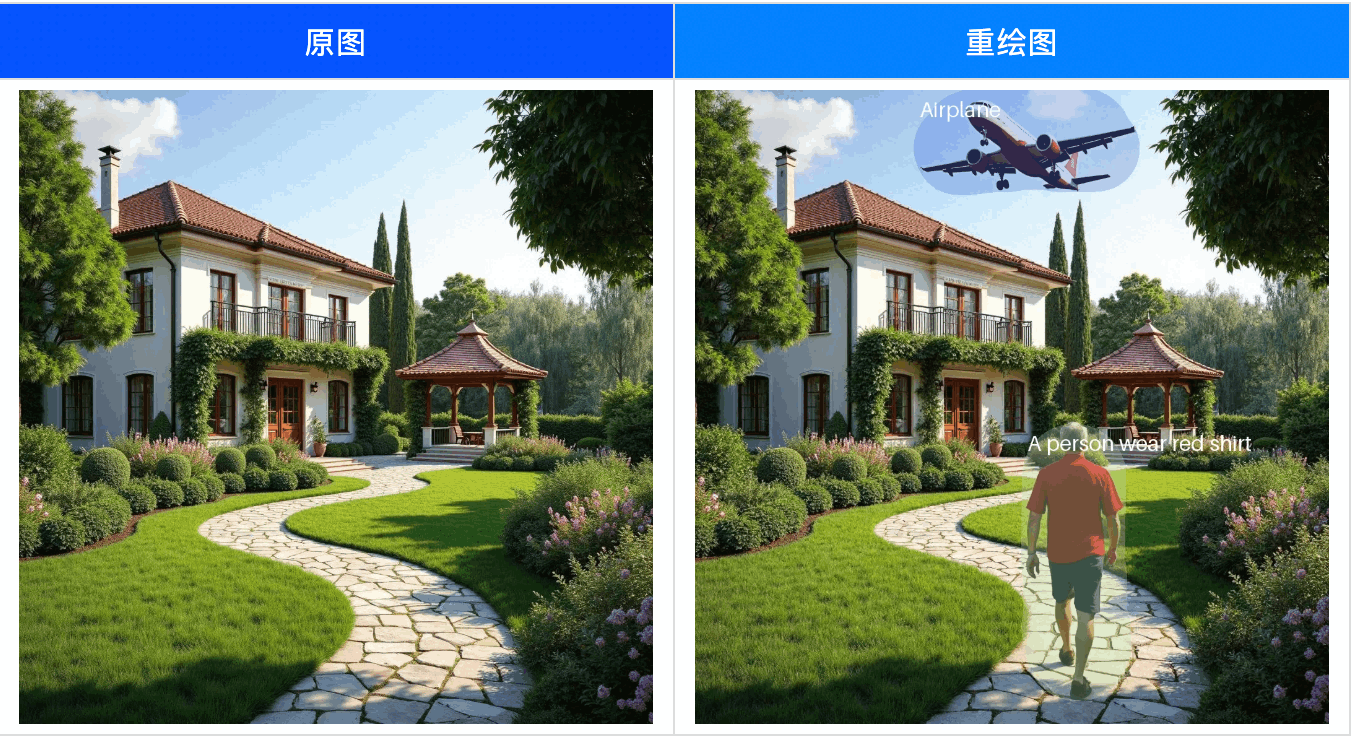

图像局部重绘

代码:

https://github.com/modelscope/DiffSynth-Studio/blob/main/examples/EntityControl/entity_inpaint.py

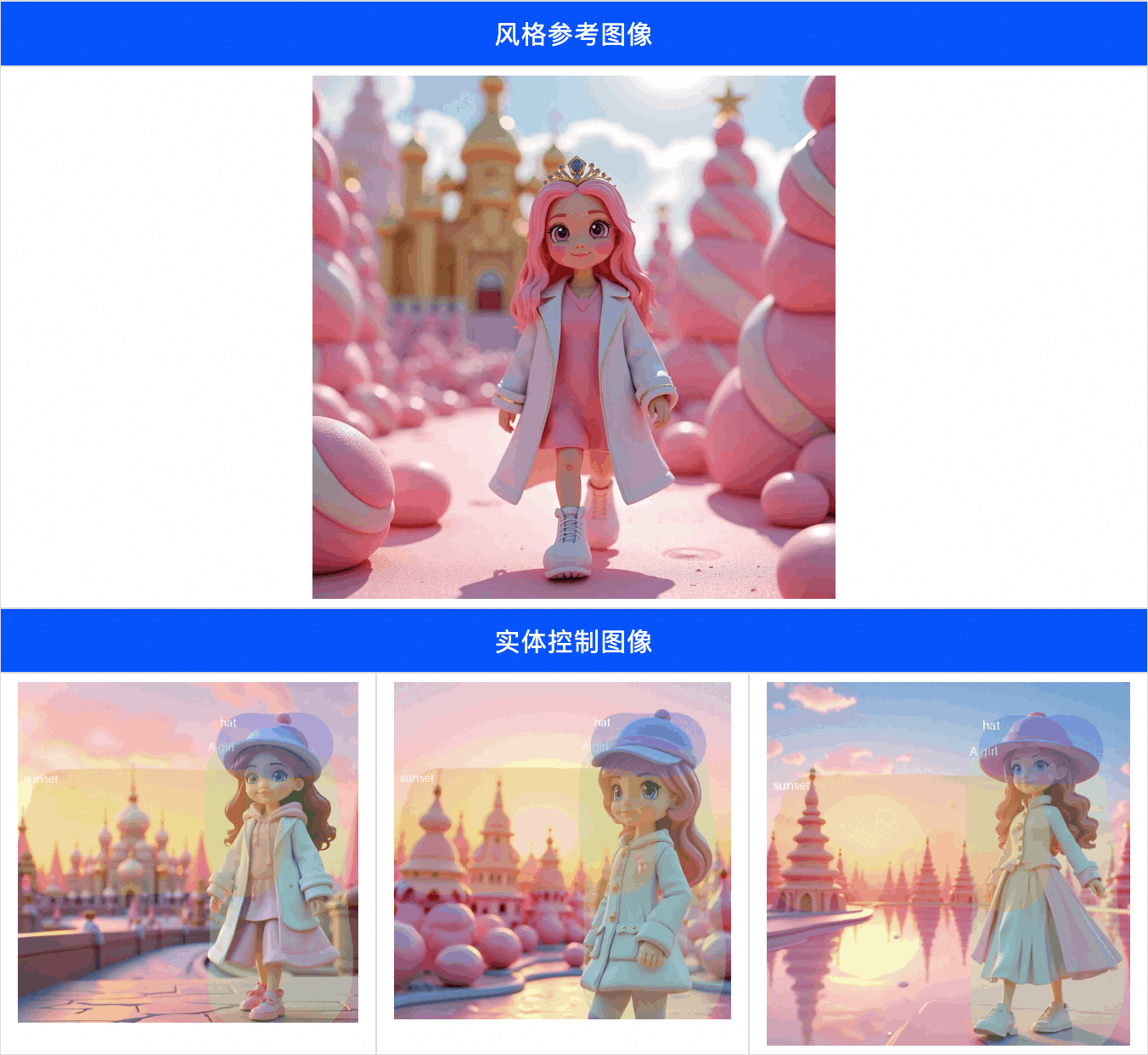

特定风格的实体控制

代码:

https://github.com/modelscope/DiffSynth-Studio/blob/main/examples/EntityControl/entity_control_ipadapter.py

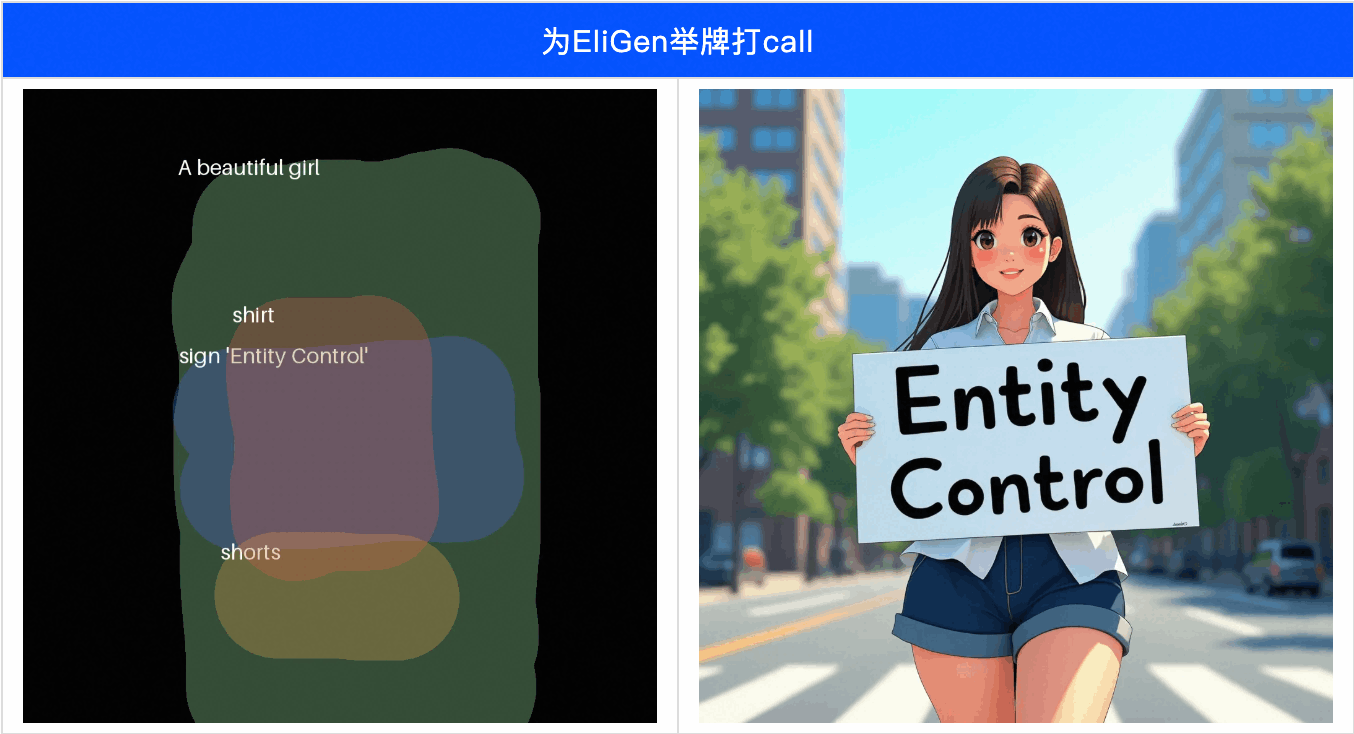

Logo迁移

代码:

https://github.com/modelscope/DiffSynth-Studio/blob/main/examples/EntityControl/entity_transfer.py

点击链接链接阅读原文,即可跳转模型~

更多推荐

已为社区贡献653条内容

已为社区贡献653条内容

所有评论(0)