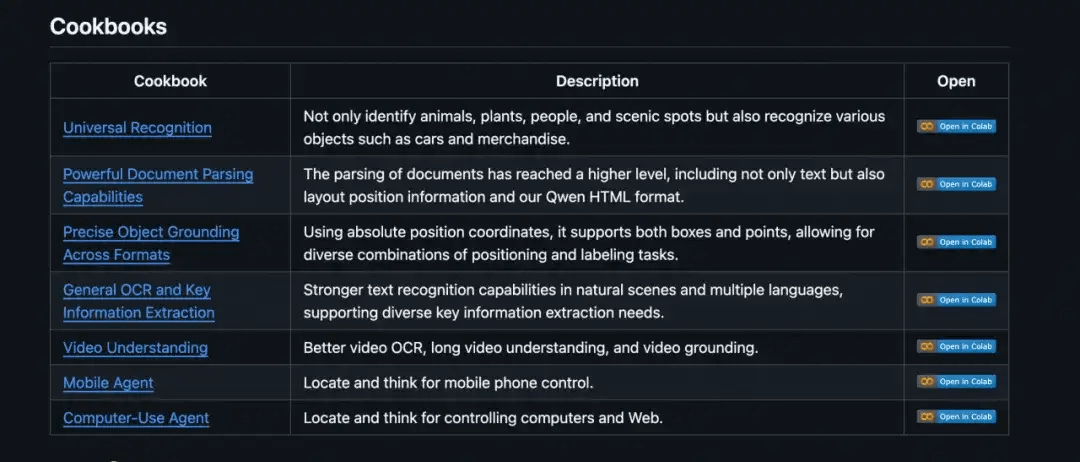

Qwen2.5-VL Cookbook来啦!手把手教你怎么用好视觉理解模型!

今天,Qwen团队发布了一系列展示 Qwen2.5-VL 用例的Notebook,包含本地模型和 API 的使用。

今天,Qwen团队发布了一系列展示 Qwen2.5-VL 用例的Notebook,包含本地模型和 API 的使用。期望这些示例能够帮助开发者和用户更全面地了解 Qwen2.5-VL 的强大视觉理解功能,并激发更多创新的应用场景。

通过这些 Notebook,开发者可以快速上手并体验模型在多种任务中的优秀表现,无论是处理复杂的文档解析、精准的 OCR 任务,还是深入的视频内容理解,Qwen2.5-VL 都能提供高效且准确的回复。同时,也期待社区的反馈与贡献,共同完善和拓展 Qwen2.5-VL 的能力边界。

🔗 链接:

https://github.com/QwenLM/Qwen2.5-VL/tree/main/cookbooks

💬 体验地址:

https://chat.qwenlm.ai (选择Qwen2.5-VL-72B-Instruct模型)

🤖 模型链接:https://www.modelscope.cn/collections/Qwen25-VL-58fbb5d31f1d47

⚙️ 百炼 API : https://help.aliyun.com/zh/model-studio/user-guide/vision/

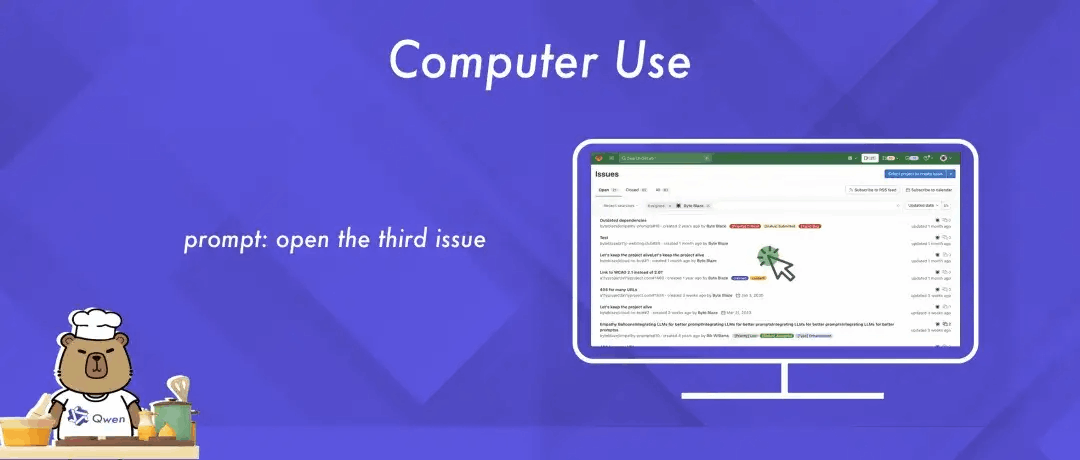

01 .Computer Use

这个 Notebook 展示了如何使用 Qwen2.5-VL 进行Computer Use 相关任务。

截取用户桌面的屏幕截图并接收一个用户的查询,然后利用模型对截图中的用户查询进行解释,并形成在桌面的精准点击或者输入等操作,从而控制电脑的使用。

👉https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/computer_use.ipynb

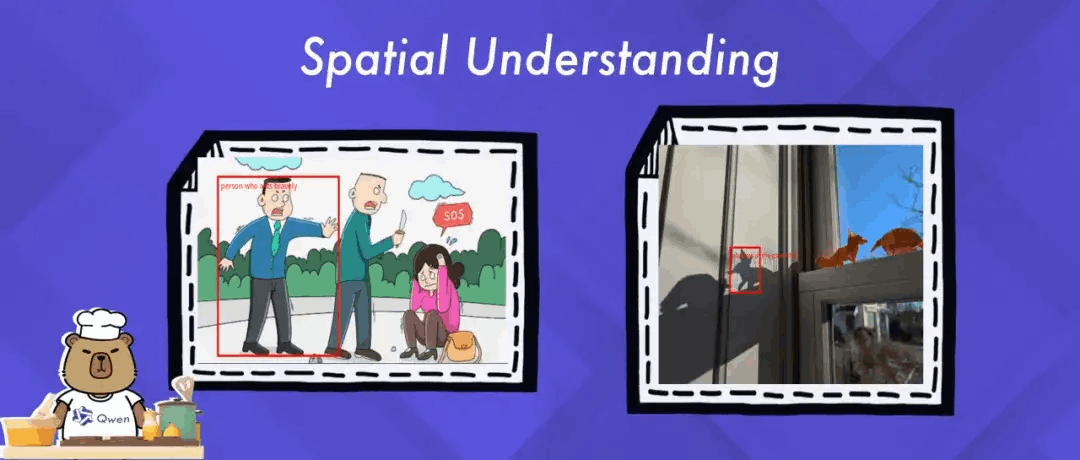

02 空间理解

这个 Notebook 展示了 Qwen2.5-VL 先进的空间定位能力,包括精确的物体检测和图像中特定目标的定位。

看看它是如何整合视觉和语言理解,从而有效地解读复杂场景的。

👉https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/spatial_understanding.ipynb

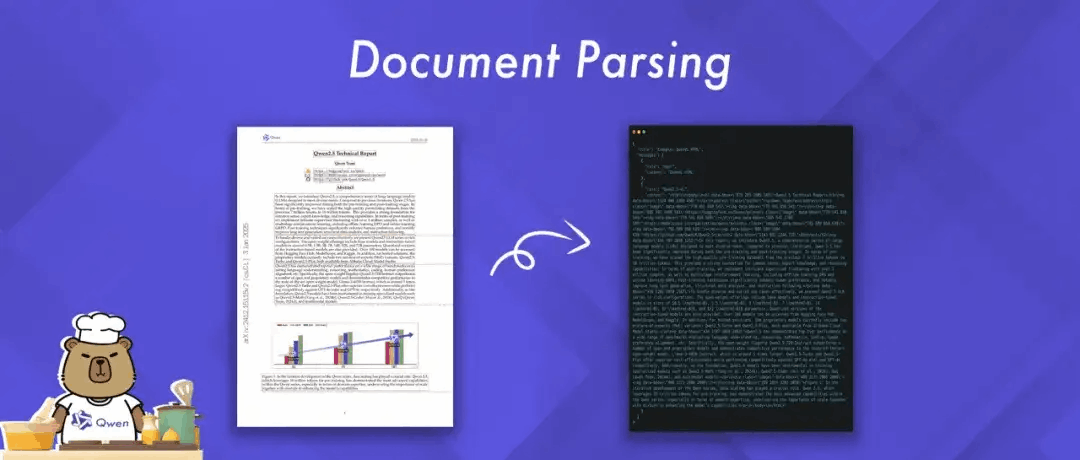

03 文档解析

这个 Notebook 展示了 Qwen2.5-VL 强大的文档解析能力。它可以处理任何图像,并以多种格式输出其内容,如 HTML、JSON、MD和LaTeX。

特别值得一提的是,Qwen引入了一种独特的 QwenVL HTML 格式,该格式包含每个组件的位置信息,从而实现精确的文档重建和操作。

👉https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/document_parsing.ipynb

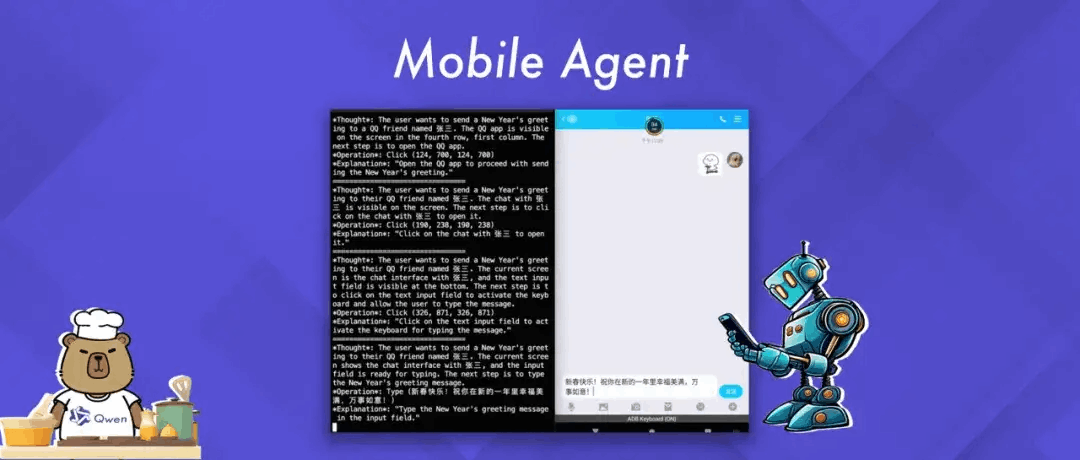

04 Mobile Agent

这个 Notebook 展示了如何使用 Qwen2.5-VL 的代理功能调用能力与移动设备进行交互。

它展示了模型根据用户查询和视觉上下文生成并执行操作的能力。

👉https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/mobile_agent.ipynb

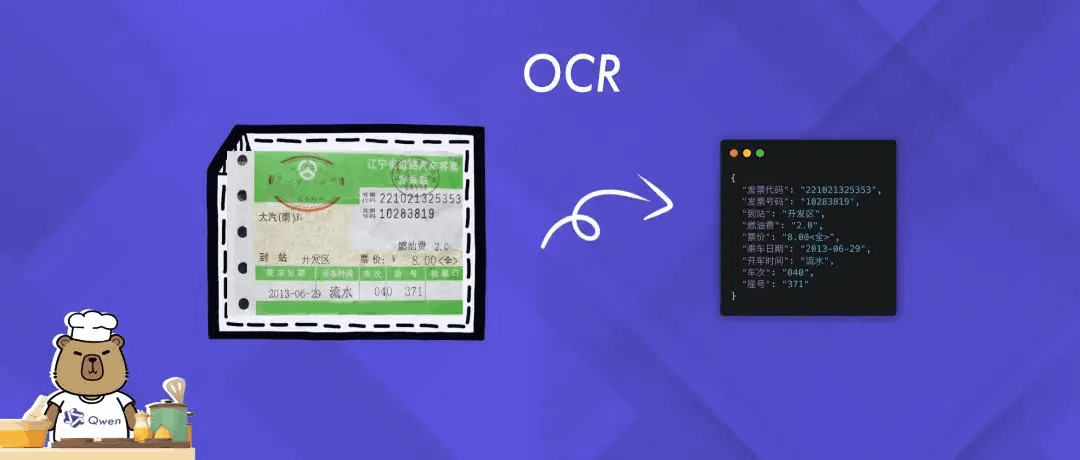

05 OCR

这个 Notebook 展示了 Qwen2.5-VL 的 OCR(光学字符识别)能力,包括从图像中提取和识别文本。

看看Qwen2.5-VL如何在复杂场景下准确捕捉和解读文本内容。

👉https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/ocr.ipynb

06 万物识别

这个 Notebook 展示了如何使用 Qwen2.5-VL 进行通用识别。

它接收一张图像和一个查询,然后利用模型对图像中的用户查询进行解释。

👉https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/universal_recognition.ipynb

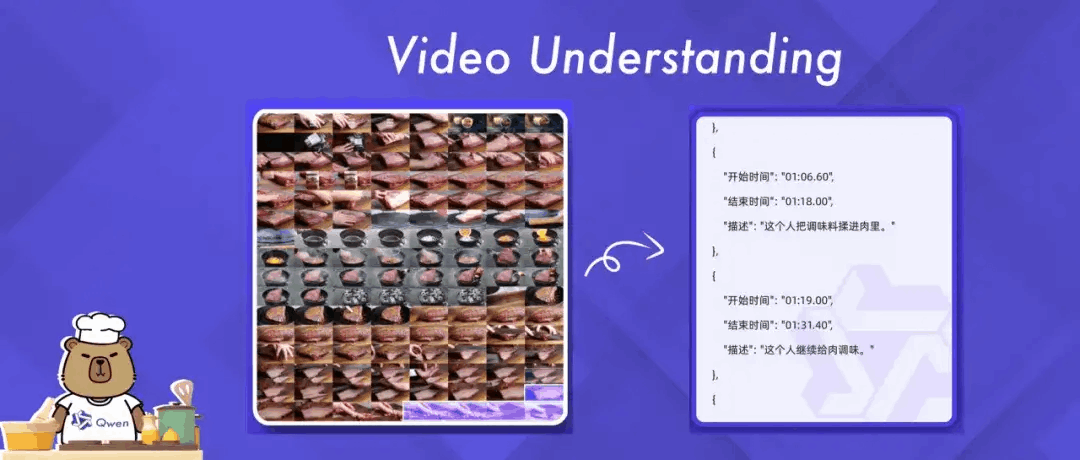

07 视频理解

Qwen2.5-VL 能够理解超过1小时的视频。在这个Notebook 中,将深入探讨 Qwen2.5-VL 模型在视频理解任务中的能力。

Qwen2.5-VL的目标是展示这个先进模型如何应用于各种视频分析场景,从基础的 OCR(光学字符识别)到复杂的事件检测和总结。

👉https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/video_understanding.ipynb

魔搭最佳实践

在魔搭社区的免费算力上,就可以玩转这些Cookbook哦。

首先,下载Qwen2.5-VL代码:

git clone https://github.com/QwenLM/Qwen2.5-VL.gitNotebook中使用模型API:魔搭平台的API-Inference,提供了免费的Qwen2.5-VL系列模型API。魔搭的用户可通过API调用的方式直接使用,直接替换Cookbook中的base-URL和填写魔搭SDK Token即可。文档:https://www.modelscope.cn/docs/model-service/API-Inference/intro

from openai import OpenAI

client = OpenAI(

api_key="<MODELSCOPE_SDK_TOKEN>", # ModelScope Token

base_url="https://api-inference.modelscope.cn/v1"

)

response = client.chat.completions.create(

model="Qwen/Qwen2.5-VL-72B-Instruct", # ModleScope Model-Id

messages = [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": "https://modelscope.oss-cn-beijing.aliyuncs.com/demo/images/bird-vl.jpg"}

},

{ "type": "text",

"text": "Count the number of birds in the figure, including those that are only showing their heads. To ensure accuracy, first detect their key points, then give the total number."

},

],

}

],

stream=True

)Notebook使用本地模型,请选择GPU机型。

欢迎体验

未来,Qwen团队将持续更新和扩展这些示例,加入更多实用的功能和场景,确保开发者们能找到适合自己需求的解决方案。欢迎您访问 GitHub 仓库或相关平台,尝试这些 Notebook,并分享您的使用心得和创新应用!快来和Qwen一起Cook吧!

更多推荐

已为社区贡献663条内容

已为社区贡献663条内容

所有评论(0)