Qwen2来了

级别二:为了减少 因关键词重叠度不足导致的 上下文错过 的问题,用LLM来判断块和query的相关度,用相关块的相关句子 而不是 query当中的 关键词来检索 最相关的块。级别一:先用LLM来对user query进行“信息”和“指令”的抽取,然后用LLM对信息进行翻译,多语言的角度用BM25来提取相关块…「大量精力:如何扩展多语言预训练 和指令微调数据的规模并提升质量,提升模型的多语言能力」级

变化

1、增大了上下文长度支持,Qwen2-72B-Instruct支持128K tokens,并且处理完美

2、代码和数学能力显著提升

3、多个评测基准上的领先表现

4、中英之外增加了27种语言相关的高质量数据

5、开源了Agent解决方案,用于高效处理 1000K tokens的上下文

「大量精力:如何扩展多语言预训练 和指令微调数据的规模并提升质量,提升模型的多语言能力」

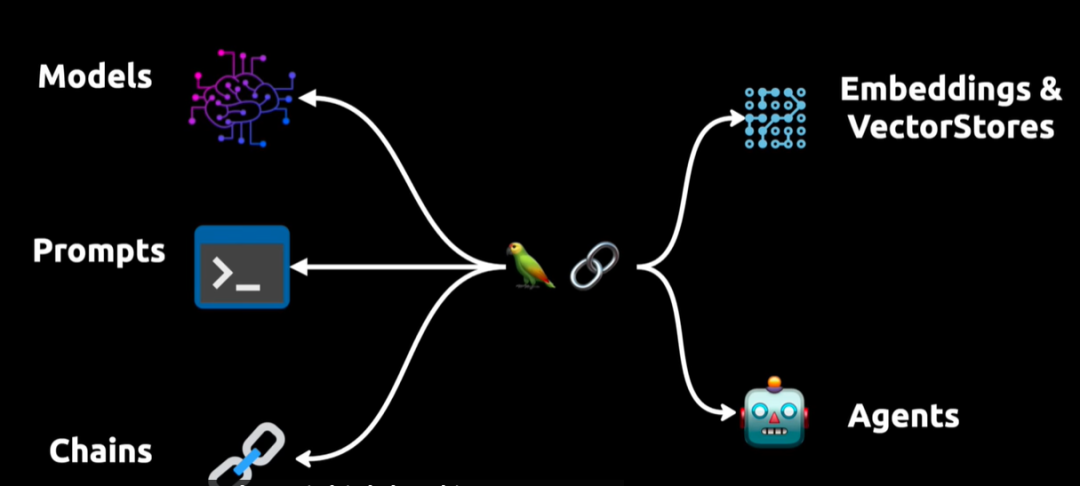

Agent 应用

核心:通过分块+能处理8K上下文的LLM 不断总结归纳,来解决1000K上下文的理解任务。

方案:构建三个级别的Agent,这一部分建议详读,很不错。

级别一:先用LLM来对user query进行“信息”和“指令”的抽取,然后用LLM对信息进行翻译,多语言的角度用BM25来提取相关块…

级别二:为了减少 因关键词重叠度不足导致的 上下文错过 的问题,用LLM来判断块和query的相关度,用相关块的相关句子 而不是 query当中的 关键词来检索 最相关的块。

级别三:另外训练一个用于规划的LLM,用级别二的llm作为tool,实现逐级推理

基础

GQA

作用:推理加速、降低显存占用

tie embedding

场景:针对7B以下的小模型,比如0.5B、1.5B的

作用:让输入和输出层共享参数,增加非embedding参数的占比

长文本处理

YARN

Dual Chunk Attention

开源生态

一些数字

期待

期待QwenVL开源版本的更新

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)